El ecosistema de la inteligencia artificial generativa suma un nuevo actor destacado. Se llama Z-Image, es open source, cuenta con 6.000 millones de parámetros y llega con una promesa clara: ofrecer calidad de imagen de primer nivel con una eficiencia muy superior a la de muchos modelos existentes, tanto en coste de cómputo como en velocidad de inferencia. Detrás del proyecto está el equipo de investigación de Tongyi-MAI (Alibaba), que ha publicado el modelo y su paper como base para toda una nueva ola de desarrollos comunitarios.

Lejos de ser un experimento más, Z-Image se presenta desde el inicio en tres variantes bien diferenciadas:

- Z-Image-Turbo, la versión rápida para generación de imágenes.

- Z-Image-Base, el checkpoint “fundacional” pensado para fine-tuning.

- Z-Image-Edit, afinada específicamente para tareas de edición de imágenes a partir de instrucciones en lenguaje natural.

Con este planteamiento, el modelo intenta cubrir desde casos de uso creativos hasta despliegues empresariales y de producto.

Un modelo fundacional de 6.000 millones de parámetros

Z-Image es un modelo de difusión de tipo Transformer (Diffusion Transformer) que trabaja como modelo fundacional de imagen. Su tamaño —unos 6.000 millones de parámetros— lo sitúa en la franja media-alta de la actual generación de modelos, pero con un foco claro en la eficiencia y no solo en “escala bruta”.

Uno de los aspectos más relevantes del proyecto es que, según sus autores, el modelo se ha entrenado únicamente con datos reales, sin recurrir a destilación masiva desde modelos propietarios cerrados de texto-a-imagen. El artículo técnico detalla además el esfuerzo de cómputo necesario para entrenarlo, del orden de centenares de miles de horas de GPU, con un coste estimado de varios cientos de miles de dólares, pero muy por debajo de los presupuestos de otros gigantes de la IA generativa.

Para la comunidad, esto tiene una lectura doble: por un lado, se trata de un modelo competitivo cuyo comportamiento se puede estudiar con transparencia; por otro, marca una referencia clara de coste/beneficio para equipos y empresas que quieran entrenar o afinar sus propios modelos de imagen sin entrar en cifras multimillonarias.

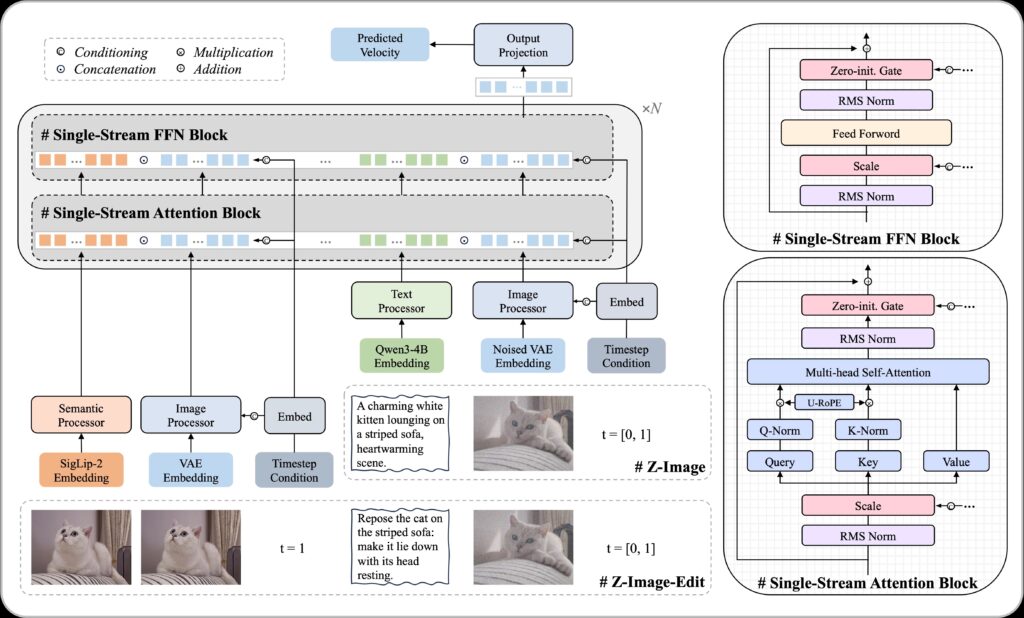

Arquitectura S3-DiT: todo en un único flujo

A nivel técnico, Z-Image adopta una arquitectura denominada Scalable Single-Stream DiT (S3-DiT). En lugar de procesar por separado el texto, los tokens visuales y los tokens de la VAE de imagen, todo se concatena en una única secuencia que entra al Transformer.

Este diseño de “flujo único” tiene varias ventajas:

- Mayor eficiencia de parámetros, al reutilizar la misma red para entender tanto las instrucciones textuales como la representación latente de la imagen.

- Mejor capacidad para razonar sobre la relación texto-imagen, algo clave para respetar instrucciones complejas y para tareas como la edición condicionada.

- Un funcionamiento más sencillo de escalar, que facilita tanto la investigación como la futura aparición de variantes más grandes o más pequeñas del modelo.

El resultado es un modelo de difusión moderno que se integra bien con el ecosistema existente (por ejemplo, a través de Diffusers de Hugging Face) y que puede generar imágenes de alta resolución —como 1.024 × 1.024 píxeles— en unos pocos pasos de inferencia, sin requerir hardware extremo.

Turbo, Base y Edit: tres sabores para distintos casos de uso

El equipo de Z-Image ha optado por lanzar desde el principio tres checkpoints con objetivos distintos:

- Z-Image-Turbo

Es la estrella de la familia en cuanto a uso práctico. Se trata de una versión destilada que funciona en solo 8 pasos de difusión efectivos (8 NFEs), alcanzando latencias de sub-segundo en GPUs de gama empresarial como las H800 y siendo manejable en dispositivos de consumo con 16 GB de VRAM. Está optimizada para:- Imagen fotorealista de alta calidad.

- Renderizado de texto bilingüe (inglés y chino) dentro de la imagen.

- Muy buen cumplimiento de instrucciones complejas.

- Z-Image-Base

Es el modelo fundacional sin destilar, pensado para investigadores y equipos que quieran hacer fine-tuning o desarrollar variantes verticales (por ejemplo, para moda, producto, medicina, etc.). Al liberar este checkpoint, los autores buscan que la comunidad pueda explotar todo el potencial del modelo sin tener que repetir el entrenamiento completo. - Z-Image-Edit

Es la variante ajustada para edición de imágenes. Permite cargar una imagen y aplicar transformaciones a partir de instrucciones en lenguaje natural, con buena comprensión tanto en inglés como en chino. Es especialmente interesante para flujos de trabajo creativos en los que se quiere “retocar” o “reimaginar” una escena sin partir de cero.

Decoupled-DMD y DMDR: la destilación como arma secreta

Buena parte de la eficiencia de Z-Image-Turbo se apoya en un algoritmo de destilación llamado Decoupled-DMD (Decoupled Distribution Matching Distillation). La idea central es separar dos mecanismos que en trabajos anteriores se trataban como un bloque:

- CFG Augmentation (CA), que actúa como el “motor” principal de la destilación.

- Distribution Matching (DM), que funciona como un “escudo” regularizador para mantener la estabilidad y la calidad de las muestras.

Al estudiar estos componentes por separado, el equipo ha podido optimizar mejor el proceso de destilación para pocos pasos de generación, consiguiendo que el modelo destilado mantenga la calidad del modelo base con mucha menos computación por imagen.

Sobre esta base, los autores introducen además DMDR, un enfoque que combina Distribution Matching Distillation con refuerzo (Reinforcement Learning) durante la fase de post-entrenamiento. El objetivo es mejorar aún más:

- La alineación semántica con el prompt.

- La calidad estética de las imágenes.

- La coherencia estructural y el nivel de detalle fino.

Es decir, no se trata solo de acelerar el modelo, sino de usar técnicas de RL para pulir su comportamiento allí donde la pura distilación no llega.

Un ecosistema que mira a la comunidad

Otro elemento clave de Z-Image es que no llega aislado. El proyecto se integra ya con herramientas y librerías populares, y la comunidad está añadiendo capas de soporte:

- Pipeline oficial en Diffusers, con una clase

ZImagePipelinelista para usar, soporte parabfloat16, Flash-Attention y compilación del modelo para acelerar aún más la inferencia. - Soporte en stable-diffusion.cpp, que permite ejecutar Z-Image de forma eficiente incluso en GPUs con tan solo 4 GB de VRAM, acercando el modelo a hardware mucho más modesto.

- Integraciones como Cache-DiT, LeMiCa o nodos para ComfyUI, que facilitan usar Z-Image en flujos visuales sin necesidad de programar.

En las evaluaciones de preferencia humana tipo Elo realizadas en Alibaba AI Arena, Z-Image-Turbo aparece con puntuaciones muy competitivas frente a otros modelos punteros, situándose entre los mejores modelos de imagen open source disponibles actualmente.

Qué supone Z-Image para la IA generativa

Con Z-Image, el mensaje de fondo es claro: se puede construir un modelo potente, abierto y eficiente sin depender de una combinación opaca de datos sintéticos y presupuestos desorbitados. Para empresas, investigadores y desarrolladores, esto abre varias vías:

- Crear verticales especializados (moda, diseño, producto, ilustración técnica…) a partir del checkpoint base.

- Integrar generación y edición de imágenes en productos propios, autoalojados o en la nube, con control directo sobre el modelo.

- Explorar nuevas técnicas de destilación y RL sobre una arquitectura moderna y bien documentada.

En un momento en el que muchos modelos de imagen de referencia son cada vez más cerrados, Z-Image se posiciona como una de las apuestas abiertas más serias para los próximos años.

Preguntas frecuentes sobre Z-Image

¿Qué es exactamente Z-Image y para qué sirve?

Z-Image es un modelo fundacional de generación de imágenes basado en difusión y Transformers. Permite crear imágenes fotorealistas o estilizadas a partir de texto, renderizar texto bilingüe dentro de las imágenes y realizar tareas de edición (image-to-image) siguiendo instrucciones en lenguaje natural.

¿En qué se diferencian Z-Image-Turbo, Z-Image-Base y Z-Image-Edit?

Z-Image-Turbo es la versión destilada y optimizada para velocidad, ideal para productos y despliegues en producción. Z-Image-Base es el modelo completo, pensado para investigación y fine-tuning. Z-Image-Edit está afinado para edición de imágenes, cuando se quiere modificar una imagen existente en lugar de generarla desde cero.

¿Qué requisitos de hardware tiene Z-Image?

La variante Turbo está diseñada para ofrecer latencias por debajo del segundo en GPUs de gama alta como H800, pero también puede ejecutarse en GPUs de consumo con 16 GB de VRAM. Gracias a proyectos como stable-diffusion.cpp, es posible generar imágenes con Z-Image incluso en tarjetas con 4 GB de VRAM, ajustando resolución y parámetros de inferencia.

¿Cómo se puede probar o integrar Z-Image en un proyecto?

El modelo dispone de código e instrucciones de uso en su repositorio oficial, incluyendo ejemplos en PyTorch y soporte específico para Diffusers de Hugging Face. A partir de ahí, se puede integrar en backends propios, pipelines de ComfyUI o herramientas personalizadas de generación y edición de imágenes.

Fuentes:

Paper “Z-Image: An Efficient Image Generation Foundation Model with Single-Stream Diffusion Transformer”, arXiv, 2025.