Los modelos de lenguaje de gran tamaño (LLMs) han revolucionado el procesamiento del lenguaje natural, permitiendo la comprensión y producción de textos que simulan el lenguaje humano con gran precisión. Estos modelos, entrenados con vastos conjuntos de datos que abarcan diversas temáticas, están siendo cada vez más adaptados para optimizar su desempeño en aplicaciones específicas mediante técnicas de ajuste fino y aprendizaje con pocos ejemplos. Sin embargo, su implementación demanda una significativa potencia computacional, representando un desafío considerable a la hora de lograr bajas latencias necesarias en contextos que requieren respuestas inmediatas, como la traducción en tiempo real o los asistentes de voz conversacionales.

En respuesta a este reto, un grupo de investigadores ha desarrollado Medusa, un innovador marco que permite acelerar la inferencia de LLMs añadiendo cabezas adicionales para la predicción simultánea de múltiples tokens. En recientes demostraciones con Medusa-1, se consiguió una aceleración en la velocidad de inferencia de aproximadamente el doble, sin comprometer la calidad del modelo. Esta mejora varía según el tamaño del modelo y los datos utilizados, alcanzando un incremento de 1.8 veces en la velocidad cuando se empleó un conjunto de datos específico.

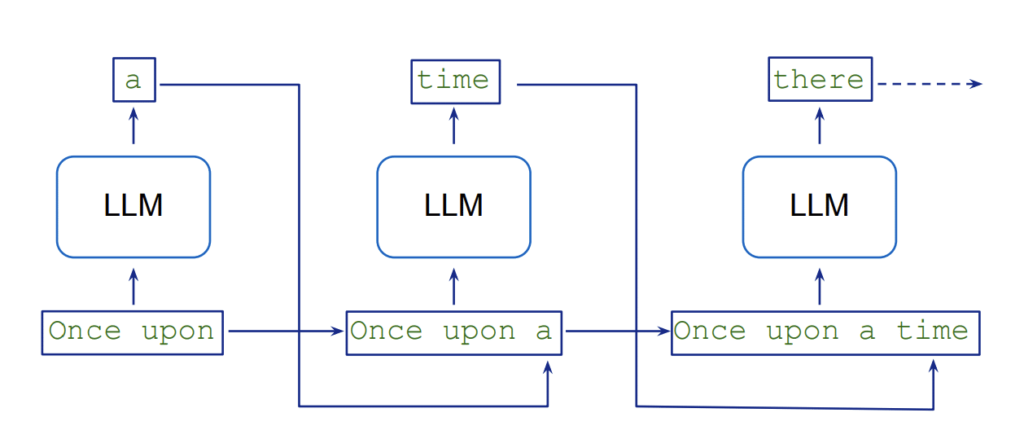

Tradicionalmente, la generación de texto en los LLMs se efectúa de manera secuencial, lo que causa un tiempo de latencia inherente, dado que cada token futuro depende de los previos. Este método requiere múltiples pasadas del modelo, resultando en un notable consumo de recursos. La técnica de «decodificación especulativa» ha sido propuesta para abordar este problema, utilizando un modelo más ligero para generar en paralelo múltiples posibilidades, las cuales son luego verificadas por un modelo más preciso. Sin embargo, Medusa se desmarca de este enfoque al no necesitar un modelo previo, optando por agregar cabezas de decodificación que generan candidatos de forma simultánea, lo que disminuye significativamente los pasos secuenciales requeridos.

Medusa ha evidenciado notables avances en términos de velocidad, logrando incrementos de hasta 2.8 veces en la inferencia, dependiendo del tamaño y la complejidad del modelo. Actualmente, Medusa es compatible con modelos como Llama y Mistral, aunque su implementación podría necesitar más memoria, en función de la cantidad de cabezas añadidas. El entrenamiento de estas cabezas requiere tiempo y recursos, aspectos que deben ser considerados al planificar proyectos. Además, el marco solo admite un tamaño de lote de uno, haciéndolo ideal para aplicaciones donde la baja latencia es crucial.

Mediante una serie de pasos dirigidos, desde la preparación del conjunto de datos hasta su implementación en un endpoint de Amazon SageMaker AI, la inferencia de LLMs en aplicaciones puede acelerarse, resultando en tiempos de respuesta más rápidos y una mejor experiencia para el usuario. A medida que más empresas exploran el potencial de los LLMs, soluciones de optimización del performance como Medusa serán claves para superar desafíos operativos y de calidad en la generación automatizada de texto.