La aplicación de escritorio para ejecutar modelos de lenguaje localmente se potencia con soporte para microservicios NVIDIA NIM y aceleración RTX, facilitando flujos de trabajo de IA más rápidos y privados.

AnythingLLM, una de las herramientas más populares entre entusiastas y desarrolladores que trabajan con modelos de lenguaje grandes (LLM) en local, ha dado un paso decisivo hacia el rendimiento y la accesibilidad gracias a su integración con los microservicios NVIDIA NIM y la aceleración por GPU en PCs equipados con NVIDIA RTX.

Desarrollada como una aplicación todo-en-uno enfocada en la privacidad, AnythingLLM permite ejecutar modelos de lenguaje de código abierto en local, además de integrar funcionalidades como generación aumentada por recuperación (RAG), resumen de documentos, análisis de datos, y acciones automatizadas a través de herramientas conocidas como skills o habilidades.

Potencia local con NVIDIA RTX

El nuevo soporte para GPUs GeForce RTX y RTX PRO permite acelerar significativamente la inferencia de modelos en AnythingLLM gracias al uso de bibliotecas como Llama.cpp y GGML, optimizadas para las arquitecturas NVIDIA. En pruebas internas, la ejecución de modelos como Llama 3.1 8B y DeepSeek R1 8B mostró un rendimiento hasta 2,4 veces superior en una RTX 5090 frente al procesador Apple M3 Ultra.

La aceleración se basa en el uso de Tensor Cores de quinta generación, lo que permite que modelos complejos se ejecuten en tiempo real, directamente desde el escritorio, sin depender de la nube ni comprometer datos sensibles.

Microservicios NIM: una nueva vía para el desarrollo ágil

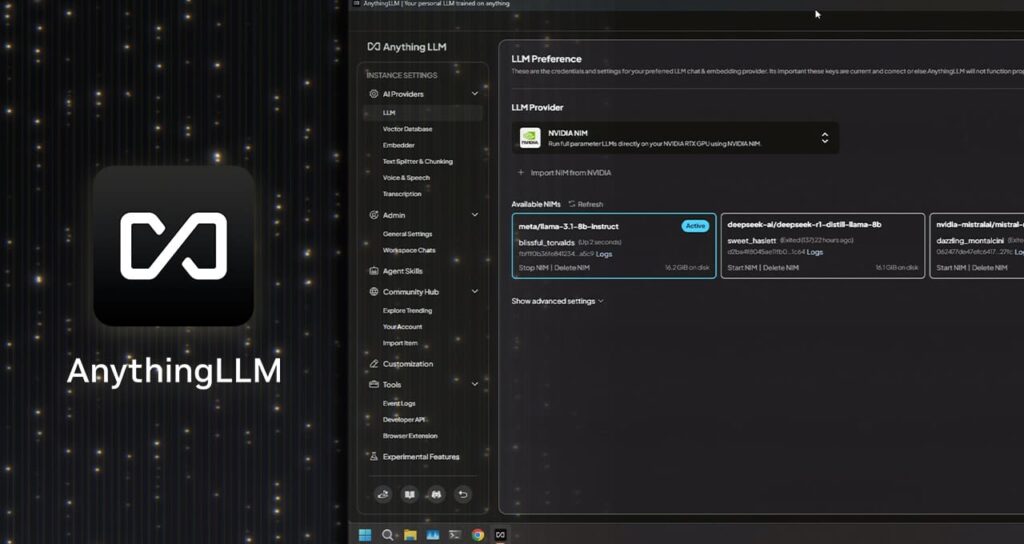

AnythingLLM también ha adoptado los microservicios NVIDIA NIM, contenedores optimizados con modelos generativos listos para su uso. Esto elimina la necesidad de configurar entornos manualmente o instalar múltiples dependencias. Los usuarios pueden experimentar con estos modelos directamente desde la interfaz de AnythingLLM o conectarlos a sus propios flujos de trabajo gracias a una API simplificada.

Entre las ventajas de los NIM destacan:

- Compatibilidad con modelos de texto e imagen.

- Disponibilidad tanto en la nube como en local.

- Optimización con TensorRT, logrando hasta el doble de rendimiento en GPUs NVIDIA Blackwell gracias al uso de precisión FP4.

Durante COMPUTEX 2025, se anunció además la incorporación del modelo generativo de imágenes FLUX.1-schnell como microservicio NIM, así como una actualización de FLUX.1-dev para dar soporte a más GPUs de las series RTX 40 y 50.

Proyecto G-Assist: control de PC por IA sin código

Otra innovación destacada es la integración de AnythingLLM con Project G-Assist, el asistente experimental de NVIDIA para controlar el PC mediante lenguaje natural. Este sistema, integrado en la aplicación de NVIDIA, permite a los usuarios crear plug-ins sin necesidad de programación, conectando comandos de voz o texto con aplicaciones como Discord, Spotify o Google Gemini.

La comunidad ya está desarrollando plug-ins que permiten desde automatizar la iluminación RGB hasta ejecutar tareas complejas en el escritorio. Incluso se ha lanzado una integración con Langflow, una herramienta para construir flujos de IA sin código que ahora permite incorporar G-Assist como componente.

Un ecosistema en crecimiento para la IA en el escritorio

El éxito de AnythingLLM se enmarca en una tendencia más amplia hacia la democratización de la inteligencia artificial en los PCs personales. La combinación de aplicaciones como esta con herramientas de desarrollo de NVIDIA —incluyendo TensorRT para RTX, CUDA, DLSS o Riva— está permitiendo a miles de usuarios crear asistentes inteligentes, agentes generativos, herramientas creativas y aplicaciones personalizadas directamente desde su ordenador, con control total sobre sus datos.

Gracias a la integración con NVIDIA NIM y la optimización para GPUs RTX, AnythingLLM se posiciona como una solución de referencia para quienes desean llevar la potencia de los LLM directamente a su escritorio, sin complejidad técnica ni dependencia de terceros.

Para más información, la aplicación está disponible en su web oficial y es compatible con modelos de código abierto, así como con APIs de proveedores como OpenAI, Microsoft y Anthropic.

vía: Nvidia