Apple acaba de publicar un estudio demoledor que desmonta uno de los grandes mitos de la inteligencia artificial generativa: los modelos de IA actuales, por avanzados que sean, no razonan ni resuelven problemas como un ser humano. Solo aparentan hacerlo.

El experimento que desenmascara a los grandes modelos

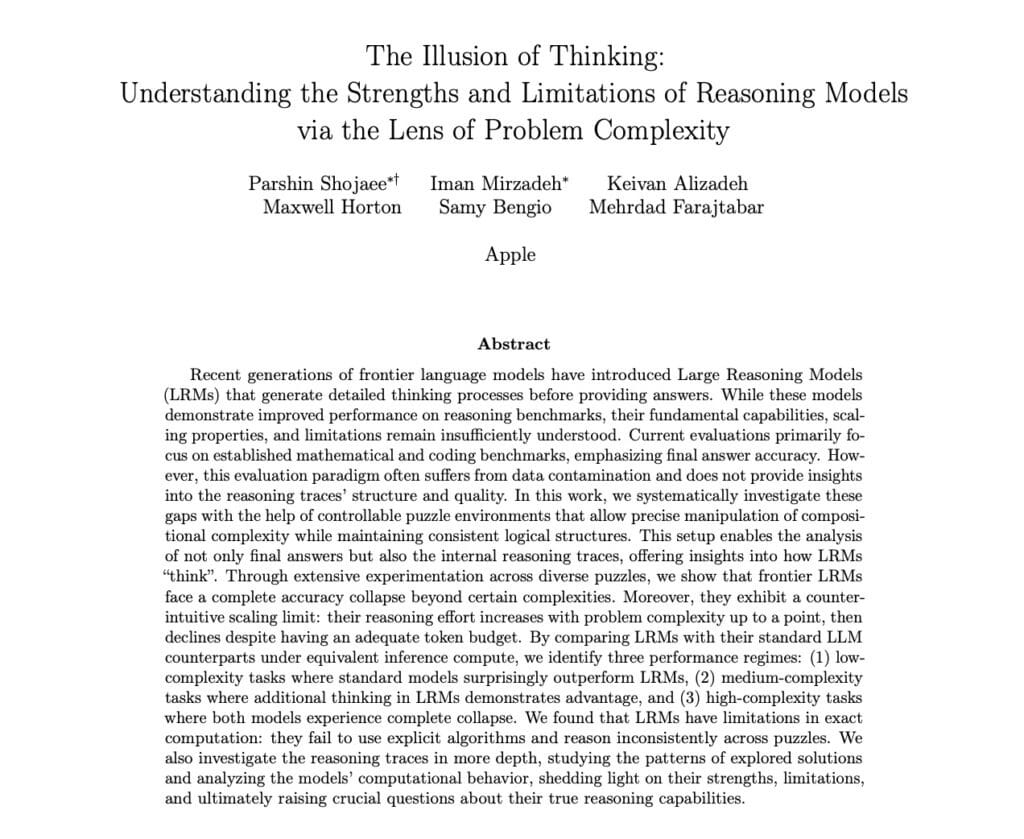

El paper, titulado The Illusion of Thinking: Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity, presenta una serie de experimentos controlados con algunos de los modelos de IA más avanzados del momento: Claude 3.7, DeepSeek-R1, o3-mini y Gemini Thinking.

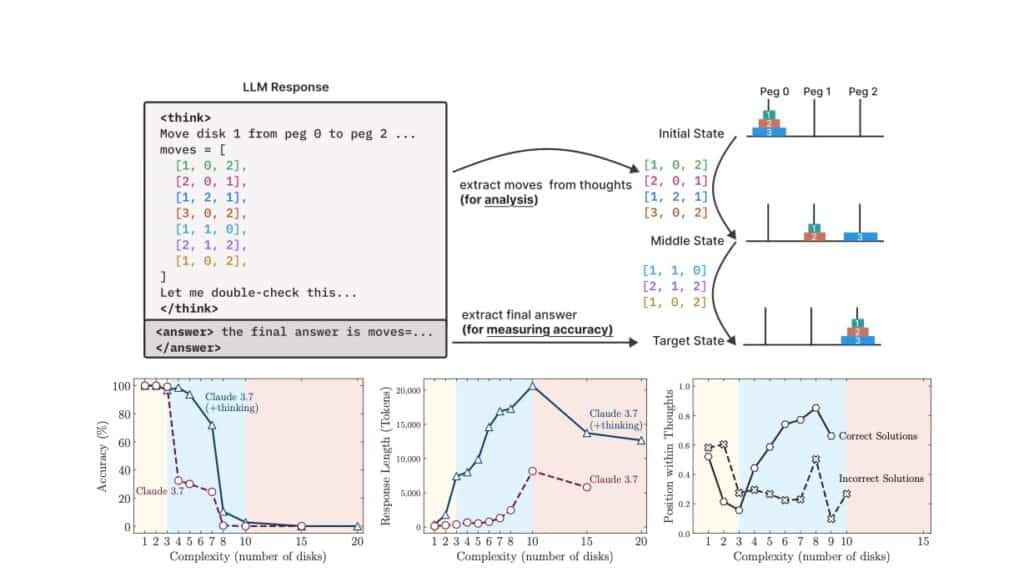

A diferencia de los test habituales —que se centran en problemas matemáticos clásicos o preguntas de programación—, los investigadores de Apple han recurrido a rompecabezas lógicos clásicos, como la Torre de Hanói, problemas de cruces de río, bloques apilados o el famoso puzzle de las damas. Estos retos permiten medir de forma precisa la capacidad real de razonamiento, ya que se puede ajustar su dificultad de forma incremental y evitar la contaminación de datos.

¿Qué han descubierto?

El resultado es contundente: los modelos colapsan ante la complejidad. Cuando la dificultad del problema aumenta, todos estos sistemas —incluso aquellos que simulan “pensar” en voz alta generando cadenas largas de razonamiento— ven cómo su precisión se desploma a cero. Ni siquiera son capaces de seguir una serie de instrucciones lógicas paso a paso cuando se les proporciona el algoritmo exacto para resolver el reto.

En palabras del estudio:

“Estos modelos, a pesar de sofisticados mecanismos de auto-reflexión, no desarrollan capacidades de resolución generalizables para tareas de planificación, colapsando su rendimiento más allá de un umbral de complejidad.”the-illusion-of-thinking

Tres niveles de dificultad: ¿cuándo fallan?

El equipo de Apple ha detectado tres regímenes de comportamiento según la dificultad:

- Baja complejidad: Los modelos estándar (sin “pensamiento encadenado”) funcionan igual o mejor que los que simulan pensar.

- Complejidad media: Los modelos que simulan cadenas de razonamiento (“thinking models”) muestran una ligera ventaja, encontrando más soluciones correctas.

- Alta complejidad: Todos los modelos colapsan, sean del tipo que sean. La precisión se reduce drásticamente y dejan de intentar buscar la solución correcta.

Un comportamiento ilógico

Uno de los hallazgos más sorprendentes es que, cuando el problema se complica, los modelos reducen el esfuerzo de razonamiento. Usan menos tokens, exploran menos caminos, y dan menos pasos. Es justo lo contrario de lo que haría un ser humano ante un reto complejo. No intentan corregir sus errores, ni comparar caminos, ni perseveran: simplemente abandonan antes.

Incluso cuando los investigadores proporcionan el algoritmo de resolución correcto —por ejemplo, los pasos exactos para la Torre de Hanói—, los modelos son incapaces de seguirlo de manera consistente. Esto pone en duda la capacidad de estas IA para ejecutar instrucciones lógicas, más allá de memorizar patrones o imitar estructuras conocidasthe-illusion-of-thinking.

¿Por qué ocurre esto? ¿Es solo un problema de entrenamiento?

El estudio de Apple desmonta la idea de que basta con “escalar” (más datos, más parámetros, más potencia) para lograr una inteligencia artificial capaz de razonar como un humano. De hecho, demuestra que los grandes modelos de lenguaje actuales no resuelven problemas: improvisan soluciones aparentes basándose en patrones estadísticos y en ejemplos memorizados.

En puzzles como la Torre de Hanói, los modelos pueden acertar con muchos movimientos cuando la versión es sencilla (quizá porque han visto ejemplos similares en su entrenamiento), pero se bloquean completamente en variantes menos conocidas, como los problemas del río o con restricciones añadidas.

Comparativa: humanos vs. IA

- Humanos: Cuando el reto se complica, los humanos suelen dedicar más tiempo, explorar más alternativas y perseverar hasta encontrar una solución o entender el problema.

- IA actual: Los modelos generan menos texto razonado a medida que aumenta la dificultad, y renuncian mucho antes. No distinguen si lo están haciendo bien o mal, ni corrigen estrategias fallidas.

¿Estamos cerca de una IA que realmente razone?

El trabajo de Apple plantea dudas profundas sobre el desarrollo de la inteligencia artificial general (AGI). No basta con hacer modelos más grandes o con más “pensamiento encadenado”. Los autores sugieren que hay barreras fundamentales en la arquitectura actual de las IA tipo ChatGPT, Claude o Gemini.

Conclusiones y futuro

- Los modelos actuales no piensan: solo simulan un razonamiento basado en patrones memorizados.

- Hay un umbral de complejidad a partir del cual colapsan, sean del tipo que sean.

- Ni siquiera siguiendo instrucciones paso a paso, estos modelos pueden ejecutar una tarea lógica compleja sin errores.

- El riesgo real: cuanto más convincentes parecen, más fácil es confundir su “apariencia” de pensamiento con una inteligencia real.

Apple lanza así un mensaje claro: la industria debe abandonar el hype y abordar con rigor las limitaciones reales de la inteligencia artificial. Aumentar la capacidad computacional no será suficiente para cruzar el umbral del verdadero razonamiento.

Referencias

- Shojaee, P., Mirzadeh, I., Alizadeh, K., Horton, M., Bengio, S., Farajtabar, M. (2024). The Illusion of Thinking: Understanding the Strengths and Limitations of Reasoning Models via the Lens of Problem Complexity. Apple Research.

- Enlace al paper completo (PDF)