Durante años, los deepfakes fueron casi una curiosidad: vídeos con rostros desalineados, labios que no encajaban y voces robóticas. En 2025 el cuadro ha cambiado. La inteligencia artificial ha convertido las falsificaciones de audio en algo verosímil, rápido y barato, hasta el punto de que ya es posible suplantar tu voz en tiempo real durante una llamada. Ese salto abre la puerta a un viejo conocido del fraude, el vishing (phishing por voz), en una versión con esteroides: “deepfake vishing”.

Este reportaje explica cómo funciona el engaño, qué tecnología utilizan los atacantes, por qué resulta tan convincente y, sobre todo, qué puede hacer una persona o una empresa para no caer en la trampa.

La nueva estafa: igual que siempre… pero con tu voz

La mecánica social cambia poco: una llamada inesperada que apremia (“necesitamos que apruebes ahora”), un supuesto directivo que pide discreción, un “técnico” que solicita un código temporal para “verificar tu cuenta”. La novedad es que la voz al otro lado suena exactamente como alguien en quien confías: tu responsable, un familiar o el contacto de tu banco.

Según la firma de ciberseguridad NCC Group, combinar herramientas de IA de código abierto con hardware comercial permite clonar voces y hablar en tiempo real con una latencia mínima. Esto elimina las “pausas antinaturales” de los montajes antiguos y hace que una conversación improvisada parezca legítima casi siempre. Sus consultores, en pruebas controladas con consentimiento de clientes, lograron engañar a sus objetivos en casi todos los intentos al combinar deepfake de voz y spoofing del identificador de llamada (el número que ves en pantalla). El resultado: credenciales, cambios de correo, reseteos de contraseña e incluso órdenes operativas ejecutadas por personal con responsabilidad.

La revista TechSpot ha recogido estas demostraciones y subraya dos puntos clave: 1) el sistema funciona con medio segundo de retraso (prácticamente imperceptible en conversación) y 2) no exige equipos caros; un portátil con GPU Nvidia RTX A1000 (gama baja de “workstation”) bastó para el prototipo. Con tarjetas más potentes, la latencia bajaría aún más.

De cero a suplantación: cómo fabrican tu voz con IA

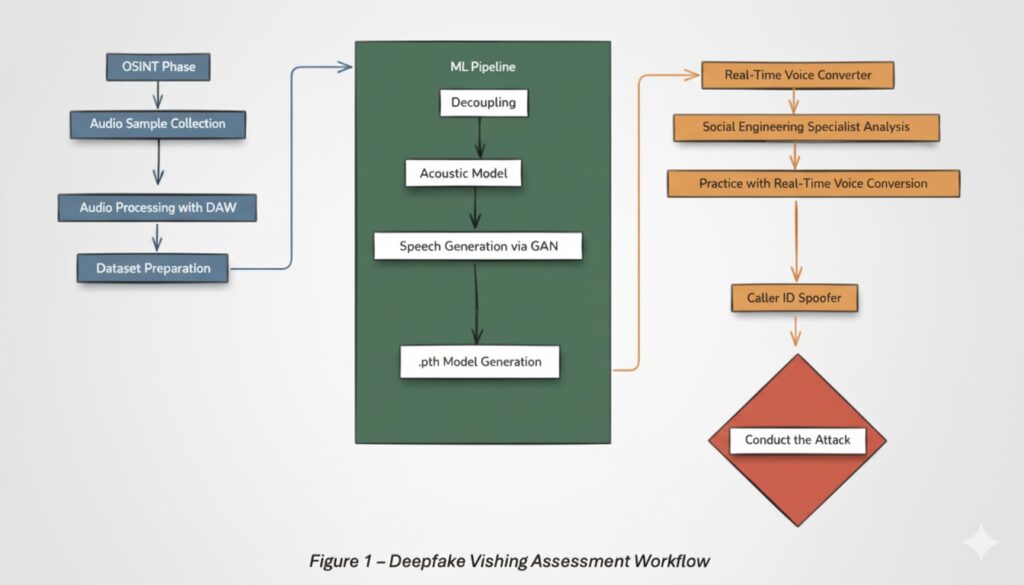

El diagrama del flujo de ataque —mostrado por NCC Group— ayuda a entender el proceso de un vistazo (ver la ilustración de la página 3 del documento): OSINT (búsqueda abierta) → pipeline de ML (entrenamiento y generación) → convertidor de voz en tiempo real → spoofing de caller ID → llamada.

1) Pesca de audios (OSINT)

Los atacantes comienzan recopilando muestras de tu voz. ¿De dónde? De vídeos corporativos, entrevistas, podcasts, webinars, redes sociales, notas de voz filtradas… En la página 4 del informe, los autores detallan cómo procesaron clips de baja calidad con ruido de fondo y voces superpuestas para limpiar y aislar el timbre objetivo. Parte del proceso se automatiza (identificación de hablante con modelos ML); el resto se hace en un DAW (estación de audio digital), ajustando noise gate, ecualización y compresión hasta dejar un conjunto utilizable.

2) Entrenar el clon (horas, no días)

Con el material listo, se entrena un modelo de IA que aprende el “ADN vocal” (timbre, tono, ritmo, acento). A nivel técnico —explican en la página 4–5— se separa el contenido lingüístico (qué se dice) de la identidad vocal (quién lo dice) mediante redes convolucionales y transformers para el “desacople”, RMVPE para extraer el pitch y un vocoder GAN para reconstruir la señal final. El resultado del entrenamiento se guarda en un archivo .pth que contiene los pesos del modelo, listo para ejecutar inferencias en tiempo real en cualquier máquina.

3) “Tu voz” en directo

El atacante habla con su micrófono; el audio se redirige a un dispositivo virtual que pasa por el convertidor en tiempo real y sale como si fuera tu voz. El paso final es el spoofing del número (simular que la llamada viene del móvil del directivo, de la centralita del banco o del fijo de la empresa). En la página 6 muestran pantallazos de una prueba con identidad suplantada y mensajes SMS, y enlazan un clip demostrativo del clon de voz.

La clave es que todo ocurre en vivo: el “imitador” puede improvisar respuestas, corregirse si le pillan un matiz y mantener una conversación de negocio sin latencias sospechosas.

¿Cuánta potencia de cálculo hace falta?

Menos de la que imaginas. En el prototipo, los investigadores usaron una Nvidia RTX A1000 (4 GB, 2.048 núcleos CUDA), una GPU que cuesta menos de 500 € y se vende en tiendas convencionales. Con ese “barebone”, entrenar modelos llevó unas horas y la conversación en directo tuvo unos 500 ms de retraso. Para producción maliciosa, podrían alquilar por horas instancias con GPU en la nube y abaratar aún más el despliegue.

En resumen: barrera de entrada baja y calidad suficiente. Por eso, los expertos anticipan un crecimiento de este tipo de ejercicios de seguridad… y de su uso delictivo.

¿Por qué cuesta tanto detectar un deepfake de voz?

- Velocidad: medio segundo de lag no rompe el ritmo.

- Contexto: la voz correcta sumada al número correcto en pantalla anula defensas (“es mi jefa”).

- Psicología: los guiones explotan autoridad y urgencia (pagos, accesos, “hay una auditoría”).

- Calidad del clon: basta con que sea “suficientemente bueno” para una llamada de trabajo; el oído humano tolera imperfecciones si el entorno (ruido de oficina, cobertura irregular) lo justifica.

En vídeo en directo la trampa sigue notándose más (desincronía, microgestos incoherentes), pero audio por teléfono ya ha cruzado la frontera de lo creíble para la mayoría.

Señales de alarma (y límites) que todavía ayudan

- Cambios de registro: si la persona acorta o alarga sílabas de forma extraña, o evita nombres propios complicados.

- Fugas de contenido: la voz suena bien, pero se equivoca en un proceso interno (pide “token” donde no hay MFA, inventa un proveedor).

- Entornos imposibles: ruido “enlatado” idéntico en todas las frases, eco raro, respiración artificial.

- Saltos de tono poco naturales al emocionar (enfado/alegría) o risas rígidas.

Ninguna de estas pistas es infalible, y los modelos mejoran cada mes; pero sirven como semáforos para pasar al siguiente control: verificación por canal alternativo.

Cómo protegerse: protocolos simples que salvan el día

Para personas (y familias)

- Código o “señal” privada: acordad una palabra o pregunta no pública (como en el béisbol) para validar identidad ante peticiones sensibles por teléfono. Si no aparece esa señal, cuelga y devuelve la llamada al número oficial.

- Desconfía de la urgencia: los atacantes “van con prisa”. Ninguna operación seria se hunde por esperar 5 minutos mientras confirmas.

- No compartas “muestras”: es imposible borrar tu voz de Internet, pero limita audios públicos (y configura la privacidad de redes).

- Modo rescate: si sospechas, cuelga y escribe por un canal verificado (correo corporativo, chat de empresa, número guardado) preguntando si de verdad llamaron.

Para empresas

- Política “call-back” obligatoria: cualquier orden que afecte a dinero, credenciales o datos se verifica llamando de vuelta a un número oficial en el directorio.

- Contraseñas de paso (one-time passphrases) para autenticación verbal en el helpdesk y departamentos sensibles.

- Formación con guiones vivos: ejercicios de vishing periódicos que simulen deepfake y spoofing; medir y mejorar.

- Reglas de “no por teléfono”: nunca se piden por voz códigos de MFA, enlaces de restablecimiento o transferencias sin workflow documentado.

- Grabar y avisar: las centralitas modernas permiten identificar llamadas entrantes manipuladas y marcarlas; revisa con IT si puedes habilitar análisis de audio y alertas.

- Segunda persona: para órdenes críticas (pagos, cambios de proveedor) exige doble validación por dos responsables y dos canales.

¿Qué pueden hacer bancos, telcos y plataformas?

- STIR/SHAKEN y medidas anti-spoofing: impulsarlas y mostrarlas al usuario con indicadores claros de llamada verificada.

- Detección de liveness en voz: técnicas que buscan artefactos de síntesis (no perfectas, pero útiles como señal).

- Alertas de patrón: sistemas que detectan cadencias anómalas de llamadas “urgentes” a múltiples empleados.

- Educación: más avisos “en el momento” (pop-up en móvil: “desconfía si te piden códigos”), no solo campañas estáticas.

Qué hacer si ya has respondido a un deepfake

- Corta la comunicación y documenta: hora, número mostrado, resumen.

- Cambia credenciales potencialmente expuestas y revoca tokens.

- Activa el protocolo de incidente (seguridad/IT); cuanto antes, mejor.

- Informa a tu banco o proveedor si hubo pagos o datos financieros.

- Denuncia: en España, a través de INCIBE y fuerzas de seguridad.

Conclusión: normalizar la verificación, no la paranoia

El deepfake de voz ya no es un truco de laboratorio. Con audios públicos, horas de entrenamiento y hardware asequible, un estafador puede sonar igual que tú o tu jefe. La defensa no pasa por “oír mejor” el timbre —la máquina también mejora—, sino por cambiar el hábito: verificar por un canal alternativo cualquier solicitud sensible. La cultura de “cuelgo y te llamo yo” vale más que cualquier oído “entrenado”.

Preguntas frecuentes

¿Cómo detectar un deepfake de voz por teléfono cuando todo suena creíble?

Busca señales (pausas raras, risas rígidas, errores de proceso) y aplica el corte-verificación: cuelga y devuelve la llamada al número oficial del directorio. Usa palabras clave privadas acordadas y nunca compartas códigos o enlaces por voz.

¿Qué hago si han clonado mi voz con IA y la usan para estafas?

Avisa a tus contactos críticos (banco, asesor, clientes) de que no acepten instrucciones por voz sin verificación cruzada. Refuerza privacidad en redes, limita publicaciones con voz y denuncia el caso a INCIBE y a las autoridades.

¿Existen herramientas gratuitas para saber si una llamada está “spoofeada”?

Algunas operadoras marcan llamadas verificadas (implementaciones de STIR/SHAKEN). No es universal ni infalible. Usa apps que identifiquen spam y, sobre todo, aplica el call-back al número oficial de tu agenda/empresa.

Empresas: ¿qué política anti-vishing con IA debería implantarse ya?

- Call-back obligatorio para pagos/credenciales/datos. 2) Frase de paso para autenticación verbal. 3) Doble validación por dos personas y dos canales en operaciones críticas. 4) Formación con simulaciones de deepfake y spoofing. 5) Prohibición expresa de pedir tokens o resets por voz.

Fuentes

- NCC Group — Realtime AI-Supported Voice Conversion (Deepfake) and its applications on Vishing and Social Engineering exercises (con diagrama de flujo en p. 3 y ejemplo de caller ID spoofing en p. 6–7).

- TechSpot — Cybersecurity experts warn real-time voice deepfakes are here (confirmación de latencias ≈ 500 ms con RTX A1000 y advertencias sobre nuevos riesgos en llamadas ordinarias).