Los modelos de lenguaje de gran tamaño continúan revolucionando la tecnología detrás de muchas aplicaciones, desde la inteligencia conversacional hasta tareas de razonamiento complejas. Sin embargo, a medida que aumentan en tamaño y capacidad, evaluar su rendimiento se convierte en un reto cada vez mayor. Las tradicionales métricas de evaluación, como la perplejidad y los puntajes BLEU, a menudo no logran capturar las sutilezas de las interacciones reales, lo que hace que los marcos de evaluación alineados con humanos sean esenciales para obtener comparaciones justas y despliegues más fiables.

Con este desafío en mente, se han desarrollado métodos de evaluación automatizados que emplean modelos de lenguaje como jueces. Este enfoque, que utiliza un modelo más potente para evaluar otros modelos en base a criterios tales como la corrección y la utilidad, ha ganado popularidad gracias a su escalabilidad y eficiencia de costos en comparación con la evaluación humana exclusiva. Las estrategias discutidas incluyen desde la comparación en pares hasta la puntuación de respuestas individuales, cada una ofreciendo una perspectiva única sobre el rendimiento de los modelos.

Para obtener resultados concretos, se han utilizado los marcos de evaluación MT-Bench y Arena-Hard. MT-Bench se centra en interacciones tipo chatbot a través de un enfoque estructurado multivuelta, mientras que Arena-Hard clasifica modelos mediante «batallas» de respuestas en tareas desafiantes. Estos marcos buscan cerrar la brecha entre la evaluación automatizada y la humana, garantizando que los modelos no solo se midan mediante indicadores sintéticos, sino también en situaciones prácticas.

En este estudio reciente, se evaluaron los modelos de la familia Amazon Nova, incluidos los recientemente añadidos Amazon Nova Premier, que se presentaron en el evento AWS re:Invent en diciembre de 2024. Estos modelos están diseñados para ofrecer inteligencia avanzada con patrones de costo-efectividad destacados. La gama va desde Amazon Nova Micro, optimizada para despliegues en el borde, hasta Amazon Nova Premier, enfocada en tareas complejas.

A través de Amazon Bedrock, los clientes pueden transferir capacidades del Nova Premier a modelos más rápidos y asequibles como Nova Pro o Nova Lite, adaptables a dominios específicos. Este proceso se realiza fácilmente mediante la consola de Amazon Bedrock y APIs especializadas.

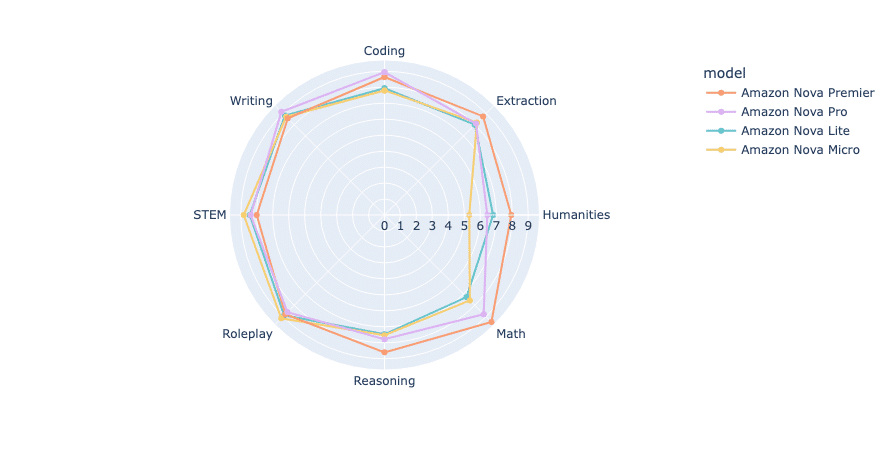

La evaluación con MT-Bench y Arena-Hard demostró una clara jerarquía de rendimiento. Amazon Nova Premier lideró con el puntaje mediano más alto, seguido por Nova Pro, mientras que Nova Lite y Nova Micro también obtuvieron resultados destacados. Un análisis adicional reveló que Nova Premier, aunque es el modelo más grande, genera respuestas más concisas, lo que se traduce en una eficiencia de token superior.

Por otro lado, Arena-Hard-Auto utilizó 500 indicaciones desafiantes para evaluar diferentes LLM mediante comparaciones en pares, lo que proporcionó un análisis profundo de las capacidades del modelo. Este enfoque ayuda a clasificar el rendimiento basado en múltiples categorías de preferencia.

El estudio concluye que los modelos Amazon Nova son rentables y eficientes, representando una opción competitiva para empresas que buscan optimizar la eficiencia sin comprometer calidad. Esta investigación resalta la importancia de las metodologías de evaluación al seleccionar y desplegar modelos en aplicaciones del mundo real.