ComfyUI se ha convertido, casi en silencio, en una pieza clave del ecosistema de IA generativa. No es “otro modelo más”, sino el motor de workflows que utilizan miles de artistas, desarrolladores y estudios para orquestar modelos como Stable Diffusion, FLUX.2 y decenas de variantes de imagen, vídeo y audio.

Su propuesta es clara:

“Construir el sistema operativo de la Gen AI visual”

Un entorno gráfico por nodos donde puedes montar tu propia “fábrica de imágenes”: cargar modelos, encadenar control de poses, LoRAs de estilo, upscale, vídeo, audio… todo en tu máquina, sin depender de un SaaS cerrado.

Qué es exactamente ComfyUI

ComfyUI es un motor de flujos de trabajo basado en nodos (node-based) para IA generativa:

- 100 % software libre y open source.

- Funciona en Windows, Linux y macOS (incluido Apple Silicon).

- Corre en GPU NVIDIA, AMD, Intel, Apple M-series e incluso en CPU (más lento), y ya hay soporte para NPUs como Ascend o Cambricon según la configuración.

- Se ejecuta en un entorno de Python aislado, lo que facilita actualizarlo o mantener varias instalaciones sin romper el sistema.

Sobre esa base se apoya un ecosistema muy vivo:

- ComfyUI (core): el motor de grafos de nodos.

- ComfyUI Manager: instalar y actualizar custom nodes y extensiones desde una interfaz gráfica.

- Registro de Custom Nodes: catálogo comunitario con nodos para nuevos modelos, efectos, loaders y herramientas.

- Frontends, CLI y herramientas de automatización: para integrar ComfyUI en pipelines, granjas de render o APIs internas.

- Documentación, plantillas y ejemplos mantenidos por la comunidad.

La filosofía es sencilla:

ComfyUI no te “encierra” en un modelo concreto, sino que te da piezas de LEGO para que tú decidas qué modelo usar y cómo combinarlo.

Cómo funciona el soporte de modelos en ComfyUI

ComfyUI no trae un solo modelo “oficial”, sino soporte genérico para cargar checkpoints y difusores compatibles:

- Puedes usar modelos

*.safetensorsy*.ckptde Stable Diffusion 1.x, 2.x y SDXL. - Mediante nodos específicos se cargan el UNet, el CLIP y el VAE de cada checkpoint, permitiendo cambiar de modelo a mitad de workflow o trabajar con varios a la vez.

- Con ComfyUI Manager y su fichero de modelos se gestionan colecciones enteras de checkpoints, LoRAs, VAE y redes de control (ControlNet, etc.), incluyendo modelos oficiales como SDXL base, refiner e inpainting.

A partir de ahí, la comunidad ha añadido soporte para gran parte de los modelos punteros de imagen y vídeo, y los fabricantes están empezando a optimizar sus modelos directamente para ComfyUI, como ocurre con FLUX.2 y las optimizaciones FP8 para GPUs RTX descritas por NVIDIA (texto que tú mismo has compartido).

Principales familias de modelos que puedes usar hoy con ComfyUI

No existe una lista “cerrada” y oficial —porque el ecosistema se mueve muy rápido—, pero sí se pueden destacar algunas familias que ya se usan de forma habitual.

⚠️ Importante: la mayoría se cargan como checkpoints estándar o como nodos externos. La compatibilidad depende de la VRAM disponible y de que el nodo/loader esté actualizado.

1. Modelos Stable Diffusion “clásicos”

- Stable Diffusion 1.x (1.4, 1.5, etc.)

- Tipo: difusión latente.

- Uso típico: ilustración general, estilos artísticos, modelos finos (DreamShaper, Realistic Vision, etc.).

- Ventaja: consumo moderado de VRAM, enorme cantidad de LoRAs y embeddings.

- Stable Diffusion 2.x

- Mejoras en composición y algunos estilos, aunque menos popular en la comunidad que 1.5/XL.

2. Stable Diffusion XL (SDXL)

- SDXL base 1.0

- SDXL refiner 1.0

- SDXL inpainting 0.1 (cargado vía UNet específico en ComfyUI Manager).

Uso típico:

- Imágenes de mayor calidad y detalle.

- Flujos en dos fases (base + refiner) para fotografía y productos.

- Inpainting avanzado directamente desde nodos.

3. Modelos acelerados y “turbo”

A través de nodos de la comunidad puedes usar:

- Variantes LCM / Latent Consistency Models.

- Modelos “turbo” o fast pensados para generar muchos frames o hacer previsualizaciones rápidas.

Se integran muy bien en ComfyUI porque puedes:

- Encadenar un preview rápido con un modelo ligero.

- Re-renderizar después con un modelo de alta calidad sobre la misma semilla/composición.

4. FLUX.1 y FLUX.2 de Black Forest Labs

Aquí es donde ComfyUI destaca especialmente en 2025:

- FLUX.1 [dev] y variantes open-weight

- Modelos abiertos muy populares para imagen de alta calidad.

- La comunidad ha publicado workflows listos para usar en ComfyUI.

- FLUX.2 [dev] (32B parámetros, imagen + edición)

- Modelo de nueva generación con:

- Multi-referencia (hasta 6–10 imágenes según la configuración del backend).

- Fotorealismo a resolución de hasta 4 MP.

- Texto legible en infografías, UI y memes.

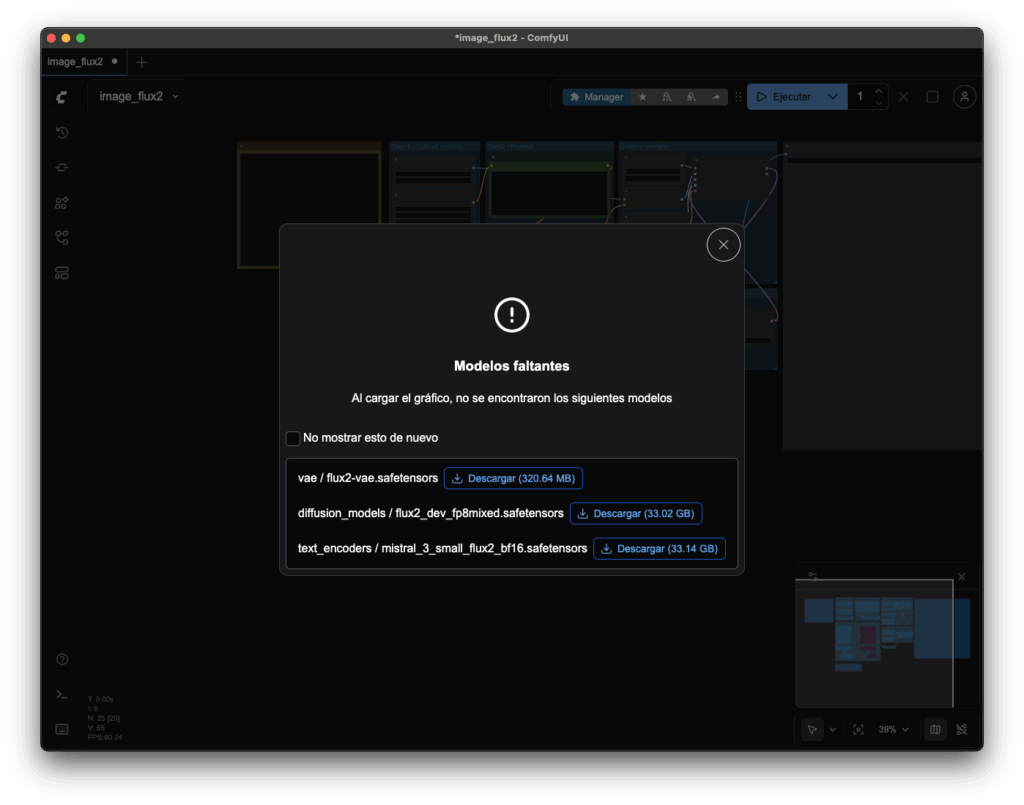

- NVIDIA y Black Forest Labs han colaborado para ofrecer checkpoints FP8 optimizados y soporte directo en ComfyUI, usando weight streaming para poder ejecutarlo en GPUs RTX de consumo con menos VRAM, aunque con algo de penalización en rendimiento (dato procedente del blog que has compartido).

- Modelo de nueva generación con:

En la práctica, hoy puedes:

- Cargar FLUX.2 [dev] desde plantillas específicas de ComfyUI.

- Mezclarlo con nodos de ControlNet, upscale, etc.

- Usar varios modelos FLUX en el mismo grafo para estilos diferentes.

5. Modelos para vídeo, animación y control

Gracias a custom nodes, ComfyUI también se usa como “pegamento” para:

- AnimateDiff / AnimateDiff Evolved (animación a partir de keyframes o textos).

- Variantes de Stable Video Diffusion y modelos de vídeo open-source.

- Distintos ControlNet y pose control (poses, profundidad, bordes, etc.).

- Pipelines de outpainting, pan & zoom, interpolación y efectos de cámara.

La lista se amplía casi cada semana con nuevos nodos publicados en el registro y en GitHub.

Tabla orientativa: grandes familias de modelos en ComfyUI

No es una lista exhaustiva, pero sirve como mapa mental de lo que ya se usa a diario.

| Familia / Modelo | Tipo / Uso principal | VRAM recomendada (aprox.) | Comentario rápido |

|---|---|---|---|

| SD 1.5 + derivados | Imagen general, arte, estilos variados | 6–8 GB | El “caballo de batalla” clásico, miles de LoRAs. |

| SD 2.x | Imagen general, algo mejor en composición | 8 GB | Menos ecosistema que 1.5/XL. |

| SDXL base + refiner | Fotografía, producto, alta resolución | 10–12 GB | Excelente calidad, buen soporte en ComfyUI Manager. |

| SDXL inpainting | Relleno, edición localizada | 10–12 GB | Ideal para pipelines de retoque. |

| Modelos LCM / “turbo” | Previews rápidos, vídeo, muchas iteraciones | 6–10 GB | Sacrifican algo de calidad por velocidad. |

| FLUX.1 [dev] y variantes | Imagen creativa de alta calidad | 10–16 GB | Open-weight, muchos workflows comunitarios. |

| FLUX.2 [dev] (FP8) | Fotorealismo, multi-referencia, texto | 16–24 GB (con streaming) | Frontera de calidad, optimizado para ComfyUI + RTX. |

| AnimateDiff & vídeo | Animación, clips breves | 12–24 GB | Muy dependiente de resolución y pasos. |

(Las cifras de VRAM son orientativas; la realidad depende de resolución, pasos, batch size y del uso de optimizaciones como FP8, VRAM offload, etc.)

Por qué ComfyUI se ha vuelto el “hub” de la IA visual

En un momento en el que aparecen nuevos modelos cada mes, ComfyUI ofrece algo que los frontends cerrados no pueden igualar:

- Neutralidad de modelos: si sale un modelo nuevo (FLUX.2, SDXL 2.0, un nuevo vídeo-diffusion…), lo normal es que la comunidad cree un nodo o workflow en cuestión de días.

- Control total del pipeline: tú decides cómo combinar texto, referencias, ControlNet, máscaras, upscale y postprocesado.

- Escalabilidad: el mismo grafo que usas en tu PC se puede portar a un servidor Linux con varias GPUs y automatizar vía CLI o scripts.

- Coste: sin cuotas obligatorias, solo el hardware y la electricidad que tú elijas.

Y, sobre todo, una comunidad que está convirtiendo ComfyUI en el estándar de facto para trabajar con modelos abiertos de imagen y vídeo.

Si ya trabajas con Stable Diffusion o estás interesado en experimentar con FLUX.2 y otros modelos de última generación sin depender de plataformas cerradas, ComfyUI es probablemente el lugar donde más rápido vas a encontrar soporte, ejemplos y plantillas listas para usar.