Los asistentes conversacionales basados en la Generación Aumentada por Recuperación (RAG) están transformando la forma en que las empresas manejan el soporte al cliente y la búsqueda interna. Estos sistemas, que ofrecen respuestas rápidas y precisas utilizando datos propios, se han vuelto esenciales para mejorar la experiencia del usuario sin la necesidad de complicados ajustes en su configuración.

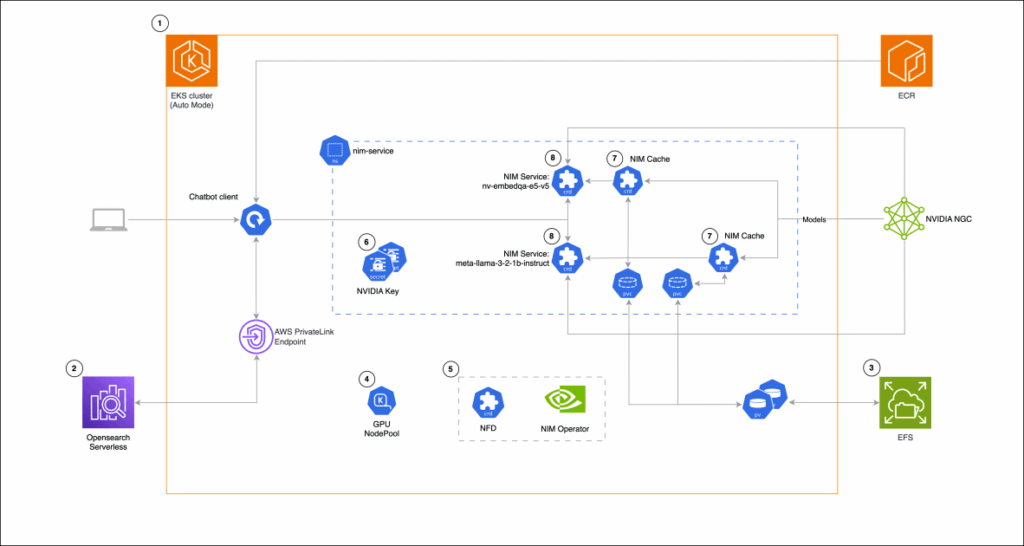

El uso de Amazon Elastic Kubernetes Service (EKS) para implementar estos asistentes garantiza a las empresas un alto grado de flexibilidad y control sobre sus datos e infraestructura. EKS es una opción económica, adaptándose tanto a demandas constantes como fluctuantes, y permite la integración con aplicaciones existentes bien en entornos locales o en la nube pública.

Por otro lado, los microservicios NVIDIA NIM, que se integran con servicios de AWS como Amazon EC2, EKS y SageMaker, simplifican el despliegue de modelos de inteligencia artificial. Distribuidos como contenedores Docker, estos microservicios eliminan la complejidad técnica del manejo de modelos, automatizando configuraciones que en otro contexto requerirían significativo tiempo y experiencia en ingeniería.

La gestión de componentes mediante el operador NVIDIA NIM optimiza la operación de diferentes tipos de modelos en Kubernetes, lo que reduce la latencia de inferencia y mejora la escalabilidad de los sistemas de inteligencia artificial.

Para una aplicación práctica, el desarrollo de un asistente RAG incluye el uso de NVIDIA NIM combinado con Amazon OpenSearch Serverless, facilitando el almacenamiento y consulta de vectores de alta dimensión. Esta infraestructura, desplegada en Kubernetes con EKS, permite administrar eficientemente cargas de computación heterogéneas.

El proceso de creación de esta solución abarca desde la configuración de EKS y OpenSearch Serverless hasta la creación de nodos GPU con Karpenter, optimizando tanto el rendimiento como los costos. Herramientas como Gradio y LangChain se utilizan para desarrollar una interfaz intuitiva, permitiendo que el asistente recupere información relevante y genere respuestas contextuales.

Este enfoque demuestra cómo Amazon EKS puede ser una herramienta efectiva para el despliegue de aplicaciones de inteligencia artificial, garantizando la fiabilidad y escalabilidad necesarias para satisfacer las crecientes demandas empresariales.