La reciente evolución de la inteligencia artificial generativa ha añadido un nivel de complejidad significativo al desarrollo, entrenamiento y despliegue de modelos de aprendizaje automático. Este proceso ahora requiere una especialización profunda, acceso a vastos conjuntos de datos y la gestión de complejas infraestructuras de computación. Además, las empresas se ven obligadas a desarrollar código especializado para llevar a cabo entrenamientos distribuidos, optimizar de manera continua sus modelos y manejar problemas relacionados con el hardware, todo mientras se mantienen dentro de unos estrictos tiempos y presupuestos.

Para abordar estos desafíos, Amazon Web Services (AWS) ha lanzado Amazon SageMaker HyperPod, una innovadora herramienta presentada durante la conferencia AWS re:Invent 2023. Según Andy Jassy, CEO de Amazon, esta solución tiene como objetivo acelerar el entrenamiento de modelos de aprendizaje automático mediante la distribución y paralelización de las cargas de trabajo a lo largo de numerosos procesadores, incluyendo los avanzados chips Trainium de AWS y GPUs. HyperPod también se encarga de la supervisión constante de la infraestructura, reparando automáticamente cualquier problema para asegurar que el trabajo se reanude sin interrupciones significativas.

Durante el AWS re:Invent 2024, se introdujeron nuevas características para SageMaker HyperPod, diseñadas para satisfacer las demandas de trabajo intensivo en inteligencia artificial, ofreciendo clústeres persistentes y optimizados tanto para el entrenamiento distribuido como para la inferencia acelerada. La herramienta ha sido adoptada por startups como Writer y Luma AI, así como por grandes corporaciones como Thomson Reuters y Salesforce, todas las cuales han observado mejoras significativas en su capacidad para desarrollar modelos de manera más rápida y eficiente.

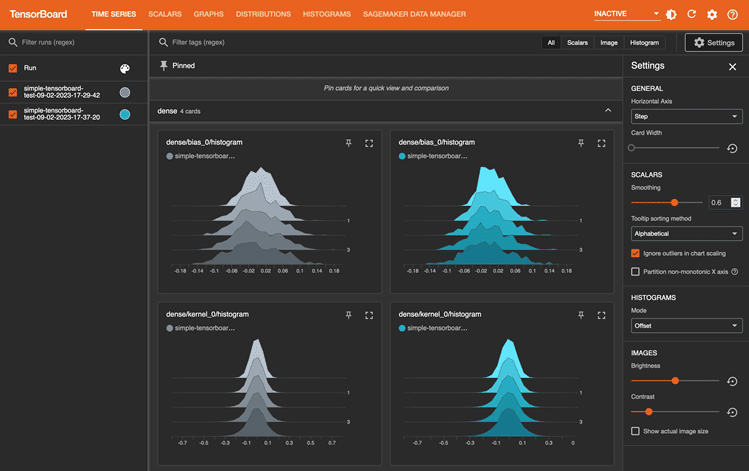

Una de las principales ventajas de SageMaker HyperPod es el control profundo que ofrece sobre la infraestructura, permitiendo conexiones seguras para entrenamientos avanzados y una gestión eficaz a través de Amazon EC2. La herramienta mantiene un grupo de instancias dedicadas y reservadas, lo cual minimiza el tiempo de inactividad en casos críticos. Con el apoyo de conocidas herramientas de orquestación como Slurm y Amazon EKS, los desarrolladores pueden gestionar eficientemente los trabajos y optimizar el uso de recursos.

Desde la perspectiva de gestión de recursos, las empresas se enfrentan al reto de administrar de manera efectiva una gran capacidad de computación necesaria para entrenar modelos. SageMaker HyperPod facilita a las organizaciones maximizar la utilización de recursos, dando prioridad a tareas fundamentales y evitando la subutilización, lo cual no solo reduce los costos de desarrollo de modelos hasta en un 40%, sino que también libera a los administradores de la constante necesidad de redistribuir recursos.

Los planes de entrenamiento flexibles dentro de SageMaker HyperPod ofrecen a los clientes la posibilidad de establecer fechas límite y definir la capacidad máxima de recursos necesarios, simplificando la adquisición de recursos de computación y potencialmente ahorrando semanas de trabajo preparatorio. Un caso destacado es el de Hippocratic AI, una firma especializada en salud, que ha utilizado estos planes para acceder de manera eficiente a instancias potentes de EC2 P5, facilitando el desarrollo de su modelo de lenguaje principal.

En conclusión, SageMaker HyperPod representa una transformación significativa en la infraestructura de inteligencia artificial, enfocándose en una gestión de recursos inteligente y adaptativa. Este enfoque permite a las organizaciones maximizar la eficiencia y reducir costos, prometiendo mejorar el ciclo de vida de la inteligencia artificial desde su desarrollo hasta su aplicación en el mundo real, y desempeñando un papel crucial en la continua evolución del sector.