Desplegar modelos de aprendizaje automático (ML) en producción ha sido siempre una tarea desafiante, especialmente para aquellos sin experiencia profunda en ML y DevOps. Con la introducción de nuevas funcionalidades en Amazon SageMaker Canvas, este proceso se ha simplificado significativamente, permitiendo que los usuarios creen modelos de ML altamente precisos sin necesidad de programar.

Amazon SageMaker Serverless Inference ha sido diseñado para manejar cargas de trabajo con patrones de tráfico variables, gestionando automáticamente la provisión y el escalado de la infraestructura según la demanda. Esta característica elimina la necesidad de gestionar servidores o pre-configurar la capacidad, optimizando tanto el tiempo como los recursos.

El procedimiento para desplegar un modelo de ML creado en SageMaker Canvas mediante SageMaker Serverless Inference incluye varias etapas. Comienza con la adición del modelo entrenado al registro de modelos de SageMaker, seguido de la creación de un endpoint sin servidor. Este enfoque permite pasar rápidamente de la formación del modelo a la generación de predicciones listas para producción sin la complejidad de manejar infraestructuras.

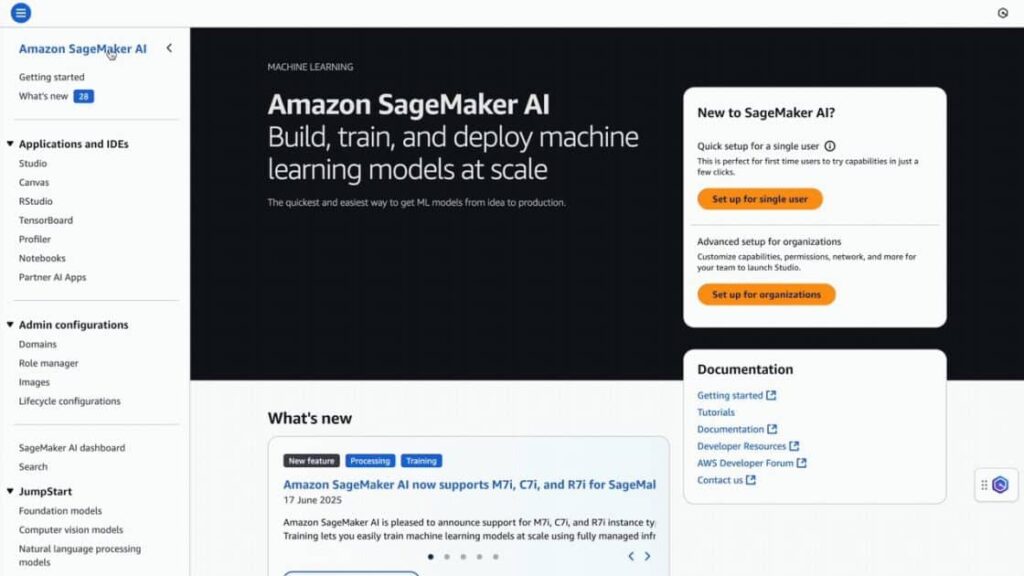

Antes de comenzar, los usuarios necesitan tener acceso a Amazon S3 y Amazon SageMaker AI, además de contar con un modelo de regresión o clasificación ya entrenado. El modelo se guarda en el registro de modelos de SageMaker y luego se aprueba para su despliegue.

El proceso de creación de un nuevo modelo implica asignar un nombre, seleccionar el contenedor adecuado y agregar las variables de entorno necesarias. Posteriormente, se lleva a cabo la configuración y creación del endpoint.

Esta arquitectura ofrece una forma simplificada para que las empresas implementen modelos de ML, permitiendo que organizaciones de diversos tamaños y niveles técnicos aprovechen al máximo el potencial de la inteligencia artificial. Con estas herramientas, se reduce la complejidad de gestionar la infraestructura, permitiendo que los equipos comiencen rápidamente a recibir predicciones de manera efectiva.