La inteligencia artificial generativa avanza a pasos agigantados, y con ella, herramientas como la Generación Aumentada por Recuperación (RAG) se están posicionando como esenciales para mejorar la precisión de las respuestas generadas por estos sistemas. RAG se centra en integrar datos adicionales que no fueron considerados en el entrenamiento de los modelos lingüísticos, ayudando a combatir las alucinaciones, un problema donde los sistemas de IA generan información imprecisa o engañosa.

Con la creciente integración de la inteligencia artificial en la vida diaria y en decisiones críticas, la capacidad de detectar y mitigar estas alucinaciones se convierte en una prioridad. Aunque las técnicas actuales se enfocan principalmente en el análisis de preguntas y respuestas, la disponibilidad de un contexto adicional mediante RAG permite innovar con nuevas metodologías más eficaces.

Se han propuesto varios métodos para construir sistemas de detección de alucinaciones en aplicaciones basadas en RAG. Un análisis reciente evalúa estos métodos en términos de precisión, recuperación y coste. Las técnicas que están emergiendo buscan ofrecer soluciones accesibles que puedan integrarse fácilmente en las canalizaciones RAG, mejorando así la calidad de las respuestas.

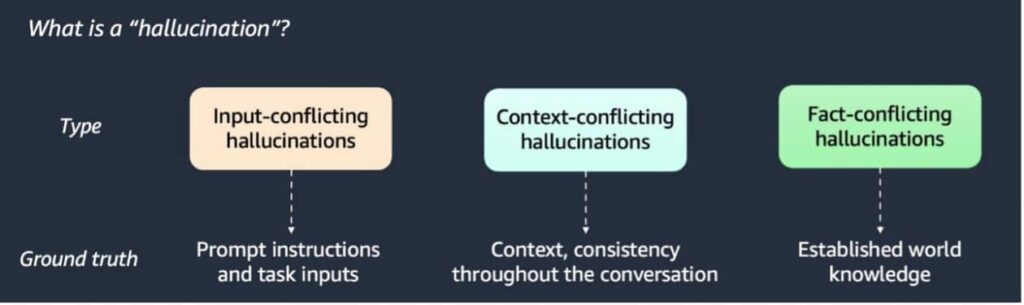

Diferenciando tres tipos de alucinaciones, se han desarrollado varias técnicas de detección destacando métodos como el detector basado en modelos de lenguaje avanzados (LLM), detectar similitudes semánticas, y el verificador estocástico BERT. Cada uno ofrece diferentes niveles de eficacia y velocidad, evaluados en enorme variedad de datos, incluidos artículos de Wikipedia y conjuntos de datos sintéticos.

Para operar eficazmente un sistema RAG, se requiere una cuenta en plataformas como AWS, con acceso a herramientas como Amazon SageMaker y Amazon S3. Es crucial almacenar el contexto relevante, la pregunta del usuario, y la respuesta generada.

El uso del detector basado en LLM permite clasificar respuestas del sistema RAG según su coherencia con el contexto proporcionado. Mientras que la similitud semántica y la comparación de tokens presentan variaciones en la identificación de inconsistencias. El verificador estocástico BERT se destaca por su alto rendimiento en recuperación de información, aunque su coste podría ser considerable.

Las evaluaciones sugieren que el método basado en LLM ofrece una buena relación entre precisión y coste. Por ello, se recomienda un enfoque híbrido que combine detección de similitud de tokens con LLM, resaltando la importancia de la adaptabilidad y el análisis profundo en aplicaciones de inteligencia artificial generativa. Conforme las herramientas de RAG evolucionan, estos métodos de detección de alucinaciones serán clave para mejorar la fiabilidad y la confianza en estos sistemas.