En el vertiginoso panorama de la inteligencia artificial, la Generación Aumentada por Recuperación (RAG) se ha convertido en un elemento revolucionario, transformando la manera en que los Modelos de Fundamento (FMs) interactúan con los datos específicos de las organizaciones. A medida que más empresas dependen de soluciones impulsadas por IA, la importancia de obtener respuestas precisas, contextualizadas y adaptadas nunca ha sido más crítica.

Una combinación de herramientas innovadoras—Amazon Bedrock, LlamaIndex y RAGAS—está cambiando el paradigma en la evaluación y optimización de las respuestas generadas mediante RAG. Este desarrollo se refleja en cómo estas herramientas colaboran para mejorar el rendimiento de las aplicaciones de IA, superando incluso los estándares más exigentes en las implementaciones empresariales.

Este artículo es esencial tanto para profesionales experimentados en inteligencia artificial como para líderes empresariales interesados en la IA generativa. Aquí se presentan conocimientos y herramientas clave para maximizar la eficacia de estas tecnologías, con un enfoque particular en el uso de los robustos modelos base de Amazon Bedrock y las completas métricas de evaluación de RAGAS para los sistemas RAG.

La evaluación de RAG es fundamental para asegurar que los modelos produzcan respuestas precisas, coherentes y relevantes. Mediante un análisis combinado e independiente de los componentes de recuperación y generación, es posible identificar cuellos de botella, monitorizar el rendimiento y mejorar el sistema en su totalidad. Sin embargo, las métricas probabilísticas actuales, como ROUGE, BLEU y BERTScore, tienen limitaciones en su capacidad para evaluar adecuadamente la relevancia y detectar errores o «alucinaciones». Para superar estas dificultades, es necesario desarrollar métricas más avanzadas que evalúen la alineación factual y la precisión.

Para evaluar los componentes de RAG con modelos de fundamento, se utilizan diversos modelos como jueces para calcular métricas relacionadas con la recuperación y generación. Por ejemplo, en el componente de recuperación, se mide la «precisión del contexto» para evaluar si los elementos relevantes están correctamente clasificados, y el «recall del contexto» para asegurar que toda la información necesaria esté incluida. En cuanto al componente generador, se verifica la «fidelidad» para comprobar si la respuesta generada es precisa según el contexto proporcionado, y la «relevancia de la respuesta» para medir cómo la respuesta se alinea con la consulta inicial.

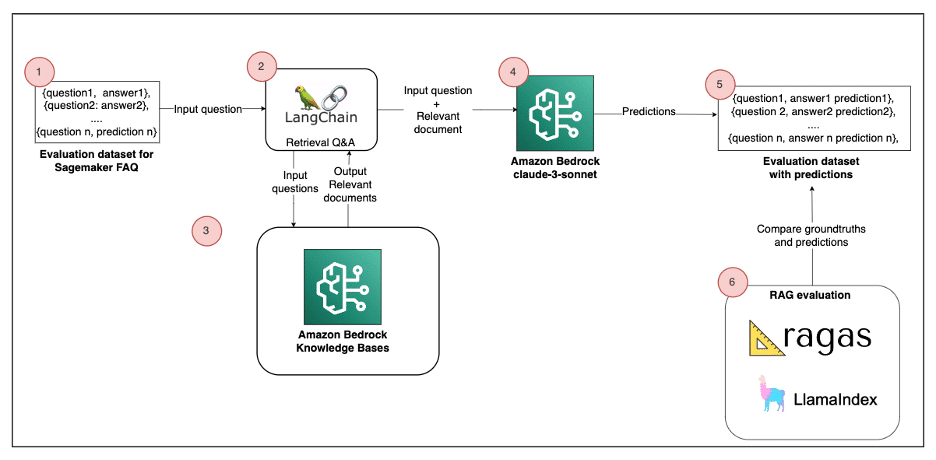

El artículo también expone un marco de evaluación utilizando RAGAS y LlamaIndex junto con Amazon Bedrock para crear una aplicación RAG de muestra. Amazon Bedrock aparece como un servicio completamente manejado, ofreciendo modelos de fundamento de alto rendimiento provenientes de empresas líderes en IA, lo cual permite a los desarrolladores construir aplicaciones generativas con un enfoque en la seguridad y privacidad.

Los diagramas arquitectónicos presentados ofrecen un esquema general de cómo evaluar soluciones RAG usando RAGAS o LlamaIndex. El proceso comienza con la creación de un conjunto de datos de evaluación que incorpora preguntas, contexto, respuestas generadas y respuestas de referencia. Este enfoque metódico tiene como objetivo evaluar el desempeño de las aplicaciones de IA y mejorar su confiabilidad.

Finalmente, el artículo concluye subrayando que, aunque los Modelos de Fundamento poseen capacidades generativas impresionantes, su efectividad para resolver consultas específicas de las organizaciones ha sido un reto persistente. La RAG surge como una poderosa solución para superar esta brecha. Junto a RAGAS y LlamaIndex, proporciona un enfoque integral para evaluar y optimizar estas aplicaciones. Con la adopción de estas innovaciones, las organizaciones pueden avanzar con confianza hacia un futuro emocionante en la IA generativa, desbloqueando nuevas eficiencias y ventajas competitivas.