El despliegue de soluciones de inteligencia artificial generativa a nivel global enfrenta desafíos significativos, especialmente al evaluar la calidad de las respuestas en múltiples idiomas. Las organizaciones se ven comprometidas en mantener un rendimiento constante, dado que las evaluaciones humanas requieren recursos considerables, particularmente en diversas lenguas. Muchas empresas luchan por escalar sus procesos de evaluación sin sacrificar calidad ni repercutir negativamente en sus presupuestos.

En este contexto, Amazon Bedrock Evaluations se presenta como una solución eficiente con su capacidad de LLM-as-a-judge, que permite evaluar salidas de IA de manera consistente a través de las barreras lingüísticas. Esta metodología reduce el tiempo y recursos que suelen ser necesarios para llevar a cabo evaluaciones multilingües, al mismo tiempo que se sostienen altos estándares de calidad.

Utilizando las funcionalidades de evaluación de Amazon Bedrock, se busca ofrecer resultados fiables que atraviesen las barreras idiomáticas sin necesidad de implementar infraestructuras localizadas o prompts personalizados. A través de pruebas y análisis exhaustivos, se proponen estrategias prácticas que posibilitan la reducción del costo y la complejidad de las evaluaciones multilingües.

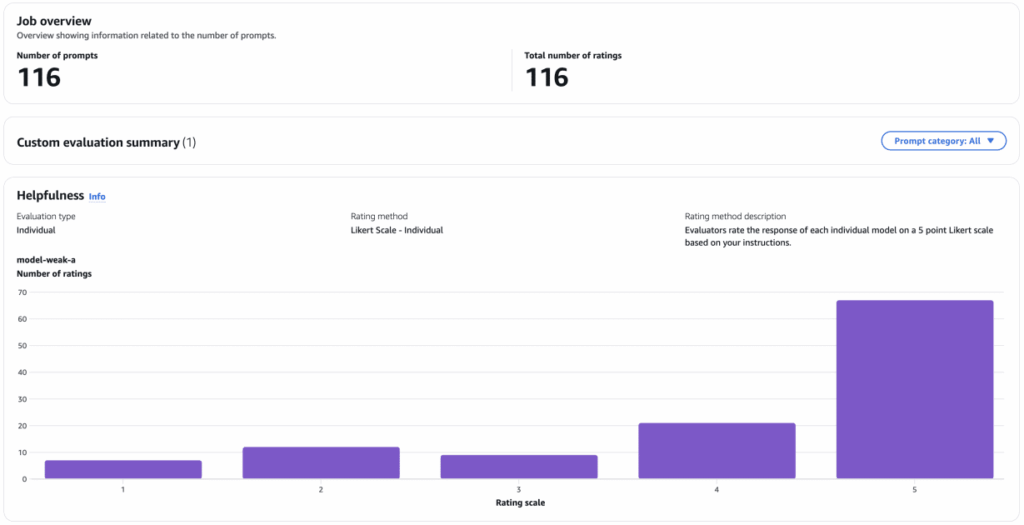

El proceso de evaluación se simplifica mediante Amazon Bedrock Evaluations, que ofrece tanto métodos automáticos como humanos para valorar la calidad de los modelos. Las evaluaciones automáticas permiten elegir entre métricas integradas o definir métricas personalizadas, permitiendo así la evaluación de modelos tanto internos como externos. Por otro lado, las evaluaciones humanas son clave para establecer una referencia de comparación contra las puntuaciones automáticas, brindando un respaldo necesario en casos donde se requiere juicio de expertos.

En el proceso de preparación de conjuntos de datos para la evaluación, se emplearon divisiones en indonesio de un popular conjunto de datos de evaluación conversacional. Se transformaron las conversaciones multigeneracionales en interacciones de un solo turno, haciendo que cada turno se evaluara de manera independiente y coherente. Esto dio como resultado una serie completa de registros evaluativos, que fueron analizados utilizando un modelo más robusto y uno más débil para generar respuestas.

Para establecer un punto de referencia en las evaluaciones humanas, se realizó una comparación de las puntuaciones de efectividad otorgadas por evaluadores humanos con las proporcionadas por los LLMs. La tendencia mostró que, en los modelos más fuertes, los jueces LLM coincidieron en gran medida con las calificaciones humanas, aunque en los modelos más débiles, las puntuaciones se elevaron notablemente en comparación con las evaluaciones de los humanos.

Este análisis también dio lugar a la exploración de la correlación entre los puntajes obtenidos. Los resultados evidenciaron un fuerte alineamiento entre los jueces LLM y las evaluaciones humanas en respuestas de modelos más débiles, mientras que el alineamiento para los modelos más fuertes fue más moderado.

La evaluación cruzada entre diferentes idiomas demostró que los resultados permanecieron consistentes, confirmando que, aunque la traducción de prompts es útil, no es estrictamente necesaria para obtener evaluaciones coherentes. Los datos indican que el uso de prompts de evaluación en inglés puede ser efectivo incluso para resultados generados en otros idiomas, lo que facilita la expansión y la escalabilidad de las evaluaciones de IA a nivel global.

La conclusión de este análisis resalta que los métodos de LLM-as-a-judge son prácticos y ofrecen una evaluación más rápida y económica, siendo adecuados para implementaciones a gran escala. La importancia de las evaluaciones humanas sigue siendo crucial para establecer un estándar de referencia y garantizar que las evaluaciones automatizadas se alineen efectivamente con las expectativas de los usuarios finales.