Los modelos de lenguaje grandes (LLMs) han emergido como una solución prometedora en las tareas de traducción automática, mostrando capacidades que los posicionan como competidores de los modelos tradicionales de traducción neuronal, como Amazon Translate. Estos modelos destacan por su habilidad para aprender del contexto del texto de entrada, lo que les permite captar y reflejar matices culturales importantes, produciendo traducciones que resultan más naturales.

Un ejemplo de esta capacidad es la traducción de preguntas simples que, dependiendo del contexto, pueden variar en su interpretación y forma. Por ejemplo, la pregunta «¿Te desempeñaste bien?» podría requerir un enfoque distinto en francés según el ámbito, como en un torneo deportivo, donde el contexto cultural juega un rol determinante. Así, es esencial que las soluciones de inteligencia artificial no solo entiendan el contexto, sino también las sutilezas culturales para asegurar traducciones precisas y fluidas.

La demanda de LLMs para enriquecer la calidad del contenido traducido sigue creciendo a nivel global. El proceso conocido como Traducción Automática con Edición Posterior (MTPE) combina automatización con intervención humana, ofreciendo múltiples beneficios como reducción de costos y tiempos de entrega más rápidos, además de una experiencia más robusta para los usuarios finales del contenido traducido.

Sin embargo, los LLMs también enfrentan desafíos en traducción automática, tales como variaciones de calidad entre diferentes pares de idiomas y la falta de un estándar para integrar memoria de traducción (TM), un recurso crítico que almacena traducciones previas para mantener la consistencia. Además, los modelos corren el riesgo de «alucinación», cuando generan respuestas que no se alinean con el contenido de entrada.

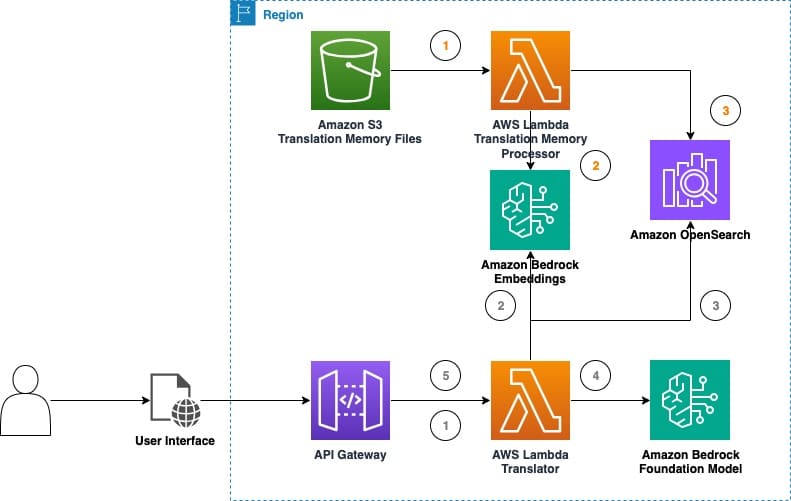

La industria está evaluando cómo integrar mejor las capacidades de los LLMs en flujos de trabajo de traducción automática, reconociendo un potencial significativo que justifica su consideración. Amazon Bedrock, por ejemplo, ofrece una solución innovadora para experimentar con traducción automática en tiempo real mediante la utilización de estos modelos. Esta solución incorpora técnicas de memoria de traducción y archivos TMX, fundamentales en herramientas de traducción asistida por computadora y sistemas de gestión.

La integración de memorias de traducción con LLMs puede elevar tanto la calidad como la eficiencia de la traducción automática. Al utilizar traducciones de alta calidad de las TMs, los LLMs pueden lograr traducciones más precisas y consistentes, adaptándose mejor a terminologías específicas de cada dominio y estilo de contenido. El uso de memoria de traducción también minimiza el esfuerzo de edición posterior, resultando en mayor productividad y ahorros en costos operativos.

El «parque de pruebas de traducción LLM» es una herramienta que permite explorar y evaluar las capacidades de traducción de los LLMs, facilitando la creación y comparación de diferentes configuraciones de inferencia y el impacto de estrategias de ingeniería de prompts.

Los experimentos han mostrado cómo los LLMs se adaptan al contexto de las frases, mejorando significativamente la calidad de la traducción y enriqueciendo la experiencia del usuario. Al integrar memorias de traducción, se observó un aumento notable en la calidad de las traducciones, lo que sugiere que estas tecnologías combinadas son cruciales para el futuro de la localización y traducción de contenido.

A medida que se sigue explorando el potencial de los LLMs para la traducción automática, se anticipa no solo una mejora en la calidad de los resultados, sino también en la eficiencia y accesibilidad del proceso de localización para empresas de diversos tamaños.