Google ha publicado el proyecto Gemini Fullstack LangGraph Quickstart, una herramienta de código abierto destinada a desarrolladores que deseen crear agentes conversacionales potentes y orientados a la investigación web. El proyecto combina una interfaz en React con un backend inteligente basado en LangGraph y los modelos de lenguaje Gemini 2.5, todo ello con el objetivo de crear respuestas documentadas y fundamentadas en fuentes reales.

La iniciativa supone un paso adelante en el desarrollo de IA generativa basada en búsquedas reales, donde el modelo no solo genera respuestas, sino que busca activamente información en internet, analiza carencias de conocimiento y refina sus búsquedas de forma iterativa hasta obtener un resultado sólido y citable.

Una arquitectura completa para agentes IA orientados a la investigación

El proyecto se estructura en dos componentes principales:

- Frontend en React (carpeta

/frontend) con Vite, Tailwind CSS y componentes de Shadcn UI. - Backend en FastAPI con LangGraph (carpeta

/backend), donde vive el “agente de investigación”.

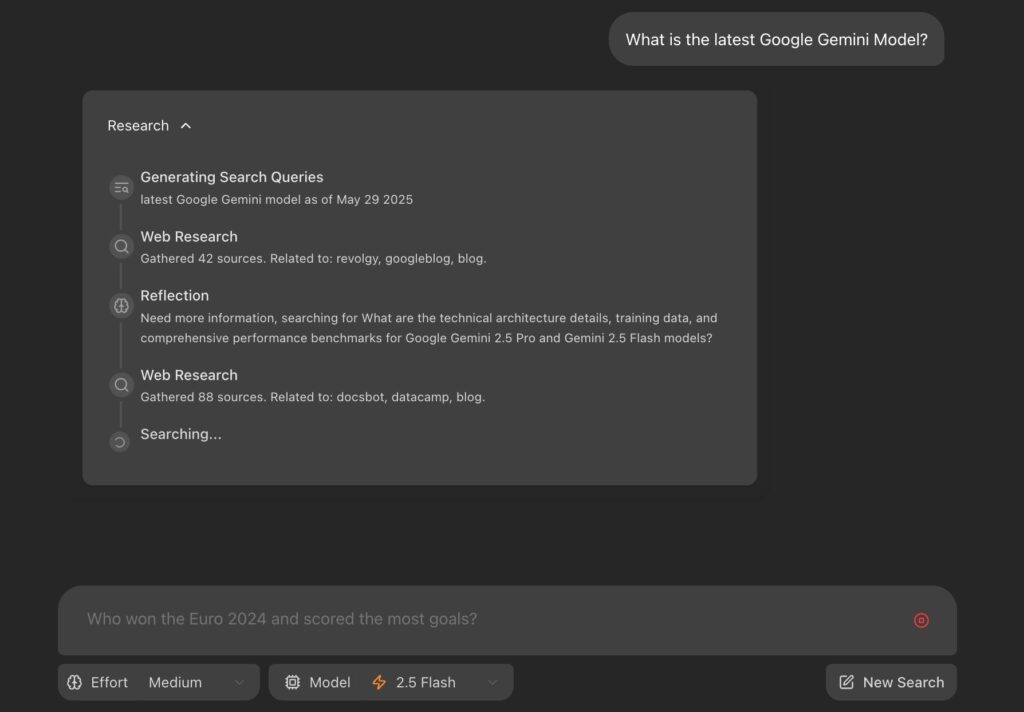

Este agente funciona de forma cíclica: recibe una consulta del usuario, genera búsquedas con ayuda de Gemini, utiliza la API de Google Search para rastrear contenido web, evalúa si ha encontrado información suficiente, y si no, continúa buscando hasta cerrar los huecos. Finalmente, redacta una respuesta con citas, lo que lo convierte en una herramienta ideal para tareas que exigen verificación documental, como informes técnicos o investigaciones académicas.

¿Cómo funciona el agente LangGraph?

El flujo de trabajo del agente backend, definido en graph.py, se desarrolla en varias etapas:

- Generación de consultas iniciales: A partir del input del usuario.

- Búsqueda en la web: Usa Google Search API y Gemini para identificar páginas relevantes.

- Reflexión y análisis: El agente evalúa las respuestas encontradas y detecta lagunas informativas.

- Búsqueda iterativa: Si faltan datos, reinicia el ciclo hasta un número límite de iteraciones.

- Respuesta final: Redacta una respuesta coherente con citas a las fuentes empleadas.

Este enfoque reflexivo y dinámico representa una evolución frente a los asistentes actuales, que suelen depender de información previamente entrenada, sin acceso a información actualizada.

Desarrollo local y despliegue en producción

El proyecto está listo para desarrollo local mediante el uso de Node.js y Python 3.8+, y requiere una clave de API de Gemini para funcionar. El backend y el frontend pueden ejecutarse por separado o con un comando unificado (make dev). La versión de producción incluye una imagen Docker con el frontend ya compilado y requiere instancias de Redis y PostgreSQL para manejar estados y tareas en segundo plano.

La solución está preparada para implementaciones escalables, haciendo uso de la API de LangSmith y permitiendo transmisión de resultados en tiempo real.

Tecnologías empleadas

El stack tecnológico del proyecto incluye:

- React + Vite: interfaz web veloz y moderna.

- Tailwind CSS + Shadcn UI: diseño estilizado y componentes listos para usar.

- LangGraph: motor conversacional con flujos controlados y estado persistente.

- Google Gemini 2.5: modelo de lenguaje que guía cada paso del agente.

- Google Search API: búsqueda contextualizada en tiempo real.

Una base sólida para agentes de nueva generación

Con esta plantilla, Google no solo ofrece un ejemplo funcional, sino un punto de partida robusto para construir agentes fullstack especializados en tareas complejas de recuperación y síntesis de información. Aplicaciones como asistentes jurídicos, herramientas de apoyo a la redacción académica o interfaces para toma de decisiones empresariales se pueden construir rápidamente sobre esta base.

El código está disponible públicamente en GitHub bajo licencia Apache 2.0.