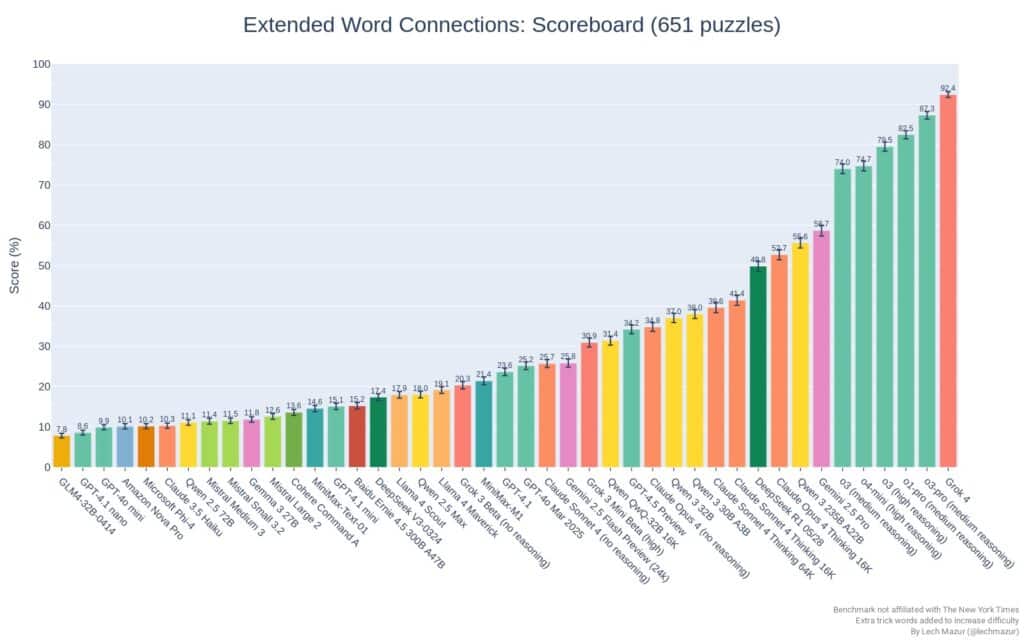

El modelo de xAI lidera el ranking con un 92,4 % de aciertos en 651 rompecabezas, en un test que pone a prueba el razonamiento semántico de las inteligencias artificiales más avanzadas.

El modelo de lenguaje Grok 4 se ha alzado como el más competente en el nuevo benchmark Extended NYT Connections, una evaluación que enfrenta a modelos de inteligencia artificial con una versión ampliada y más difícil del famoso juego de lógica del New York Times. La prueba, publicada por el investigador independiente Lech Mazur en GitHub, mide la capacidad de los modelos para agrupar correctamente palabras según relaciones semánticas, un desafío que exige razonamiento contextual y comprensión avanzada del lenguaje.

Grok 4 ha alcanzado una tasa de aciertos del 92,4 % sobre un total de 651 puzzles, superando tanto a sus competidores tecnológicos como a los propios humanos, cuyo promedio se sitúa en el 71 % según datos oficiales del NYT entre diciembre de 2024 y febrero de 2025.

Un test con trampas: así funciona el benchmark

A diferencia de la versión original del juego, esta edición “extendida” añade entre una y cuatro palabras trampa por rompecabezas. Estas palabras están diseñadas para despistar, ya que no encajan en ninguno de los grupos correctos, lo que obliga a los modelos a afinar su capacidad de clasificación conceptual. Además, los modelos tienen solo un intento por puzzle, frente a los cuatro que se permiten a los jugadores humanos en la web del NYT.

Esta limitación convierte el benchmark en una herramienta más exigente y realista para medir razonamiento puro sin depender de intentos sucesivos o pistas.

IA vs humanos: ¿superan ya los modelos a las personas?

Los resultados son reveladores. Mientras el jugador medio humano resolvió el 71 % de los puzzles, el modelo Grok 4 supera ampliamente esa cifra. Otros modelos destacados como o3-pro (87,3 %) y o1-pro (82,5 %) también rinden por encima del promedio humano. El modelo o1 incluso logró una tasa de éxito del 98,9 % en simulaciones que imitan la experiencia de juego humana, rozando el nivel de los jugadores élite que resuelven el 100 % de los desafíos.

En el otro extremo, algunos modelos populares como GPT-4o, Gemini 2.5 Flash y Claude Sonnet 4 (sin razonamiento activado) muestran resultados decepcionantes, muy por debajo del 30 % de aciertos.

Tabla comparativa: los 15 primeros modelos

A continuación, se muestra el rendimiento de los 15 modelos mejor clasificados en el benchmark extendido:

| Posición | Modelo | Puntuación (%) | Nº de puzzles resueltos |

|---|---|---|---|

| 1 | Grok 4 | 92,4 | 651 |

| 2 | o3-pro (medium reasoning) | 87,3 | 651 |

| 3 | o1-pro (medium reasoning) | 82,5 | 651 |

| 4 | o3 (high reasoning) | 79,5 | 651 |

| 5 | o4-mini (high reasoning) | 74,7 | 651 |

| 6 | o3 (medium reasoning) | 74,0 | 651 |

| 7 | o1 (medium reasoning) | 70,8 | 651 |

| 8 | o4-mini (medium reasoning) | 68,8 | 651 |

| 9 | o3-mini (high reasoning) | 61,4 | 651 |

| 10 | Gemini 2.5 Pro | 58,7 | 651 |

| 11 | Qwen 3 235B A22B | 55,6 | 651 |

| 12 | Gemini 2.5 Pro Exp 03-25 | 54,1 | 651 |

| 13 | o3-mini (medium reasoning) | 53,6 | 651 |

| 14 | Claude Opus 4 Thinking 16K | 52,7 | 651 |

| 15 | DeepSeek R1 05/28 | 49,8 | 651 |

¿Qué implica este resultado para el futuro de la IA?

La destacada actuación de Grok 4 supone un golpe de efecto para xAI, la empresa fundada por Elon Musk. Su modelo no solo supera a los desarrollos de OpenAI, Google DeepMind y Anthropic en esta tarea específica, sino que lo hace en una disciplina crítica para aplicaciones como tutoría personalizada, razonamiento jurídico o asistencia científica, donde la agrupación semántica es clave.

Este tipo de benchmarks también sirven para detectar cuellos de botella y limitaciones en modelos generalistas, que a menudo brillan en tareas conversacionales pero fallan cuando se enfrentan a lógica estructurada o problemas tipo puzzle.

Una herramienta comunitaria para evaluar el razonamiento de LLMs

El repositorio lechmazur/nyt-connections, disponible en GitHub, ya se ha convertido en una referencia para la comunidad técnica que busca comparar modelos más allá de métricas estándar. Incluye también versiones reducidas para los 100 puzzles más recientes, lo que permite evitar sesgos por datos de entrenamiento y medir el desempeño en desafíos actuales.

Lech Mazur continúa actualizando el benchmark con nuevos modelos, ampliaciones del corpus de puzzles y experimentos que exploran la diferencia entre capacidades humanas e inteligencia artificial. Todo el código está escrito en Python y es completamente público, fomentando la transparencia y la reproducibilidad en la evaluación de modelos.

Con benchmarks como este, el debate sobre si los modelos actuales de IA han alcanzado o superado las capacidades humanas ya no es filosófico, sino técnico y medible. Y al menos en lo que respecta al razonamiento semántico, Grok 4 ya marca la diferencia.