En el ámbito de la inteligencia artificial, los modelos de lenguaje de gran tamaño (LLMs) están revolucionando la creación de contenido de alta calidad. Gracias a la formación en datasets con miles de millones de tokens, estos modelos son la base de muchas aplicaciones populares de IA, como chatbots, asistentes y generadores de código.

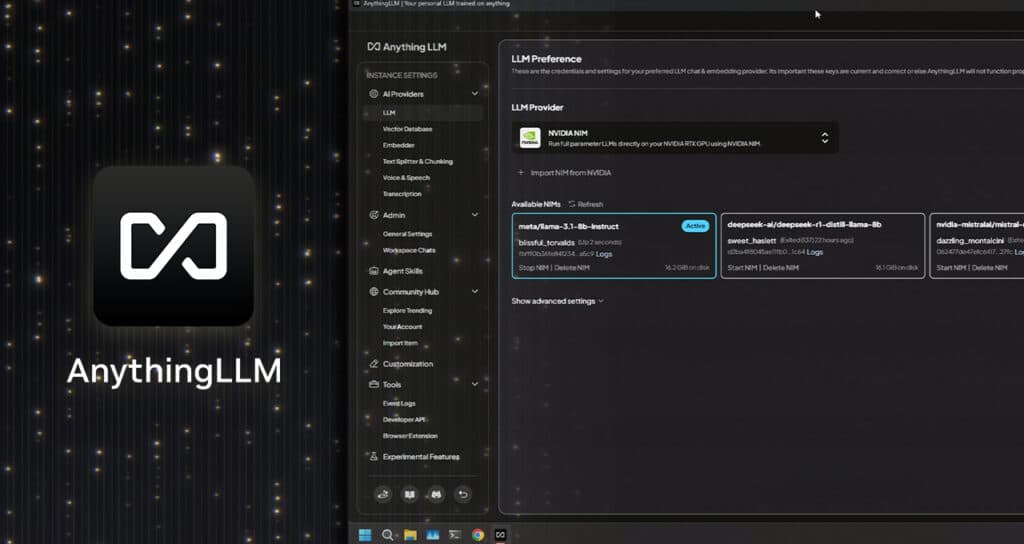

Una de las formas más accesibles para trabajar con estos modelos es a través de AnythingLLM, una aplicación de escritorio diseñada para aquellos que buscan un asistente de inteligencia artificial centrado en la privacidad, directamente en su PC.

Recientemente, AnythingLLM ha incorporado soporte para los microservicios NVIDIA NIM en GPUs NVIDIA GeForce RTX y NVIDIA RTX PRO, lo que permite a los usuarios disfrutar de un rendimiento aún más rápido para flujos de trabajo locales de IA más receptivos.

AnythingLLM es una aplicación integral de IA que permite a los usuarios ejecutar localmente LLMs, sistemas de generación aumentada por recuperación (RAG) y herramientas agenticas. Este software actúa como un puente entre los LLMs preferidos por el usuario y sus datos, facilitando el acceso a herramientas específicas para tareas como la respuesta a preguntas, consultas de datos personales y análisis de documentos.

Además, AnythingLLM se conecta a una amplia variedad de LLMs de código abierto y modelos más grandes en la nube de proveedores como OpenAI y Microsoft. Con una instalación de un solo clic, es una opción atractiva para los entusiastas de la IA, especialmente aquellos con sistemas equipados con GPUs GeForce RTX y NVIDIA RTX PRO.

Las GPUs RTX ofrecen mejoras significativas en el rendimiento al ejecutar LLMs y agentes en AnythingLLM. Esto acelera la inferencia gracias a los Tensor Cores diseñados para impulsar la IA. Ejemplos como la ejecución de LLMs con Ollama para ejecución en dispositivo muestran mejoras notables, con optimizaciones específicas para las GPUs NVIDIA RTX.

La reciente adición del soporte para los microservicios NVIDIA NIM ofrece modelos de IA generativa preempaquetados y optimizados que simplifican el inicio de flujos de trabajo de IA en PCs con RTX AI. Estos servicios son ideales para desarrolladores que desean probar rápidamente modelos de IA generativa, con la posibilidad de ejecutar tanto en la nube como localmente en sus PC.

Con el crecimiento de las bibliotecas de Blueprints de IA de NVIDIA, herramientas como AnythingLLM desbloquearán aún más casos de uso multimodal para la inteligencia artificial, expandiendo las fronteras de lo que es posible crear con estas tecnologías avanzadas.

Fuente: Zona de blogs y prensa de Nvidia