La startup europea redefine la velocidad de generación de tokens para aplicaciones de inteligencia artificial en tiempo real, apoyando la soberanía digital con tecnología desarrollada en Francia

La empresa emergente Kog AI, especializada en plataformas de inteligencia artificial en tiempo real, ha anunciado un hito significativo en el rendimiento de inferencia con su motor Kog Inference Engine, al alcanzar una velocidad hasta 3,5 veces superior en la generación de tokens respecto a soluciones líderes del mercado. Este avance ha sido logrado utilizando los procesadores gráficos AMD Instinct™ MI300X, y supone un cambio de paradigma en la forma en que se aborda la inferencia en modelos de lenguaje.

En un entorno donde la inferencia —y no el entrenamiento— se ha convertido en el principal cuello de botella para las aplicaciones de IA escalables, la rapidez en la generación de tokens por solicitud individual es clave. Modelos de razonamiento, agentes inteligentes y flujos conversacionales dependen de una respuesta secuencial rápida, algo que las soluciones tradicionales, optimizadas para chatbots y rendimiento agregado, no logran solventar eficazmente.

Desbloqueando el rendimiento real de la inferencia

La propuesta de Kog parte de una reimaginación total del proceso de inferencia, abandonando los marcos de trabajo genéricos y centrándose en una optimización radical. A través de programación en C++ y código ensamblador, el motor Kog reduce las ineficiencias típicas de las librerías actuales, especialmente en la comunicación entre múltiples GPUs.

Entre los resultados más destacados del benchmark inicial:

- Hasta 3,5× más rápida la generación de tokens en comparación con vLLM y TensorRT-LLM sobre AMD Instinct MI300X.

- Latencia inter-GPU récord de 4 microsegundos, hasta 4 veces más rápida que bibliotecas de comunicación estándar.

- Superioridad constante en modelos desde 1.000 millones hasta 32.000 millones de parámetros, incluyendo arquitecturas Llama, Mistral y Qwen.

Además, Kog muestra un rendimiento excepcional en modelos pequeños (1B–7B), permitiendo su especialización y ajuste fino para tareas específicas con una eficiencia que rivaliza con modelos mucho más grandes, pero con costes notablemente menores y velocidades hasta 10 veces superiores.

Tecnología europea para la próxima generación de IA

Uno de los componentes clave de este avance ha sido la creación de KCCL (Kog Collective Communications Library), diseñada para minimizar la latencia en entornos multi-GPU, un obstáculo habitual en cargas de trabajo de inferencia a gran escala. Esto permite a Kog desplegar su tecnología tanto en formato API como en contenedores Docker, adaptándose a necesidades concretas de latencia, procesamiento de voz o throughput.

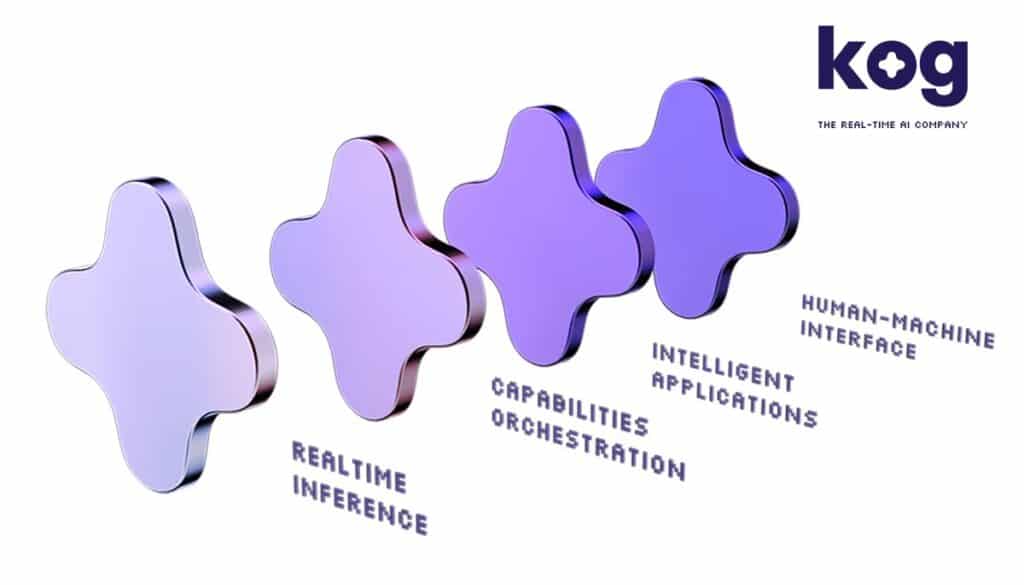

Kog AI, con sede en Francia, representa una nueva generación de empresas europeas que apuestan por la soberanía digital mediante innovación propia en infraestructura de IA. Su plataforma de inferencia en tiempo real está pensada para aplicaciones que requieren interacción inmediata entre humanos y máquinas, desde asistentes conversacionales a sistemas de voz en tiempo real o agentes autónomos inteligentes.

El anuncio no solo destaca por sus logros técnicos, sino por el mensaje geopolítico implícito: Europa puede liderar en áreas clave de la inteligencia artificial sin depender exclusivamente de marcos de software o infraestructuras estadounidenses o asiáticas.

Mientras la demanda de inferencia de alto rendimiento sigue creciendo de forma exponencial, soluciones como la de Kog AI, combinadas con el músculo computacional de AMD, ofrecen una alternativa competitiva, eficiente y alineada con los valores de independencia tecnológica del continente.

vía: amd.com