La solución de ingeniería Langfuse se consolida como un pilar en la creación, evaluación y monitorización de aplicaciones basadas en modelos de lenguaje. Disponible como servicio gestionado o para autoalojar, su propuesta de trazabilidad y control impulsa la nueva ola del LLMOps.

En un entorno donde el desarrollo con modelos de lenguaje (LLMs) se ha convertido en el centro de muchas aplicaciones empresariales, plataformas como Langfuse están ganando una relevancia estratégica. Este proyecto de código abierto, incubado en la aceleradora Y Combinator (W23), ofrece una solución integral para equipos de ingeniería que construyen, evalúan y mantienen aplicaciones alimentadas por inteligencia artificial generativa.

Langfuse no solo es compatible con infraestructuras locales, sino que también puede desplegarse en entornos cloud —como AWS, Azure o GCP— mediante plantillas Terraform o Helm Charts para Kubernetes. Su enfoque modular y API-first le permite integrarse de forma fluida en cualquier flujo de trabajo de LLMOps, desde startups hasta grandes corporaciones.

Una caja de herramientas para la trazabilidad de la IA generativa

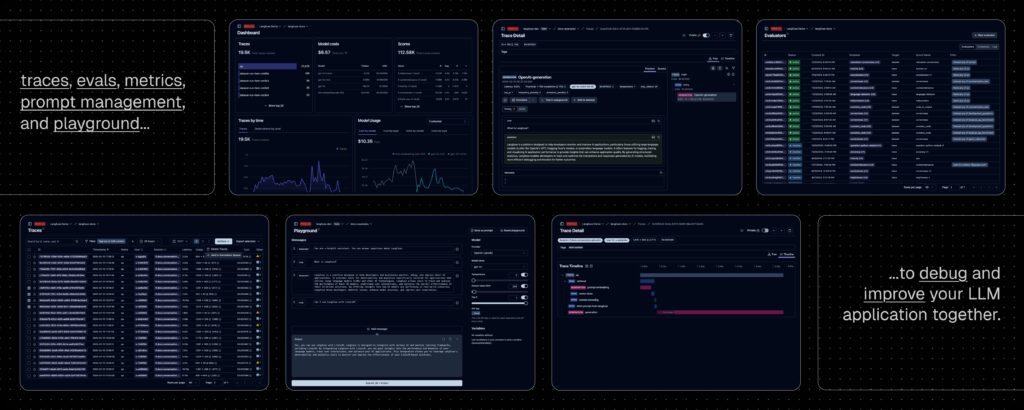

Entre sus principales funcionalidades destacan:

- Observabilidad de LLMs: Langfuse permite instrumentar aplicaciones para rastrear llamadas a modelos de lenguaje, procesos de recuperación, embeddings, agentes y más. Cada sesión se transforma en un rastro navegable, útil para auditoría, depuración y mejora continua.

- Gestión de prompts: Centraliza y versiona los prompts utilizados en las aplicaciones. Esto facilita la colaboración entre desarrolladores, mantiene la trazabilidad de cambios y permite experimentar sin introducir latencia adicional gracias al caching avanzado.

- Evaluaciones personalizadas: Langfuse permite implementar evaluaciones automáticas (LLM-as-a-judge), etiquetado manual, recogida de feedback del usuario y pipelines personalizados de evaluación, todo ello integrable por SDK o API.

- Datasets y pruebas estructuradas: A través de su sistema de conjuntos de datos, los equipos pueden crear benchmarks reutilizables para probar aplicaciones antes de su despliegue. Compatible con LangChain, LlamaIndex y otros frameworks del ecosistema.

- LLM Playground: Un entorno de pruebas interactivo para iterar rápidamente sobre prompts y configuraciones de modelo. Desde cualquier traza, los desarrolladores pueden saltar directamente al playground para experimentar y corregir resultados inadecuados.

Implantación versátil: de Docker local a Kubernetes en producción

Langfuse destaca por su flexibilidad de despliegue. Puede instalarse en local en cinco minutos con Docker Compose, configurarse en una máquina virtual o ejecutarse en clusters Kubernetes mediante Helm Charts. Las empresas que no deseen gestionar la infraestructura pueden optar por Langfuse Cloud, una versión gestionada con generoso plan gratuito y sin tarjeta de crédito requerida.

La plataforma ofrece SDKs para Python y JavaScript/TypeScript, con soporte nativo para instrumentar modelos de OpenAI, LangChain, LlamaIndex, Haystack, LiteLLM y muchos más. Además, su API abierta permite construir flujos completamente personalizados, convirtiéndose en una base sólida para herramientas internas de observabilidad y evaluación.

Integraciones con el ecosistema AI

Langfuse se integra con herramientas y plataformas clave del entorno de desarrollo LLM:

- Frameworks: LangChain, DSPy, Mirascope, AutoGen, CrewAI, Goose, smolagents.

- Interfaces de usuario: Flowise, Langflow, Dify, OpenWebUI, Gradio.

- Modelos y plataformas: Ollama (local), Amazon Bedrock, HuggingFace, Vercel AI SDK.

- Herramientas de evaluación: Promptfoo, Promptfoo CLI.

Además, Langfuse se encuentra en el núcleo de algunos de los proyectos open source más destacados del momento, como Dify, LobeChat, OpenWebUI, Langflow, o MindsDB.

Privacidad y seguridad: compromiso con el control del usuario

Aunque Langfuse recopila métricas de uso anónimas por defecto a través de PostHog en instalaciones autoalojadas, la empresa garantiza que no se recogen datos sensibles y permite desactivar la telemetría con una sola variable de entorno (TELEMETRY_ENABLED=false).

Este enfoque transparente refuerza su atractivo en sectores regulados o sensibles a la privacidad, permitiendo a las organizaciones tener el control total sobre sus datos y su infraestructura.

Conclusión: una infraestructura crítica para la nueva era del desarrollo con IA

Con el auge imparable de los modelos de lenguaje y su incorporación masiva en productos y servicios, herramientas como Langfuse se vuelven imprescindibles. Ya no basta con tener un modelo generativo; las empresas necesitan observabilidad, evaluación sistemática y colaboración ágil en entornos de producción.

Langfuse se posiciona como un componente esencial del stack moderno de ingeniería LLM, combinando lo mejor del código abierto con una visión centrada en el rendimiento, la trazabilidad y la seguridad. Disponible en GitHub bajo licencia MIT, su rápida adopción por parte de grandes comunidades lo convierte en una solución robusta, madura y en constante evolución.

📎 Más información: https://langfuse.com | https://github.com/langfuse/langfuse