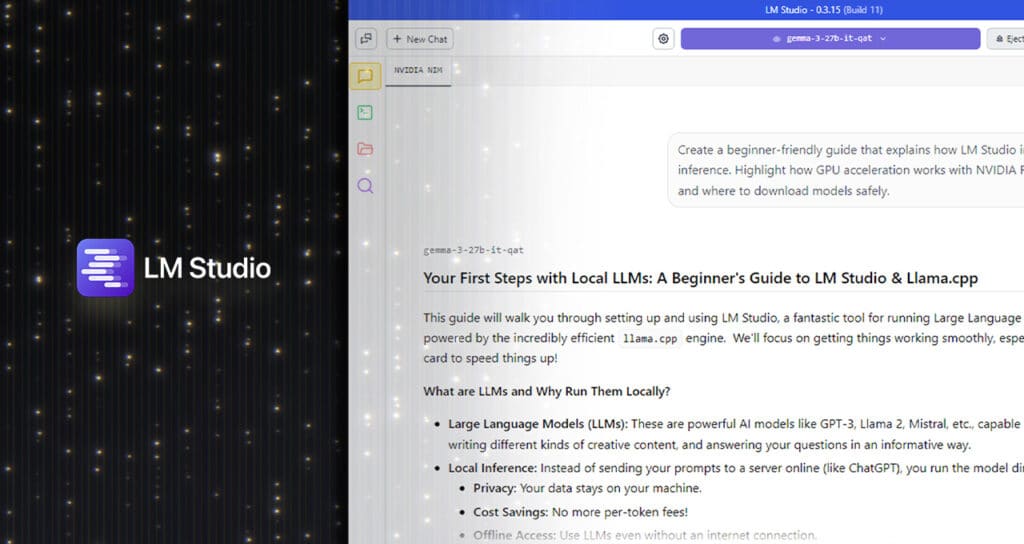

La inteligencia artificial generativa no para de expandirse, y con ella crecen las necesidades de rendimiento y privacidad por parte de desarrolladores, investigadores y entusiastas. Ejecutar modelos de lenguaje (LLM) localmente, en lugar de depender de servicios en la nube, se ha convertido en una opción cada vez más atractiva. En este escenario, LM Studio, una herramienta gratuita y de código abierto, se consolida como una de las opciones más potentes para ejecutar LLMs directamente en ordenadores personales equipados con GPUs NVIDIA GeForce RTX.

La última versión, LM Studio 0.3.15, marca un hito importante al incorporar soporte completo para CUDA 12.8, optimizando el rendimiento de los modelos con mejoras que llegan a acelerar hasta un 27 % el procesamiento en GPUs como la GeForce RTX 5080, gracias al backend mejorado de llama.cpp, motor que impulsa este entorno de inferencia.

Inferencia local: privacidad, velocidad y control

A diferencia de las soluciones en la nube, LM Studio permite a los usuarios mantener los datos de entrada localmente, lo que garantiza una mayor privacidad y control sobre el despliegue de los modelos. La herramienta es compatible con los principales sistemas operativos —Windows, macOS y Linux— y facilita la integración con flujos de trabajo personalizados mediante una API compatible con OpenAI.

Casos de uso como la generación de texto en Obsidian, VS Code, asistentes de escritorio o workflows con agentes inteligentes se benefician directamente de esta infraestructura local, que permite acelerar tareas de resumen de documentos, preguntas sobre texto, programación y más.

Rendimiento mejorado con CUDA 12.8

Con la integración de CUDA 12.8, LM Studio introduce mejoras de rendimiento clave:

| Optimización | Beneficio técnico | Impacto en rendimiento |

|---|---|---|

| CUDA Graphs | Agrupación de operaciones GPU en una sola llamada desde la CPU | Hasta un +35 % de eficiencia |

| Flash Attention | Optimiza la operación de atención en modelos tipo transformer | +15 % en velocidad en tareas con contextos largos |

| Compatibilidad completa con RTX | Soporte desde la serie RTX 20 hasta Blackwell | Flexibilidad total en equipos nuevos y antiguos |

Estas mejoras permiten inferencias más fluidas, menor tiempo de carga de modelos y un uso más eficiente del hardware disponible, sin necesidad de recurrir a servidores externos ni a infraestructuras costosas.

Nuevas funciones para desarrolladores

El último lanzamiento de LM Studio no se limita al rendimiento. También presenta capacidades mejoradas para desarrolladores:

- tool_choice: Control granular sobre el uso de herramientas externas por parte del modelo (forzado, desactivado o dinámico).

- Editor de prompt del sistema rediseñado: Facilita prompts más largos y complejos.

- Compatibilidad con modelos como Llama 3, Gemma, Mistral y Orca, y múltiples formatos de cuantización, de 4-bit a precisión completa.

Estas funciones hacen de LM Studio una plataforma robusta tanto para entornos de prueba como para despliegues en producción.

Pasos para activar CUDA 12.8 y optimizar LM Studio

- Descargar LM Studio y abrir la aplicación.

- En el panel lateral, seleccionar «Discover» > buscar Runtime CUDA 12 llama.cpp (Windows).

- Instalar y configurarlo como runtime por defecto.

- Cargar un modelo y activar “Flash Attention” y “GPU Offload” al máximo en la configuración.

Con esto, la inferencia acelerada por GPU estará lista, ofreciendo una experiencia de uso superior.

Conclusión: el futuro de la IA local es ahora

LM Studio representa una alternativa poderosa y flexible para quienes desean trabajar con modelos de lenguaje sin depender de la nube. Su combinación con la potencia de las GPUs RTX y el ecosistema CUDA de NVIDIA lo convierte en una de las opciones más eficientes para acelerar cargas de trabajo de IA en ordenadores personales.

En un contexto donde la privacidad, la velocidad y el control sobre los datos son cada vez más valorados, herramientas como LM Studio marcan el camino hacia una inteligencia artificial más accesible, descentralizada y personal.

vía: Nvidia