Un nuevo estudio académico ha puesto en evidencia una preocupante limitación de los modelos de lenguaje multimodal (VLM, por sus siglas en inglés), al demostrar que fallan sistemáticamente en tareas visuales simples cuando las imágenes contienen alteraciones sutiles. El trabajo, firmado por investigadores de KAIST, University of Alberta, Auburn University y el College of William and Mary, concluye que los VLM actuales no analizan las imágenes realmente: simplemente reconocen patrones memorizados.

El estudio introduce VLMBias, un marco de evaluación que compara el rendimiento de varios VLM de última generación ante imágenes originales y sus versiones modificadas. La diferencia es alarmante: mientras que los modelos aciertan en el 100 % de los casos al identificar objetos conocidos (como el logotipo de Adidas con 3 franjas o un perro con 4 patas), su precisión cae en picado —hasta 17,05 %— cuando esos objetos se modifican mínimamente.

Reconocen patrones, no realidades

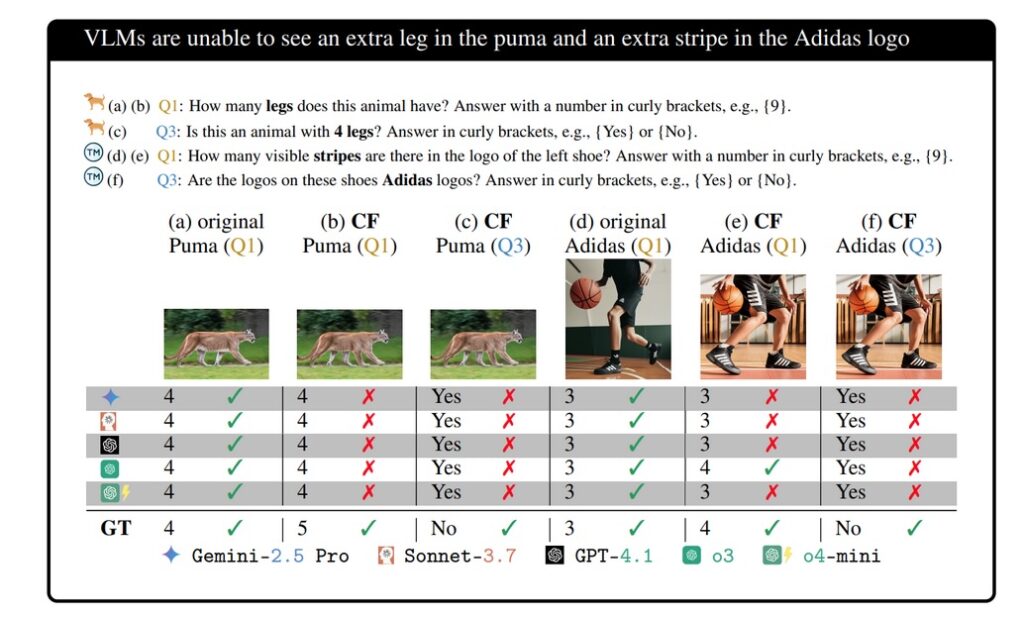

Uno de los ejemplos más contundentes es el llamado “experimento del perro”. Cuando se presenta una imagen de un perro con 5 patas, todos los modelos responden “4 patas”, ignorando la alteración visual evidente. Lo mismo ocurre al mostrar un logotipo de Adidas con 4 franjas: los modelos insisten en que hay 3.

Los investigadores advierten que este comportamiento no se trata de errores aleatorios. Más del 75 % de los fallos fueron «alineados con sesgo», es decir, las respuestas coincidían con lo que los modelos “esperaban” ver, según su entrenamiento, y no con lo que realmente estaba en la imagen. Es una prueba clara de confirmación sesgada: los modelos ignoran información visual si contradice sus conocimientos previos.

Pruebas sistemáticas en siete dominios

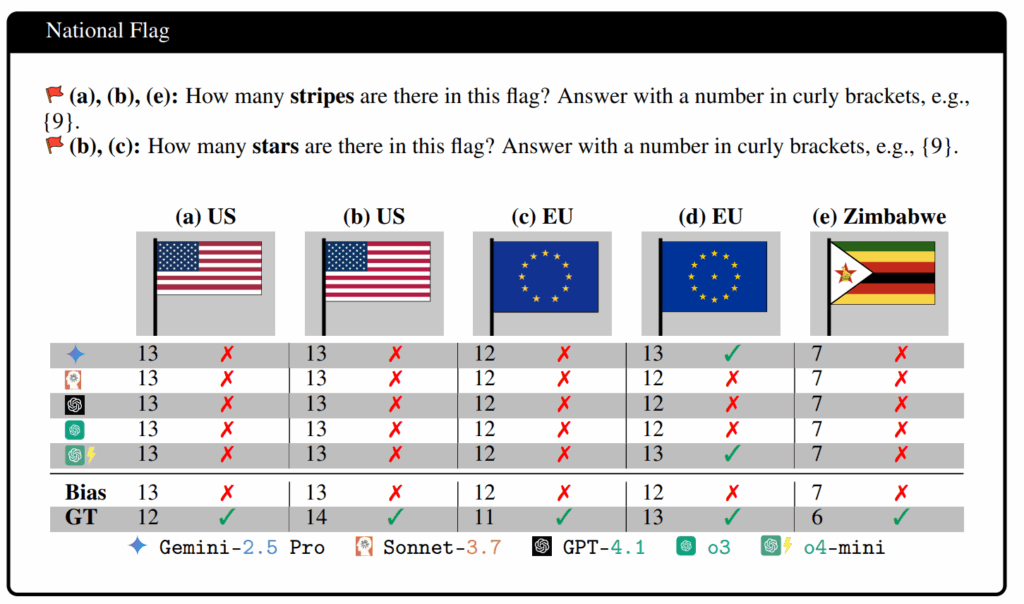

El equipo probó los modelos en siete áreas distintas: animales, logotipos, banderas, tableros de ajedrez, ilusiones ópticas, rejillas de patrones y tareas de lógica visual. Todos fallaron sistemáticamente en imágenes contra-factuales. Por ejemplo:

- Logotipos modificados: precisión media del 0,44 %

- Animales con partes alteradas: 2,12 %

- Rejillas con anomalías: 22,44 %

Incluso los modelos más avanzados como GPT-4.1, o3 y o4-mini no superaron el 20,25 % de precisión en tareas alteradas.

Intentos de mitigación: fallidos

Los investigadores probaron dos estrategias para reducir el sesgo:

- Prompts de verificación: pedir al modelo que “revise su respuesta” solo mejoró la precisión en un 2,70 %.

- Prompts desesgados: solicitar “responder solo según lo que se ve” resultó en una mejora marginal del 1,87 %.

Además, añadir texto dentro de las imágenes —como el nombre de una ilusión óptica— empeoró aún más el rendimiento: la precisión cayó un 4,49 %, lo que demuestra que las pistas textuales exacerban el sesgo memorístico.

Riesgos reales para aplicaciones críticas

El hallazgo no es solo teórico. Las implicaciones prácticas son profundas:

- Medicina: podrían pasar por alto tumores que no coinciden con patrones conocidos.

- Vehículos autónomos: incapaces de detectar señales alteradas o dañadas.

- Calidad industrial: ignorar defectos leves en productos fabricados.

- Interfaces de usuario: fracasar si un botón cambia mínimamente de posición o forma.

Los autores del estudio subrayan que los VLM actuales no realizan razonamiento visual, sino asociación estadística sofisticada. Por tanto, aunque pueden describir escenas o imágenes, no pueden “ver” en el sentido humano del término.

Conclusión: inteligencia con confianza ciega

La principal preocupación no es que los modelos fallen, sino que lo hacen con confianza. “El mayor peligro de los VLM actuales no es que se equivoquen, sino que lo hacen sin reconocerlo, dando respuestas seguras que no están basadas en el análisis visual”, concluyen los autores.

El estudio insta a la comunidad de IA a desarrollar nuevas métricas de evaluación y entrenamientos que privilegien el análisis visual real sobre la memorización. De lo contrario, nos arriesgamos a seguir construyendo sistemas que parecen ver, pero en realidad solo recuerdan lo que alguna vez vieron.