Un nuevo enfoque en inteligencia artificial está emergiendo y promete transformar la manera en que los modelos de lenguaje identifican la verdad y optimizan la consistencia de sus respuestas. Este innovador método, conocido como «debate de modelos de lenguaje grandes» (LLM Debates), ha sido desarrollado por un grupo de científicos para evaluar y mejorar la precisión factual de los sistemas de inteligencia artificial mediante la confrontación de modelos en la defensa de perspectivas opuestas.

La metodología contempla tres rondas de argumentos entre dos modelos LLM, donde se busca evaluar cuál de las posturas es la más convincente. Este enfoque se vuelve especialmente relevante en contextos donde la anotación manual de datos -para establecer verdades objetivas- resulta ser un proceso costoso, lento y a menudo controvertido. Los debates LLM, a través de la creación de datos sintéticos, permiten no solo acelerar la alineación de verdades en conjuntos de datos no supervisados, sino que también aportan significativamente al perfeccionamiento de modelos de lenguaje más robustos.

El concepto detrás de esta técnica fue presentado en la Conferencia Internacional sobre Aprendizaje Automático (ICML) 2024, inspirándose en el uso del dataset «TofuEval». Durante los debates, modelos como Claude 3 Sonnet de Anthropic y Mixtral 8X7B defienden lados opuestos de un argumento, mientras que el modelo Mistral 7B actúa como juez para designar el argumento más persuasivo.

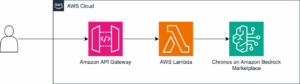

Estas sesiones de debate se llevan a cabo en el entorno Azure mediante el uso de Amazon Sagemaker y Bedrock, soluciones que proporcionan la infraestructura necesaria para gestionar la complejidad de estos procesos. Amazon Bedrock, en particular, es destacada por facilitar la experimentación y despliegue de capacidades de inteligencia artificial generativa.

El desafío central en estos debates es evaluar el resumen más coherente de dos propuestas basadas en un conjunto de transcripciones, lidiando con errores tales como cambios sutiles de significado y errores de razonamiento. Cuatro enfoques han sido comparados: Juez Ingenuo, Juez Experto, Consultoría LLM, y Debates LLM. El método de debate LLM se destacó, alcanzando una precisión del 70% en experimentos, en contraste con el método de juez ingenuo, que solo alcanzó un 10% de precisión.

Los avances logrados con los LLM Debates no solo muestran mejoras significativas en la precisión factual, sino que también ofrecen una vía para reducir costes y tiempos asociados a la anotación manual de datos. Este enfoque podría establecer un nuevo estándar en la generación de datos precisos y confiables, permitiendo el desarrollo de modelos de lenguaje avanzados y mejorando las aplicaciones de inteligencia artificial conversacional y orientada a tareas.