Microsoft ha liberado bitnet.cpp, un framework oficial de inferencia para modelos de lenguaje “1-bit” (en la práctica, BitNet b1.58, con pesos ternarios). La promesa es tentadora: hacer viable la inferencia de modelos enormes sin GPU, reduciendo drásticamente el coste energético y mejorando el rendimiento en CPUs modernas.

Pero, como suele ocurrir en el mundo de la IA, el titular rápido (“cambia el juego”) convive con una realidad más matizada: no es un “acelerador mágico” para cualquier LLM, sino una pieza diseñada para una familia de modelos específica, con sus requisitos y limitaciones. Aun así, la jugada es relevante, porque apunta a un objetivo que obsesiona a toda la industria: bajar el coste por token y empujar la IA fuera del centro de datos, hacia equipos locales y edge.

Qué es bitnet.cpp y por qué importa

bitnet.cpp es un motor de inferencia centrado en BitNet b1.58, una línea de modelos que utiliza representaciones de pesos de muy baja precisión. En lugar de trabajar con pesos de 16 bits (fp16) o 8 bits, BitNet b1.58 se apoya en una representación ternaria (valores tipo -1, 0, 1) y técnicas asociadas para comprimir, mover y multiplicar matrices con menos coste.

Traducido a negocio y operativa: si consigues que el modelo “pese” menos y que el cálculo sea más eficiente, puedes ejecutar modelos más grandes con menos hardware, o ejecutar los mismos modelos con menos consumo y más velocidad. Ese es el corazón del mensaje.

Los números que han puesto a circular (y cómo leerlos)

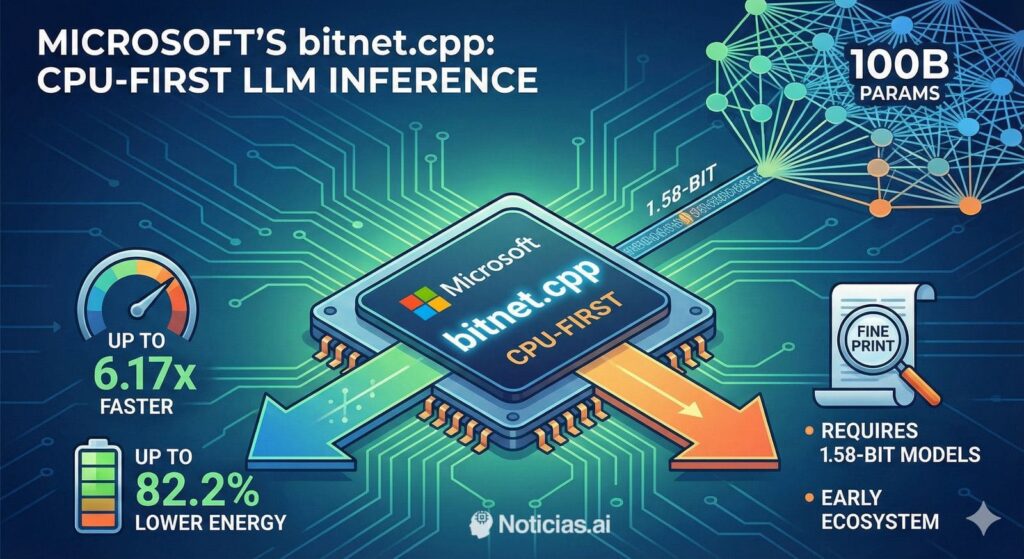

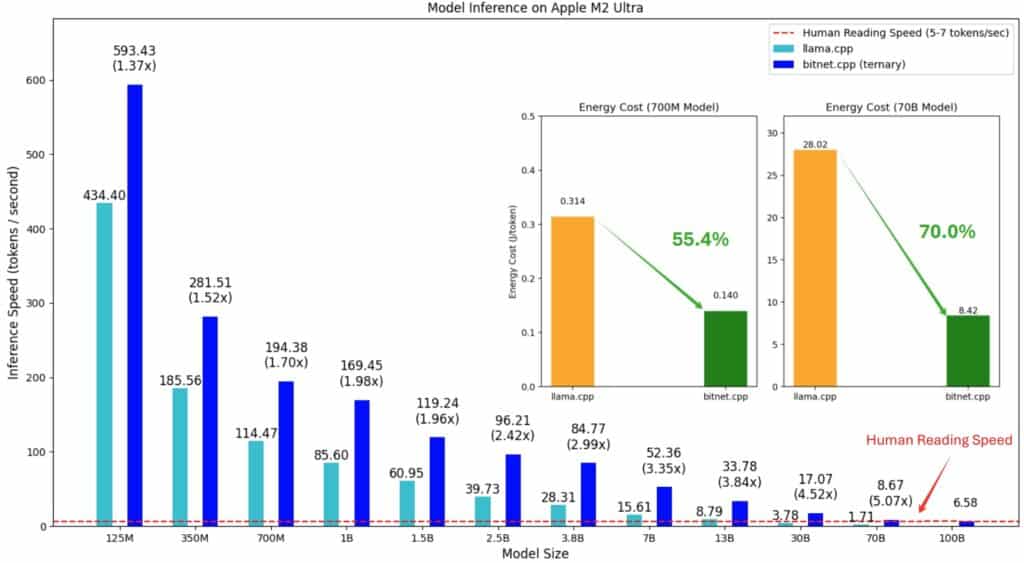

En la documentación técnica y el informe asociado, Microsoft Research reporta mejoras de velocidad y energía frente a enfoques más generalistas (comparando contra ejecuciones tipo llama.cpp en fp16 para ciertos escenarios):

- En x86, se describen aceleraciones de 2,37× a 6,17×, con reducciones de energía entre 71,9 % y 82,2 %.

- En ARM, aceleraciones de 1,37× a 5,07×, con recortes de energía del 55,4 % al 70,0 %.

- Y un claim especialmente llamativo: un modelo de 100B (100.000 millones de parámetros) podría correr en un solo CPU a 5–7 tokens por segundo, “velocidad de lectura humana”, en el contexto de sus pruebas.

Estas cifras ayudan a entender el objetivo: si el cuello de botella es memoria/ancho de banda y movimiento de datos, bajar la precisión puede ser un atajo potente. Dicho eso, el propio material deja claro un matiz importante: parte de los “benchmarks” se apoyan en configuraciones de prueba/dummy utilizadas en un contexto de investigación para demostrar rendimiento, y no equivalen automáticamente a “cualquier modelo real de 100B listo para producción”.

No es “cualquier LLM”: el punto crítico de compatibilidad

El detalle que mucha gente pasa por alto es que bitnet.cpp no convierte, por arte de magia, Llama 3/4, Mistral o Qwen en modelos 1-bit. Está pensado para modelos entrenados con ese enfoque (BitNet b1.58 y compatibles), y el repositorio enumera una lista concreta de modelos soportados para demostrar capacidades.

En otras palabras: la disponibilidad de modelos (y su calidad) es casi tan importante como el motor. Hoy, el ecosistema open source “mainstream” sigue pivotando mucho alrededor de cuantizaciones prácticas (4-bit, 5-bit, 8-bit) de modelos populares, porque hay una oferta masiva y flujos maduros para servirlos localmente.

Por qué Microsoft lo publica como open source

Que el proyecto sea MIT y se publique con guías de instalación y scripts tiene una lectura clara: Microsoft quiere que el ecosistema lo toque, lo critique y lo mejore, pero también quiere empujar un mensaje estratégico: la inferencia no puede depender siempre de GPU si la IA quiere escalar de verdad hacia dispositivos y empresas que no pueden (o no quieren) pagar esa factura.

Además, bitnet.cpp reconoce su herencia: se apoya en el ecosistema de llama.cpp y menciona técnicas de kernels y LUT asociadas a trabajos previos. Esto no resta mérito; al contrario, lo coloca donde toca: en la capa de ingeniería que convierte ideas de papers en software usable.

La respuesta de la comunidad: interés, pero también escepticismo

En comunidades de inferencia local se ha señalado que presentar esto como “acaba de ocurrir” puede ser engañoso si se interpreta como una novedad inmediata: el propio historial público del proyecto y su cronología muestran que el trabajo lleva tiempo y que ha ido evolucionando.

También aparece otra crítica habitual: lo “1-bit” es prometedor, pero aún más académico que cotidiano para la mayoría de usuarios, porque el mercado real se mueve por lo que se descarga y sirve con facilidad hoy. En ese terreno, métodos como las cuantizaciones en formato GGUF optimizadas para inferencia local (por ejemplo, aproximaciones populares en el ecosistema Unsloth) están ya muy presentes en los modelos más descargados y usados por la comunidad.

Entonces… ¿cambia el juego?

Depende de para quién.

- Para investigación e ingeniería de inferencia: sí, es una señal fuerte. Un motor optimizado para muy baja precisión, con números agresivos en CPU, empuja una dirección clara: eficiencia energética y coste por token.

- Para el usuario medio que hoy ejecuta modelos cuantizados en su PC: es “prometedor”, pero condicionado por algo básico: qué modelos 1,58-bit están realmente disponibles, son buenos y se adaptan a casos reales.

- Para empresas con requisitos de privacidad, on-premise, soberanía y control de coste: es interesante por el concepto. Si la industria consigue que el low-bit mantenga calidad suficiente, el CPU vuelve a ser candidato para cargas que antes exigían GPU.

Lo relevante, en el fondo, no es el repositorio en sí: es el mensaje que deja caer. La próxima gran batalla de la IA no es solo quién tiene el modelo más grande, sino quién lo ejecuta más barato y en más sitios.

Preguntas frecuentes

¿Qué significa “1,58 bits” y por qué se habla de pesos ternarios?

Se refiere a una aproximación de muy baja precisión en la que los pesos pueden representarse de forma compacta (en BitNet b1.58, con valores ternarios). El objetivo es reducir memoria y ancho de banda, manteniendo inferencia “sin pérdidas” dentro del marco del método.

¿Puedo usar bitnet.cpp con modelos populares como Llama o Mistral sin más?

No de forma directa. bitnet.cpp está orientado a modelos compatibles con el enfoque BitNet b1.58 (o equivalentes 1,58-bit). No es un “plugin” universal para cualquier checkpoint estándar.

¿Qué tipo de hardware necesito para probarlo en local?

Según los requisitos publicados, se apoya en un entorno con Python, CMake y Clang (y en Windows, Visual Studio), además de disponer del modelo compatible en formato adecuado para inferencia. La experiencia práctica dependerá de CPU, memoria y del modelo elegido.

¿Cómo se compara con cuantizaciones GGUF muy usadas en local?

Las cuantizaciones GGUF (4-bit/5-bit/8-bit y variantes) tienen una ventaja operativa enorme: hay muchísima oferta de modelos y pipelines maduros. bitnet.cpp apunta a otra liga: exprimir un tipo de modelo específico de ultra baja precisión para maximizar eficiencia en CPU.