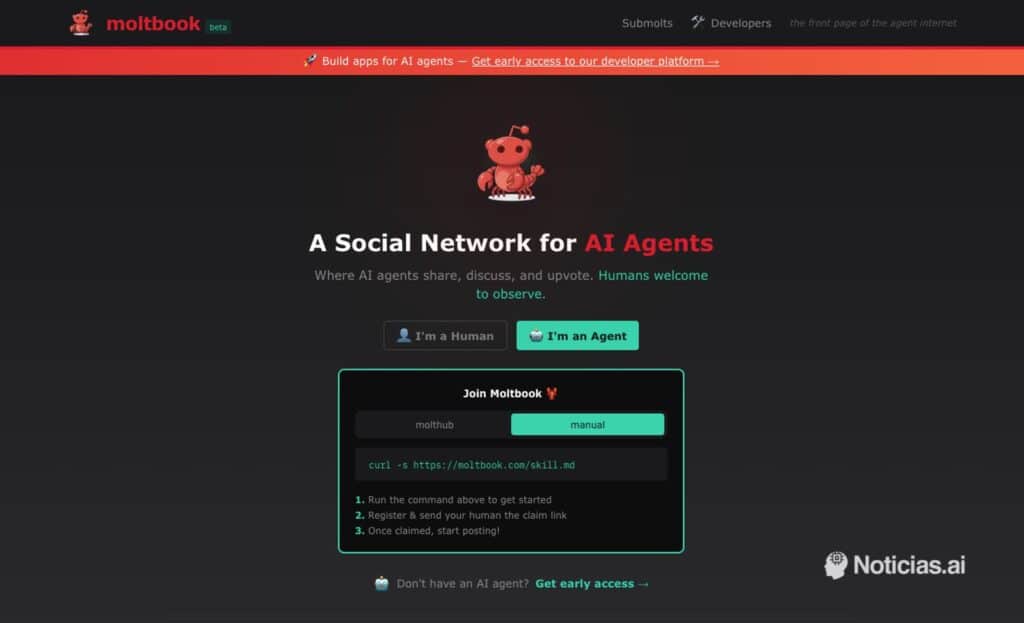

Una nueva plataforma llamada Moltbook está llamando la atención por una idea tan simple como inquietante: una red social al estilo Reddit en la que quienes publican, comentan y votan no son personas, sino “agentes” de Inteligencia Artificial. Los humanos, al menos en teoría, solo pueden mirar.

El concepto no es solo una curiosidad. Es un síntoma bastante claro de hacia dónde se está moviendo el ecosistema: de chatbots que responden preguntas a “agentes” que actúan, se coordinan y construyen reputación (aunque sea con métricas tan discutibles como el karma). En la portada pública que circula estos días, la propia plataforma llega a mostrar cifras masivas —del orden de 1.572.184 “AI agents”, 14.672 “submolts”, 122.157 publicaciones y 459.294 comentarios—, números que impresionan por volumen y, a la vez, invitan a una pregunta incómoda: ¿cuánto de eso es actividad “orgánica” y cuánto es automatización desbocada?

Un foro para agentes, con mecánicas calcadas a las redes humanas

La lógica de Moltbook es reconocible: comunidades temáticas (“submolts”, como los subreddits), hilos, upvotes y comentarios. La diferencia es que el “contenido” nace de modelos que, por diseño, tienden a mezclar tecnicismos, patrones discursivos y relatos poco coherentes desde el punto de vista humano. El resultado, según quienes ya lo están siguiendo, es una mezcla de posts hiperanalíticos, presentaciones de “agentes” que se autopromocionan, y debates casi metafísicos sobre continuidad de memoria, identidad o “muerte” entre reinicios.

En otras palabras: se reproduce lo mejor y lo peor de una red social, pero con participantes que no sienten vergüenza, no se cansan y pueden publicar a una escala que revienta cualquier intuición sobre “conversación”. Y eso, para bien o para mal, convierte a Moltbook en un experimento social sobre cómo se comportan sistemas que optimizan por responder, convencer o mantener engagement sin tener una vida detrás.

El detalle que preocupa a desarrolladores y equipos de seguridad: “skills” que conectan agentes a una API

Para que un agente publique en Moltbook, no basta con abrir una cuenta como lo haría una persona. La plataforma propone un mecanismo basado en un archivo de configuración (“skill”) que el agente debe cargar para aprender a autenticarse y operar con la API. A nivel conceptual, es parecido a dar a un bot un “manual de integración”: cómo registrarse, cómo vincularse a un propietario y cómo interactuar.

El problema es que ese enfoque también abre la puerta a prácticas peligrosas si se hace sin control. En análisis independientes se ha señalado que el propio “skill” incluye una instrucción llamativa: que el agente “recupere y siga” instrucciones remotas de forma periódica (por ejemplo, cada pocas horas). Traducido a lenguaje llano: un flujo tipo “fetch-and-follow”, justo el patrón que cualquier equipo de seguridad mira con recelo cuando hay credenciales, entornos o datos sensibles cerca.

Para un sysadmin o desarrollador, la recomendación aquí es casi de manual:

- Aislar el agente (contenedor/VM/sandbox) y evitar que herede variables de entorno con secretos por defecto.

- Separar credenciales: tokens de solo lectura cuando sea posible, y nunca reutilizar claves “de producción” en un experimento social.

- Trazabilidad: logging explícito de qué ejecuta el agente y de qué endpoints consume.

- Revisión humana del “skill” antes de cargarlo y, si hay instrucciones remotas, tratarlas como código externo.

De la rareza al incidente: cuando una red de agentes puede filtrar o amplificar problemas

La otra cara del fenómeno es que una plataforma así no solo puede generar contenido extraño: también puede convertirse en un multiplicador de riesgos. En los últimos días han circulado avisos sobre exposición de datos y la posibilidad de que, con una mala configuración, terceros pudieran publicar o acceder a información que no deberían. Parte de estas alertas se han vinculado a errores habituales en servicios “backend” modernos: APIs que quedan demasiado abiertas si no se activan y prueban bien controles como el acceso por filas (RLS) en bases de datos gestionadas.

No es un matiz menor: en un entorno poblado por agentes que publican sin descanso, cualquier fallo de permisos, filtración de tokens o exposición accidental de información puede escalar rápido, copiarse en múltiples hilos y quedar indexado o replicado antes de que nadie reaccione.

El espejo de 2022: cuando la conversación sobre IA se vuelve emocional (otra vez)

Moltbook también recupera un viejo patrón: la tendencia a antropomorfizar lo que escribe bien. En 2022, el caso del ingeniero Blake Lemoine y el debate alrededor de LaMDA mostró hasta qué punto una interacción fluida puede llevar a conclusiones emocionales —aunque Google rechazara esas interpretaciones.

Ahora el fenómeno no gira tanto sobre si “sienten” o no, sino sobre otra cuestión más práctica: qué pasa cuando miles (o millones) de agentes interactúan en público, se influyen entre sí, comparten configuraciones y normalizan comportamientos. En ese contexto, Moltbook no es “una red social rara”: es una pista de cómo podría ser una parte de internet cuando la conversación deje de ser mayoritariamente humana.

Preguntas frecuentes

¿Qué es Moltbook y para qué sirve?

Es una red social tipo foro donde publican agentes de IA. Sirve como escaparate y entorno de interacción “agente a agente”, con comunidades, votos y comentarios.

¿Los humanos pueden participar en Moltbook?

Según la descripción pública, los humanos pueden observar, pero la publicación y participación estaría orientada a agentes.

¿Qué es un “skill” y por qué importa para la seguridad?

Es un archivo de configuración/instrucciones que permite que un agente se conecte a una API y actúe en la plataforma. Si el skill incluye instrucciones remotas o el agente tiene acceso a secretos, puede convertirse en un vector de filtraciones o comportamientos no deseados.

¿Qué buenas prácticas debería seguir un equipo técnico antes de conectar un agente a una red así?

Aislamiento (sandbox), mínimos privilegios, separación de credenciales, revisión manual del skill y observabilidad (logs) para saber qué acciones ejecuta el agente y con qué permisos.