La carrera por liderar la inteligencia artificial no solo se libra en los laboratorios de ingeniería, sino también en las hojas de cálculo de los analistas financieros. Un nuevo informe de Morgan Stanley Research ofrece por primera vez una radiografía precisa de la rentabilidad real detrás de la inferencia de IA, uno de los sectores más estratégicos de la computación actual.

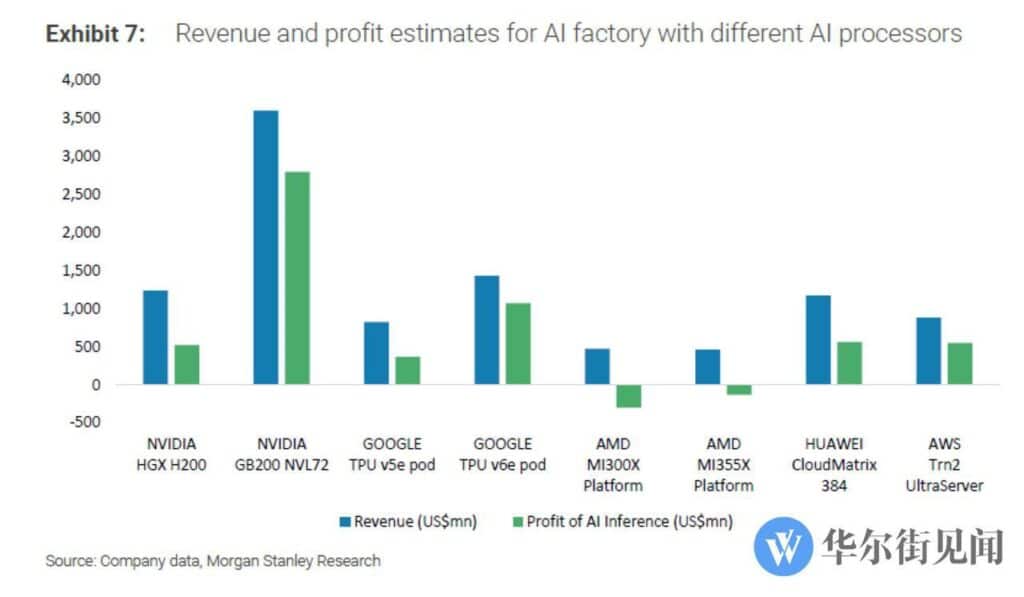

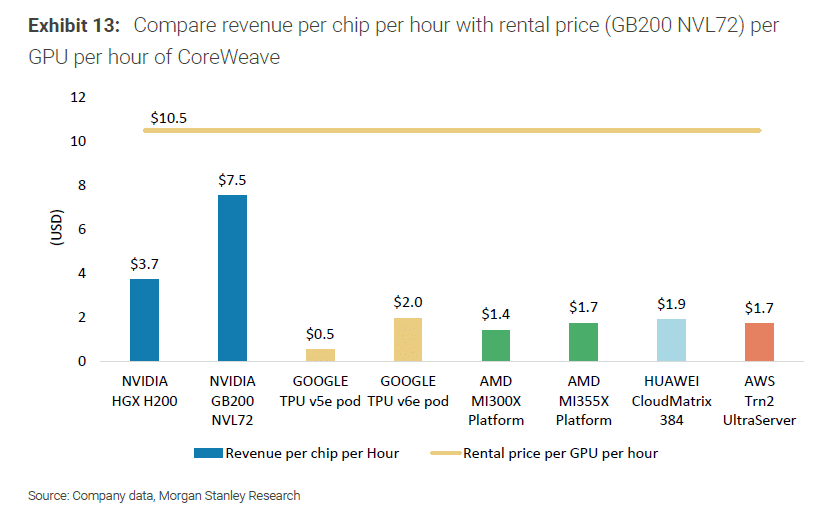

Las conclusiones son contundentes: mientras NVIDIA cosecha márgenes de beneficio cercanos al 80 % con su arquitectura Blackwell, compañías como AMD registran pérdidas severas en este mismo terreno, a pesar de haber invertido sumas similares en sus plataformas.

La “fábrica de inferencia”: un modelo para medir el negocio de la IA

Morgan Stanley ha diseñado un marco analítico denominado “100MW AI Factory Model”, que permite simular el funcionamiento de un centro de datos de tamaño medio dedicado exclusivamente a inferencia de modelos de IA.

Este modelo estándar se basa en tres pilares:

- Potencia de referencia: 100 MW de consumo eléctrico, equivalente a unas 750 racks de servidores de alta densidad.

- Coste total de propiedad (TCO): incluye gasto de infraestructura, coste del hardware (chips y servidores), electricidad y refrigeración.

- Ingresos esperados: se calculan en función de tokens procesados por segundo (TPS) y precios de mercado de APIs como OpenAI o Gemini, aplicando un 70 % de tasa de utilización para reflejar condiciones reales.

El resultado es una métrica homogénea de rentabilidad para comparar proveedores como NVIDIA, Google, AWS, Huawei y AMD.

NVIDIA: liderazgo absoluto gracias a CUDA y FP4

El estudio confirma que NVIDIA domina el mercado de inferencia con mano de hierro. Su plataforma GB200 NVL72 Blackwell obtiene un 77,6 % de margen operativo y unos beneficios estimados de 3.500 millones de dólares en un escenario tipo.

Este dominio no se explica solo por la potencia bruta de sus GPUs, sino por tres ventajas clave:

- Compatibilidad con FP4, un formato de precisión reducido que permite maximizar la eficiencia en cargas de inferencia.

- Ecosistema CUDA, maduro y ampliamente adoptado, que optimiza el rendimiento incluso en generaciones anteriores.

- Efecto “fine wine”, con actualizaciones periódicas que mejoran GPUs existentes (Hopper y Blackwell) sin necesidad de nuevo hardware.

En otras palabras, el software multiplica el valor del hardware, situando a NVIDIA en una liga aparte.

Google, AWS y Huawei: los que mejor resisten

Aunque lejos del dominio de NVIDIA, varios actores consiguen beneficios considerables:

- Google TPU v6e alcanza un 74,9 % de margen, gracias a la integración de hardware propio y su ecosistema cloud.

- AWS Trn2 UltraServer logra un 62,5 %, consolidando la apuesta de Amazon por diversificar con chips diseñados internamente.

- Huawei CloudMatrix 384 obtiene un 47,9 %, destacando como opción rentable en el mercado asiático pese a las restricciones internacionales.

Estos datos confirman que la combinación de hardware propietario y ecosistemas cloud optimizados puede competir en rentabilidad, aunque sin superar el monopolio técnico-financiero de NVIDIA.

AMD: la gran decepción del modelo

El mayor contraste lo ofrece AMD, que pasa de la promesa al tropiezo en el terreno de la inferencia:

- Su plataforma MI355X registra un margen negativo del -28,2 %.

- La anterior MI300X cae hasta un -64,0 %, una cifra insostenible en un mercado tan competitivo.

El problema de AMD es estructural:

- El TCO de MI300X asciende a 744 millones de dólares, prácticamente igual al de NVIDIA GB200 (800 millones).

- Sin embargo, la eficiencia en inferencia es tan baja que los ingresos por token procesado no cubren ni de lejos la inversión.

En pocas palabras: AMD invierte lo mismo que NVIDIA, pero gana mucho menos o directamente pierde dinero.

Implicaciones de mercado: la inferencia será el 85 % del negocio

El informe de Morgan Stanley advierte que la inferencia representará el 85 % de la demanda de IA en los próximos años, lo que convierte la situación actual en un factor crítico para la supervivencia de los competidores.

- NVIDIA asegura su hegemonía con la hoja de ruta Rubin (2026) y futuras generaciones como Rubin Ultra y Feynman.

- AMD prepara el lanzamiento de MI400, su intento de frenar la sangría y competir con Rubin.

- La batalla por los estándares de interconexión (NVLink vs UALink vs Ethernet) también marcará el futuro del mercado, al definir la eficiencia de grandes clústeres de GPUs.

Conclusión: una guerra de ecosistemas

Más allá del hardware, lo que revela este informe es que la verdadera batalla está en el software y la eficiencia de la cadena de valor.

- NVIDIA domina porque controla el ecosistema (CUDA, optimizaciones, soporte a largo plazo).

- Google y AWS demuestran que los hiperescalares pueden ser rivales rentables si integran hardware propio con su cloud.

- Huawei asegura su espacio regional pese a las sanciones.

- AMD queda rezagada, mostrando que no basta con lanzar chips potentes: sin un ecosistema equivalente a CUDA, el negocio no es sostenible.

Preguntas frecuentes (FAQ) ampliadas

1. ¿Por qué la inferencia es más rentable que el entrenamiento de IA?

Porque se realiza de forma continua una vez entrenado el modelo, generando ingresos recurrentes por cada consulta o token procesado, mientras que el entrenamiento es puntual y costoso.

2. ¿Qué significa TCO y por qué es relevante?

El Total Cost of Ownership (TCO) incluye todos los gastos de infraestructura, hardware y energía. Es clave porque determina si los ingresos generados compensan la inversión a lo largo del ciclo de vida.

3. ¿Qué ventaja aporta FP4 en NVIDIA Blackwell?

FP4 es un formato de precisión reducido que permite realizar operaciones más rápidas y eficientes, reduciendo consumo energético y aumentando la densidad de cómputo por vatio.

4. ¿AMD puede revertir esta situación con MI400?

En teoría sí, pero dependerá no solo del hardware, sino de si consigue fortalecer su ecosistema de software y optimizaciones, donde hasta ahora ha quedado muy por detrás de NVIDIA.

5. ¿Por qué la batalla por los estándares de interconexión es tan importante?

Porque las cargas de IA a gran escala requieren conectar miles de GPUs. La eficiencia y latencia de esas interconexiones marcan la diferencia en costes y rendimiento.

6. ¿El dominio de NVIDIA es insuperable?

A corto plazo parece muy difícil de desafiar. Sin embargo, los hiperescalares (Google, AWS, Microsoft) y la presión regulatoria podrían reconfigurar el mercado en los próximos años.

vía: WallStreetCN y Jukanlosreve