La nueva generación de modelos de inteligencia artificial ya tiene una arquitectura clara favorita: Mixture of Experts (MoE). Y NVIDIA acaba de mover ficha para convertirla en algo realmente utilizable a gran escala. Su sistema GB200 Blackwell NVL72, un “rack” completo de GPUs que funciona como si fuera una sola unidad lógica, promete hasta 10 veces más rendimiento para estos modelos frente a la generación anterior basada en Hopper H200, según las propias pruebas de la compañía.

El anuncio no es menor: los modelos abiertos más avanzados del momento —como DeepSeek-R1, Kimi K2 Thinking o Mistral Large 3— se apoyan precisamente en diseños Mixture of Experts y ya están siendo optimizados para correr sobre Blackwell NVL72.

Qué es Mixture of Experts y por qué todo el mundo habla de ello

Durante años, la receta para construir modelos más inteligentes era simple (y cara): hacerlos cada vez más grandes y densos, activando prácticamente todos sus parámetros en cada token generado. Eso implica cientos de miles de millones de parámetros trabajando a la vez, con un coste enorme en energía y cómputo.

Los modelos Mixture of Experts cambian las reglas del juego. En lugar de activar todo el modelo, dividen la red en “expertos” especializados (por ejemplo, unos mejor en razonamiento matemático, otros en programación, otros en comprensión de contexto largo) y un router decide qué expertos se activan en cada token.

En la práctica, el modelo puede tener cientos de miles de millones de parámetros, pero para cada paso solo utiliza una fracción —decenas de miles de millones—, lo que dispara la eficiencia: más inteligencia por vatio y por euro invertido.

El mercado abierto ya se ha dado cuenta. En el leaderboard independiente de Artificial Analysis, los 10 modelos open source más inteligentes utilizan arquitectura MoE, incluyendo DeepSeek-R1, Kimi K2 Thinking, gpt-oss-120B y Mistral Large 3.

El problema: escalar MoE en la práctica es muy difícil

Sobre el papel, MoE es ideal. En producción, sin el hardware adecuado, puede ser una pesadilla:

- Los parámetros de cada experto tienen que cargarse y descargarse constantemente desde la memoria de alta velocidad.

- Los expertos, repartidos entre múltiples GPUs, necesitan comunicarse en un patrón “todos con todos” extremadamente exigente en ancho de banda y latencia.

- En plataformas anteriores, como sistemas H200 de 8 GPUs, al crecer el número de expertos por modelo se acaba pasando a redes de interconexión más lentas (redes de escala horizontal), lo que introduce cuellos de botella de comunicación y limita la velocidad real.

Ahí es donde NVIDIA apuesta por el “códiseño extremo”: no solo más potencia bruta, sino una arquitectura completa —hardware y software— pensada específicamente para estos modelos.

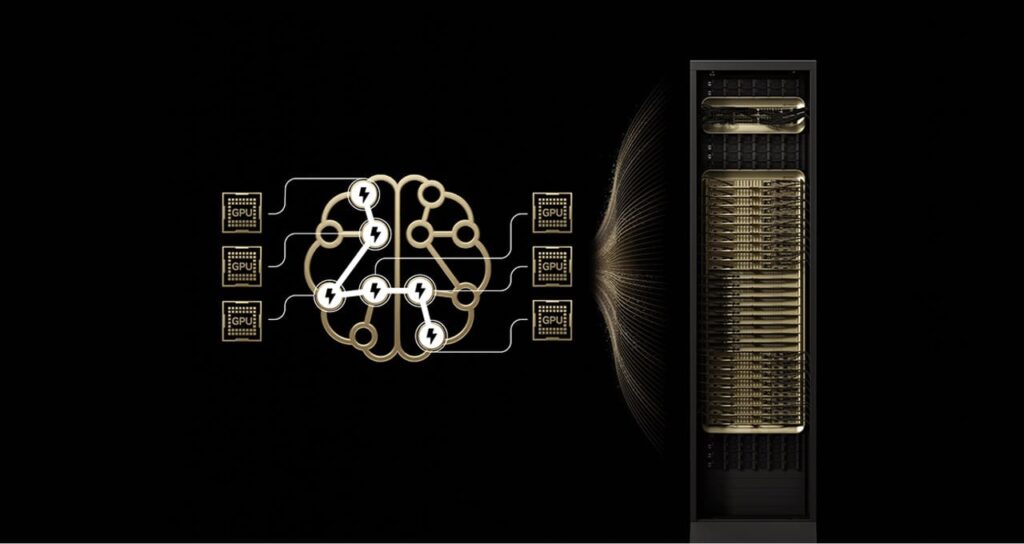

GB200 Blackwell NVL72: 72 GPUs que se comportan como una sola

El sistema GB200 NVL72 es, en esencia, un rack completo de 72 GPUs Blackwell interconectadas mediante NVLink Switch en un único dominio de alta velocidad, con unos 1,4 exaflops de potencia de IA y 30 TB de memoria compartida accesible a baja latencia. Todo ello unido por una malla NVLink capaz de ofrecer hasta 130 TB/s de comunicación interna.

Para los modelos Mixture of Experts esto tiene varias consecuencias directas:

- Los expertos pueden repartirse entre hasta 72 GPUs manteniéndose dentro del mismo tejido NVLink, sin saltar a redes más lentas.

- Disminuye el número de expertos que cada GPU tiene que albergar, reduciendo la presión sobre la memoria HBM y permitiendo manejar más usuarios concurrentes o prompts con contextos mucho más largos.

- El patrón “all-to-all” entre expertos se resuelve dentro de NVLink, con latencias mucho más bajas que en redes de escala horizontal.

El NVLink Switch, además, no se limita a “mover datos”: incorpora capacidades como SHARP (Scalable Hierarchical Aggregation and Reduction Protocol), que permite hacer parte de las operaciones de reducción dentro de la propia red, acelerando todavía más la combinación de resultados de distintos expertos.

De los benchmarks a la realidad: 10x más rendimiento para los grandes MoE

La combinación de Blackwell NVL72 y optimizaciones de software de la propia NVIDIA está empezando a verse en resultados concretos:

- El modelo Kimi K2 Thinking, de Moonshot AI, considerado actualmente el modelo open source más “inteligente” del ranking de Artificial Analysis, logra hasta 10 veces más rendimiento al pasar de una plataforma basada en H200 a un sistema GB200 NVL72, manteniendo calidad de respuesta.

- DeepSeek-R1 y sus variantes, basadas también en MoE, muestran incrementos similares en tokens generados por segundo y en rendimiento por vatio gracias al uso combinado de NVLink, formato numérico NVFP4 y el framework NVIDIA Dynamo para repartir de forma inteligente las fases de prefill y decode entre distintas GPUs.

- Mistral Large 3, el modelo estrella de la familia Mistral 3, con 41.000 millones de parámetros activos y 675.000 millones de parámetros totales, se ha entrenado y optimizado expresamente para sacar partido de GB200 NVL72, logrando también alrededor de 10x en inferencia frente a la base instalada anterior.

Estos saltos no se explican solo por tener “más FLOPS”. El software cuenta mucho: frameworks como TensorRT-LLM, SGLang y vLLM han sido adaptados para modelos MoE a esta escala, aprovechando técnicas como el disaggregated serving (separar GPUs para prefill y decode) y el nuevo formato NVFP4, que mantiene la precisión mientras reduce el coste computacional.

Quién está adoptando esta arquitectura y qué significa para los centros de datos

Los primeros en alinearse con esta visión son, como era de esperar, los grandes proveedores de nube y plataformas de IA:

- AWS, Google Cloud, Microsoft Azure, Oracle Cloud Infrastructure, CoreWeave, Lambda, Nscale y otros proveedores están anunciando despliegues o planes para ofrecer sistemas GB200 NVL72 como base de sus “fábricas de IA”.

- Empresas como DeepL o Together AI ya han comunicado que están utilizando o preparando el salto a Blackwell NVL72 para entrenar y servir sus próximos modelos de traducción y de inferencia basados en MoE.

Para los operadores de centros de datos y para los clientes finales, el mensaje es doble:

- Economía del token: NVIDIA estima, en otros análisis recientes, que una inversión de unos 5 millones de dólares en un sistema GB200 NVL72 puede llegar a generar hasta 75 millones en ingresos por tokens, es decir, un retorno del orden de 15x solo en inferencia si se mantiene una alta ocupación.

- Eficiencia energética: si de verdad se consolida ese salto de 10x en rendimiento por vatio para modelos complejos, la presión sobre el consumo energético de la IA podría reducirse en términos relativos, incluso mientras aumentan los volúmenes de cómputo.

Más allá de MoE: agentes, multimodalidad y “expertos compartidos”

Aunque el foco del anuncio está en Mixture of Experts, NVIDIA apunta a un patrón más amplio: muchos de los sistemas de IA que vienen siguen la misma lógica de “encaminar trabajo hacia expertos”:

- Los modelos multimodales separan módulos especializados en texto, visión, audio o vídeo, activando solo lo necesario en cada petición.

- Los sistemas de IA agentica coordinan varios agentes especializados —en planificación, razonamiento, búsqueda o uso de herramientas—, orquestados por un controlador central.

En ambos casos, la idea se parece a MoE: no ejecutar todo, todo el tiempo, sino elegir bien qué expertos usar en cada paso. Si se consigue que esos expertos sean reutilizables entre múltiples aplicaciones y agentes sobre una misma infraestructura NVL72, el ahorro en costes y energía puede ser aún mayor.

Conclusión: hacia una IA de frontera más eficiente (y más cara de ignorar)

La combinación de arquitecturas Mixture of Experts y hardware específico como GB200 Blackwell NVL72 marca un cambio importante en cómo se conciben los grandes modelos abiertos y comerciales. No se trata solo de subir parámetros, sino de hacerlo de una forma que sea desplegable a escala, rentable y compatible con las restricciones energéticas de los centros de datos.

Para las empresas que están diseñando su estrategia de IA —desde las grandes plataformas de nube hasta proveedores de cloud privado y organizaciones que entrenan modelos propios—, el mensaje es claro: los modelos MoE han dejado de ser un experimento académico para convertirse en el nuevo “estándar de facto” de la IA de frontera. Y NVIDIA quiere que ese estándar corra, si es posible, dentro de un rack NVL72.

Preguntas frecuentes sobre Mixture of Experts y NVIDIA Blackwell NVL72

¿Qué es exactamente un modelo Mixture of Experts (MoE) y en qué se diferencia de un modelo denso tradicional?

Un modelo Mixture of Experts divide la red neuronal en varios “expertos” especializados, y utiliza un router que decide qué expertos se activan para cada token o fragmento de entrada. En lugar de usar todos los parámetros en cada paso, solo se activa una fracción del modelo, lo que mejora la eficiencia computacional y energética. En un modelo denso clásico, en cambio, todas las capas principales participan siempre, independientemente del tipo de tarea.

¿Por qué NVIDIA GB200 NVL72 es especialmente adecuado para modelos MoE?

Porque agrupa hasta 72 GPUs Blackwell en un solo dominio de alta velocidad NVLink, con 30 TB de memoria compartida y 130 TB/s de ancho de banda interno. Esto permite repartir los expertos del modelo entre muchas GPUs manteniendo una comunicación rápida y de baja latencia, algo crítico para los patrones de “todos con todos” que requieren los MoE. El resultado práctico es que se puede escalar a modelos con cientos de miles de millones de parámetros totales sin que la red de interconexión se convierta en el cuello de botella.

¿Qué modelos conocidos ya usan Mixture of Experts y están optimizados para Blackwell NVL72?

Entre los modelos abiertos destacan DeepSeek-R1, Kimi K2 Thinking y Mistral Large 3, todos ellos basados en arquitecturas MoE y situados en los primeros puestos de los rankings de modelos de código abierto. NVIDIA y sus socios están anunciando mejoras de rendimiento de hasta 10x al desplegarlos sobre GB200 NVL72 en lugar de plataformas anteriores como H200.

¿Qué impacto real puede tener todo esto en el coste por token y el consumo energético de la IA?

Si los sistemas NVL72 logran mantener en producción los saltos de hasta 10x en rendimiento por vatio anunciados para modelos complejos, cada token generado requerirá menos energía y menos tiempo de GPU, reduciendo el coste unitario. Para los operadores de centros de datos, esto significa poder servir más peticiones y modelos más grandes con el mismo presupuesto energético y de infraestructura, mejorando el retorno de la inversión en hardware de IA.

vía: blogs.nvidia