NVIDIA ha presentado Nemotron-Research-Reasoning-Qwen-1.5B, un modelo de lenguaje abierto de 1.500 millones de parámetros diseñado específicamente para tareas complejas de razonamiento, superando con claridad a competidores de su misma escala e incluso acercándose al rendimiento de modelos de mayor tamaño como DeepSeek-R1-7B.

Este nuevo modelo ha sido entrenado utilizando el algoritmo ProRL (Prolonged Reinforcement Learning), que permite extensas fases de entrenamiento en entornos de razonamiento, incluyendo matemáticas avanzadas, programación, lógica, resolución de problemas científicos y comprensión de instrucciones.

ProRL: entrenamiento reforzado más allá del límite

ProRL se basa en Group Relative Policy Optimization (GRPO) e introduce varias innovaciones técnicas que permiten extender el entrenamiento más allá de 2.000 pasos, algo clave para el aprendizaje en contextos complejos. Entre sus técnicas destacadas se encuentran:

- Prevención del colapso de entropía.

- Optimización de políticas con muestreo dinámico desacoplado.

- Regularización KL y reinicio de políticas de referencia.

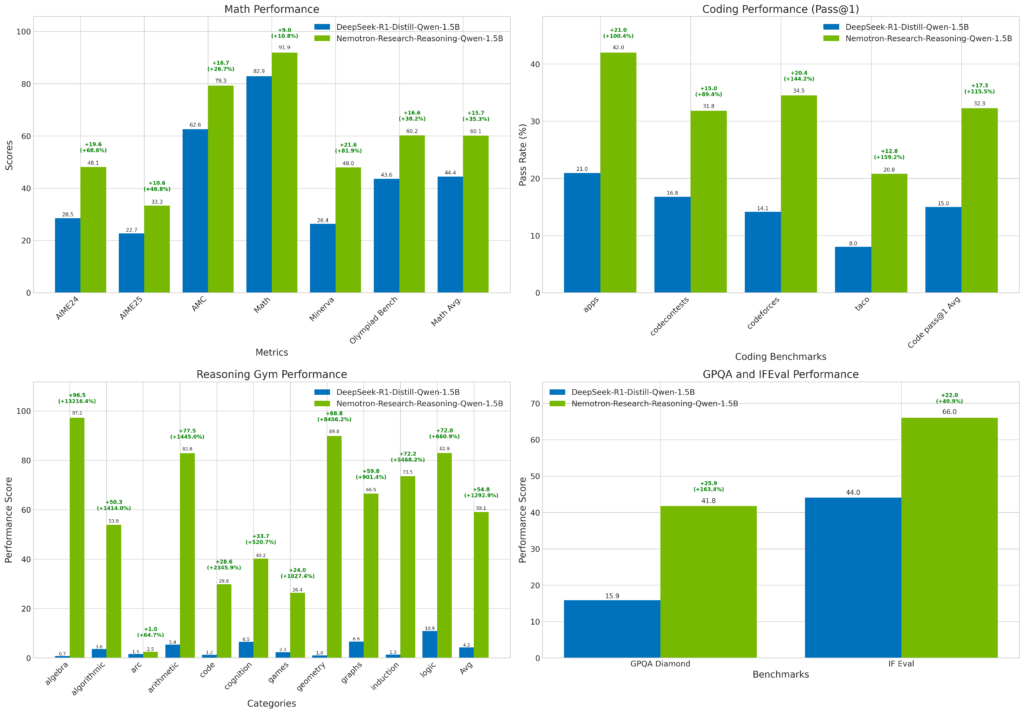

Gracias a esta metodología, Nemotron Qwen-1.5B ha conseguido mejoras notables en comparación con su punto de partida, el modelo DeepSeek-R1-1.5B, incluyendo:

- +14,7 % en tareas matemáticas.

- +13,9 % en codificación.

- +54,8 % en puzzles lógicos.

- +25,1 % en razonamiento STEM.

- +18,1 % en tareas de seguimiento de instrucciones.

Resultados comparativos: un rendimiento sorprendente

Los resultados de evaluación en benchmarks estandarizados posicionan a Nemotron-Research-Reasoning-Qwen-1.5B como líder indiscutible entre los modelos de su clase:

Matemáticas (AIME, AMC, Minerva, Olimpiadas):

El modelo obtiene una media de 60,14 %, muy por encima del DeepSeek-R1-1.5B (44,45 %) y apenas a tres puntos del modelo DeepSeek-R1-7B (63,19 %).

Codificación (Apps, Codeforces, HumanEval+):

Alcanza un promedio de 37,49 %, superando ampliamente a modelos de 1.5B y acercándose a las cifras de modelos 7B.

Razonamiento lógico y STEM:

En GPQA (STEM), IFEval (instrucciones) y Reasoning Gym (lógica), Nemotron logra cifras de referencia: 41,78 %, 66,02 % y 59,06 % respectivamente, frente a los modestos valores del DeepSeek-R1-1.5B.

Además, muestra gran generalización en tareas fuera de distribución como Game of Life Halting, BoxNet y Acre, con márgenes muy superiores a sus competidores.

Usos, disponibilidad y licencia

Nemotron-Research-Reasoning-Qwen-1.5B está disponible públicamente en Hugging Face bajo licencia cc-by-nc-4.0, por lo que su uso está restringido a fines de investigación y no comerciales. NVIDIA señala que el modelo ha sido desarrollado bajo políticas de IA responsable y que su adopción debe evaluarse caso por caso según el contexto y las exigencias regulatorias del usuario final.

La documentación, datasets empleados (como DeepScaleR, Reasoning-Gym o SCP-116K), y resultados completos están disponibles en línea. La empresa invita a la comunidad a revisar el paper asociado:

“ProRL: Prolonged Reinforcement Learning Expands Reasoning Boundaries in Large Language Models” (arXiv:2505.24864).

Implicaciones para el ecosistema IA

Con el lanzamiento de Nemotron Qwen-1.5B, NVIDIA da un nuevo paso en su estrategia de democratizar modelos potentes para tareas cognitivas complejas. El hecho de que un modelo de “solo” 1.5B parámetros logre rendimientos que compiten con modelos de cinco veces su tamaño sugiere una mayor eficiencia y accesibilidad para investigadores, startups y organizaciones con recursos computacionales limitados.

Este modelo marca un hito en el desarrollo de modelos razonadores compactos, y consolida a NVIDIA como uno de los actores clave no solo en la infraestructura de IA, sino también en la creación de modelos con arquitectura propia.

Más información en Hugging Face.