NVIDIA y OpenAI han dado un paso decisivo en la carrera por la supremacía en inteligencia artificial con el lanzamiento de los modelos gpt-oss-20b y gpt-oss-120b, ambos con pesos abiertos, optimizados para la arquitectura Blackwell y diseñados para inferencia a gran escala. El anuncio no solo representa un salto tecnológico, sino que también reconfigura el mapa competitivo del mercado de IA, apuntalando la posición de NVIDIA como proveedor dominante de hardware y software para modelos de última generación.

En pruebas iniciales, el gpt-oss-120b ha alcanzado 1,5 millones de tokens por segundo (TPS) en un sistema NVIDIA GB200 NVL72, lo que equivaldría a dar servicio a unos 50.000 usuarios concurrentes. Este rendimiento marca un nuevo estándar para la inferencia en entornos de producción, con implicaciones directas en coste por token, escalabilidad y monetización de servicios de IA.

Un salto técnico con base en Blackwell

Ambos modelos —20B y 120B parámetros totales— utilizan una arquitectura Mixture of Experts (MoE) con activaciones SwigGLU y capas de atención con RoPE (Rotary Positional Embeddings) para manejar contextos de hasta 128.000 tokens. Alternan entre atención completa y ventanas deslizantes de 128 tokens para optimizar memoria y latencia.

La precisión FP4 es clave: permite que el modelo de 120B parámetros activos encaje en una sola GPU de 80 GB, reduciendo consumo energético y costes operativos sin sacrificar exactitud. Esto es particularmente relevante en un momento en el que el coste energético de la IA empieza a ser objeto de escrutinio regulatorio en EE. UU. y la UE.

Un entrenamiento de escala masiva

El entrenamiento del gpt-oss-120b ha requerido más de 2,1 millones de horas GPU en NVIDIA H100 Tensor Core, mientras que el 20B ha necesitado unas diez veces menos. La inversión en horas de cómputo es un indicador de la barrera de entrada para cualquier competidor que intente replicar el modelo sin acceso a infraestructura de alta gama y acuerdos estratégicos con fabricantes de chips.

En este sentido, NVIDIA ha colaborado con Hugging Face Transformers, Ollama, vLLM y su propia TensorRT-LLM para implementar optimizaciones específicas en núcleos de atención y enrutado MoE. El resultado es un rendimiento ajustado al milímetro para arquitecturas Hopper y Blackwell.

La infraestructura como arma competitiva

El sistema GB200 NVL72 no es solo hardware: es un ecosistema pensado para que 72 GPUs Blackwell funcionen como una sola GPU de escala masiva gracias a NVIDIA NVLink de quinta generación y NVLink Switch. Esto permite una latencia ultrabaja y un ancho de banda de interconexión que hace posible el objetivo de 1,5 M TPS.

Para empresas de cloud y centros de datos, esta capacidad significa poder servir modelos complejos con menos racks, reduciendo espacio físico, consumo eléctrico y costes de refrigeración. El coste por token procesado cae drásticamente, lo que puede alterar las estrategias de precios de servicios de IA en la nube.

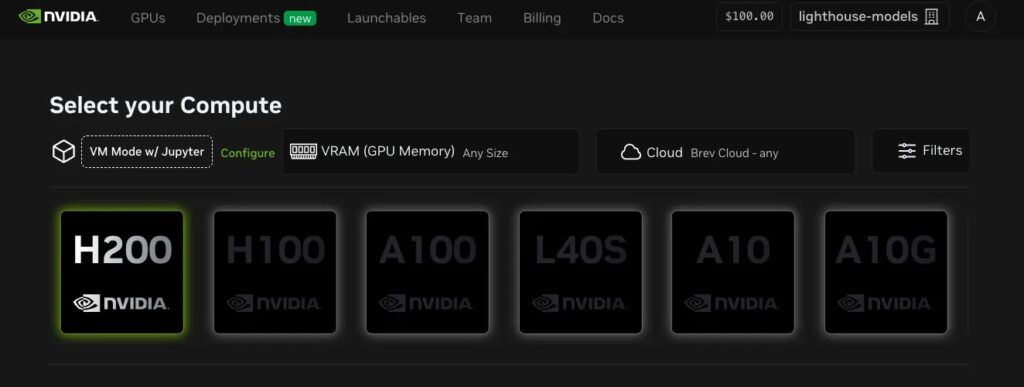

Despliegue: del data center al escritorio

NVIDIA ha diseñado el lanzamiento con una estrategia de distribución en capas, pensando tanto en hiperescalares como en desarrolladores individuales:

- Centros de datos y cloud providers:

- Integración con vLLM para servidores compatibles con API de OpenAI.

- Guías y contenedores Docker en TensorRT-LLM para optimizar casos de baja latencia y alto rendimiento.

- NVIDIA Dynamo, plataforma open source que mejora hasta 4x la interactividad en secuencias largas (32k ISL) mediante inferencia desagregada.

- Entorno empresarial:

- NVIDIA NIM microservices para desplegar modelos en cualquier infraestructura GPU con seguridad de nivel corporativo y control de privacidad.

- API Preview gratuita en el NVIDIA API Catalog para facilitar pruebas.

- Entorno local y desarrollo personal:

- gpt-oss-20b ejecutable en cualquier PC con GPU GeForce RTX con 16 GB VRAM o estaciones profesionales RTX PRO.

- Compatibilidad con Ollama, Llama.cpp y Microsoft AI Foundry Local.

- Ecosistema RTX AI Garage para entornos de prueba preconfigurados.

Impacto económico: más allá de la velocidad

Este lanzamiento tiene implicaciones económicas significativas en varias dimensiones:

- Reducción del coste por token:

Con 1,5 M TPS, se pueden servir más peticiones por unidad de hardware, lo que reduce costes operativos y permite precios más agresivos. - Ventaja en la monetización de IA en tiempo real:

Sectores como finanzas, gaming, salud y soporte al cliente podrán ofrecer servicios impulsados por LLMs complejos sin sacrificar latencia. - Presión sobre competidores:

AMD, Intel y startups de aceleradores como Groq o Cerebras se ven forzadas a demostrar capacidades similares o nichos de especialización para no quedar relegadas. - Consolidación de mercado:

La combinación de hardware, software y modelos optimizados en un solo ecosistema refuerza el efecto red de NVIDIA, dificultando que clientes corporativos cambien a otras plataformas.

El papel de OpenAI y la estrategia de gpt-oss

OpenAI, con el movimiento de liberar pesos y código de los modelos gpt-oss, busca posicionarse como un actor clave también en la comunidad open source, contrarrestando la narrativa de opacidad asociada a GPT-4 y GPT-4.1.

Para OpenAI, esta colaboración con NVIDIA es también una oportunidad para reducir la dependencia económica de modelos cerrados y captar talento y desarrolladores que ahora pueden experimentar con arquitecturas de escala masiva sin coste de licencia.

Riesgos y desafíos

A pesar de las ventajas, el despliegue de modelos de esta magnitud plantea desafíos:

- Consumo energético: incluso con FP4 y optimizaciones, el uso intensivo de GPUs a gran escala es una carga significativa para la red eléctrica.

- Seguridad y alineamiento: modelos con razonamiento avanzado y acceso a herramientas requieren políticas robustas de uso y control.

- Concentración de poder: el dominio de NVIDIA en hardware y software plantea interrogantes regulatorios sobre competencia y acceso equitativo a infraestructura de IA.

Conclusión: un movimiento que redefine el tablero

El lanzamiento de gpt-oss-20b y gpt-oss-120b no es solo un hito técnico, sino un golpe de autoridad de NVIDIA en el mercado de infraestructura de IA.

Con esta combinación de potencia, optimización y disponibilidad, la compañía no solo acelera la ejecución de modelos, sino que marca un nuevo estándar en coste, escalabilidad y experiencia de desarrollo.

Para inversores y analistas, este movimiento refuerza la tesis de que NVIDIA no es solo un fabricante de chips, sino el núcleo de un ecosistema que integra hardware, software, modelos y comunidad. Y en la carrera por dominar la IA generativa de próxima generación, esa integración podría ser la ventaja definitiva.

vía: developer.nvidia.com