Un grupo de investigadores de Stanford, UC Berkeley, el Instituto de Investigación de Toyota y Google DeepMind ha presentado OpenVLA, un modelo de visión-lenguaje-acción (VLA) de código abierto que promete transformar la robótica con inteligencia artificial. Este nuevo avance busca hacer la robótica más accesible y personalizable, permitiendo a más usuarios aprovechar sus capacidades avanzadas.

¿Qué es OpenVLA?

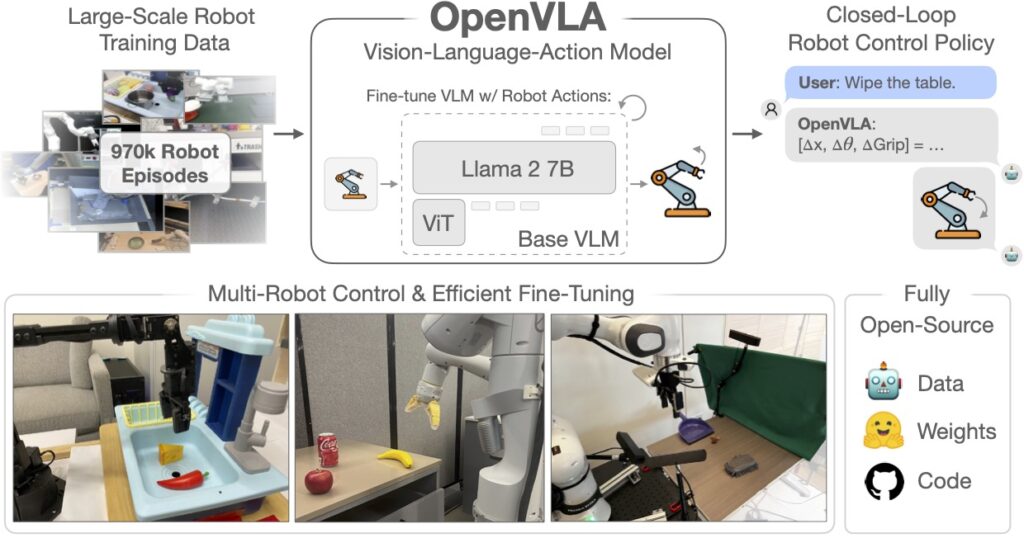

OpenVLA es un modelo con 7 mil millones de parámetros basado en Prismatic-7B, diseñado para extraer características visuales y procesar instrucciones en lenguaje natural. Utilizando un codificador visual de dos partes y el modelo Llama-2 7B, OpenVLA interpreta comandos y decide las acciones que un robot debe realizar para completar tareas específicas.

Formación y Rendimiento

El entrenamiento de OpenVLA se realizó utilizando 970.000 trayectorias de manipulación de robots del dataset Open-X Embodiment. Esto le permite generalizar eficazmente en una amplia gama de tareas y escenarios. Su rendimiento ha superado al modelo RT-2-X de 55 mil millones de parámetros, destacándose en diversas pruebas y entornos. Además, es capaz de ser afinado con estrategias de bajo costo, utilizando técnicas de adaptación de bajo rango (LoRA) y cuantización de modelos.

Implementación y Accesibilidad

Uno de los puntos fuertes de OpenVLA es su accesibilidad. Todos los modelos, cuadernos de implementación y afinación, así como el código base de OpenVLA, están disponibles para la comunidad. Esto incluye soporte para la afinación del modelo en GPUs individuales y el entrenamiento en clusters de múltiples GPUs, así como compatibilidad con técnicas modernas de optimización y paralelización.

Casos de Uso y Futuras Mejoras

OpenVLA ya ha demostrado su eficacia en tareas como la manipulación de objetos y la limpieza de superficies. Los investigadores planean mejorar OpenVLA para soportar múltiples entradas de imagen y datos proprioceptivos, así como el historial de observación, aumentando así su flexibilidad y capacidad de adaptación.

Innovación y Adaptación

El modelo ha sido evaluado en múltiples plataformas de robots, destacándose en la capacidad de generalización en tareas visuales, de movimiento y físicas. OpenVLA supera a otros modelos como RT-2-X en la alineación precisa del robot con los objetos objetivo y la recuperación de errores, como agarrar objetos de manera insegura.

Fine-Tuning Eficiente

OpenVLA se ha adaptado eficazmente a nuevos entornos de robots, demostrando su capacidad para ser afinado rápidamente con un rendimiento destacado en comparación con otros enfoques como Diffusion Policy. Este modelo muestra un rendimiento superior en tareas que requieren la vinculación del lenguaje con el comportamiento en entornos multitarea y con múltiples objetos.

Un Futuro Prometedor para la Robótica

OpenVLA representa un avance significativo en la robótica al ofrecer modelos VLA de alto rendimiento y accesibles a un público más amplio. Con su capacidad para generalizar tareas y su eficiencia en el uso de recursos, este modelo tiene el potencial de transformar la manera en que los robots interactúan con el mundo.

Para obtener más información sobre OpenVLA y descargar los modelos y herramientas de entrenamiento, visita OpenVLA en HuggingFace.