La creciente importancia de los sistemas de inteligencia artificial generativa como servicio (SaaS) en la economía digital plantea desafíos significativos en términos de escalabilidad y gestión de costos. Especialmente complejo resulta el diseño de servicios multitenencia que deben atender a una base diversa de clientes, mientras se mantienen firmes controles de costos y un monitoreo exhaustivo del uso.

Los métodos tradicionales para la gestión de costos en estos sistemas demuestran limitaciones notables. A menudo, los equipos de operaciones luchan para atribuir costos de manera precisa a cada inquilino, enfrentándose a la variabilidad de los patrones de uso. Los comportamientos de consumo pueden fluctuar, con algunos clientes experimentando aumentos repentinos en los picos de uso, mientras que otros presentan patrones más estables.

Para enfrentar estos retos, se plantea una solución robusta basada en sistemas de alertas dinámicas y contextualizadas. Estos van más allá del monitoreo convencional, con niveles de alerta graduados que varían desde verde (operaciones normales) hasta rojo (intervenciones críticas). Dichas alertas permiten desarrollar respuestas automáticas e inteligentes que se adaptan a los patrones de uso, ayudando a prevenir sobrecostos y a gestionar los recursos de manera proactiva.

El punto crítico en la gestión de costos suele llegar con la detección de sobrecostos significativos, provocados por múltiples inquilinos que incrementan su uso conjuntamente. Los sistemas de monitoreo actuales, con notificaciones binarias, a menudo no detectan estas tendencias con antelación. La complejidad aumenta si se aplican modelos de precios escalonados. Sin un sistema de alertas avanzado, que diferencie picos normales de verdaderos problemas, los equipos de operaciones se ven forzados a responder de manera reactiva.

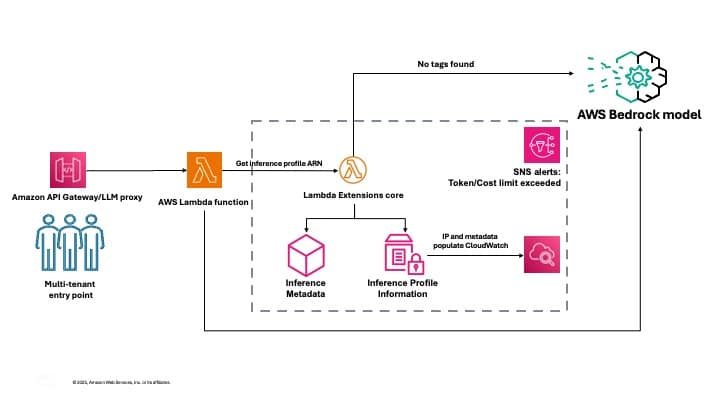

Para facilitar una gestión eficaz de costos en ambientes multiinquilino de inteligencia artificial generativa, se ha desarrollado un enfoque que utiliza perfiles de inferencia de Amazon Bedrock. Estos permiten un seguimiento detallado de los costos, asociando metadatos con cada solicitud de inferencia y separando lógicamente diferentes aplicaciones o clientes. Una estrategia de etiquetado consistente permite rastrear sistemáticamente qué inquilino es responsable de cada llamada a la API y su consumo respectivo.

La arquitectura de esta solución recoge y agrega datos de uso de manera efectiva, almacenando métricas históricas para análisis de tendencias y proporcionando percepciones prácticas mediante paneles intuitivos. Este complejo sistema de monitoreo ofrece la visibilidad y control necesarios para gestionar los costos asociados a Amazon Bedrock, adaptándose a las necesidades específicas de cada organización.

Implementar esta solución no solo facilita el seguimiento del uso de modelos, sino que también permite una asignación precisa de costos y la optimización del consumo de recursos entre diferentes inquilinos. A través de ajustes y desarrollos adicionales, basados en patrones de uso y retroalimentación, se puede lograr una administración más efectiva y eficiente de los recursos en entornos de inteligencia artificial generativa.