¡Imagínate tener un modelo de inteligencia artificial (IA) tan pequeño que quepa en un disquete! Eso es exactamente lo que NVIDIA ha logrado con «Perfusion«, un sorprendente modelo de «texto a imagen» que ocupa apenas 100KB. Sí, lo has oído bien, ¡es mucho menos que cualquier imagen que tomes con tu teléfono móvil! Pero, ¿por qué es esto tan revolucionario y cómo puede cambiarlo todo?

Perfusion es un modelo de «texto a imagen» excepcionalmente ligero, con un tamaño de tan solo 100KB, y lo más asombroso es que se entrena en tan solo 4 minutos.

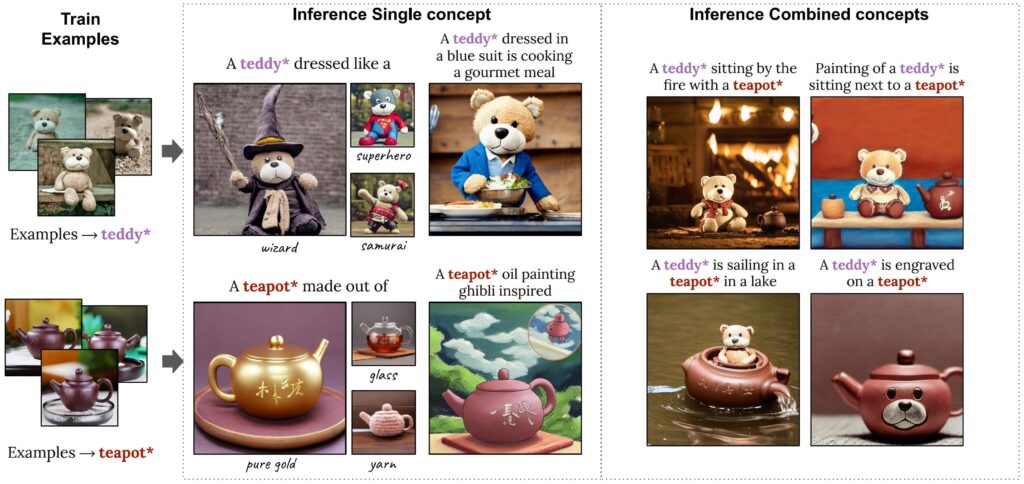

Perfusion es un nuevo método de personalización de texto a imagen que ha sido presentado recientemente. A pesar de su pequeño tamaño, 100KB, y un tiempo de entrenamiento de aproximadamente 4 minutos, Perfusion tiene la capacidad de retratar creativamente objetos personalizados. Permite realizar cambios significativos en su apariencia, al mismo tiempo que mantiene su identidad, gracias a un novedoso mecanismo que llamamos «Key-Locking» (bloqueo de clave). Perfusion también puede combinar conceptos aprendidos individualmente para generar una sola imagen. Finalmente, ofrece un control preciso entre la alineación visual y textual durante el proceso de inferencia, abarcando todo el frente de Pareto con un solo modelo entrenado.

Perfusion puede crear fácilmente imágenes atractivas. Usualmente, con tan solo 8 semillas de entrada (seeds), es capaz de generar varias muestras de imágenes de buena calidad.

Resumen

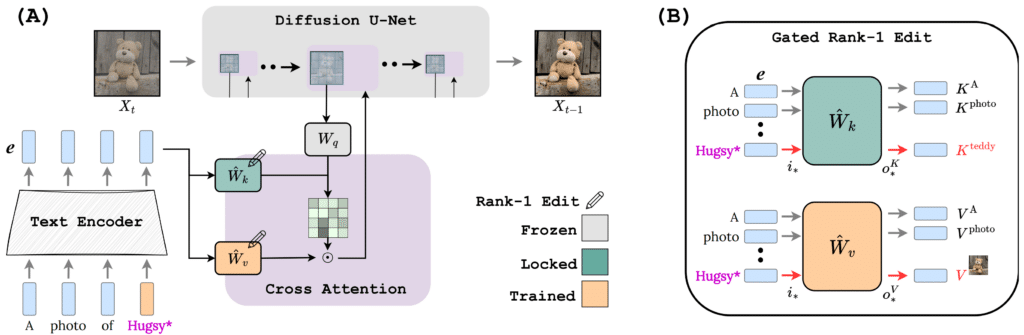

Los modelos de «texto a imagen» (T2I) ofrecen un nuevo nivel de flexibilidad al permitir a los usuarios guiar el proceso creativo a través del lenguaje natural. Sin embargo, la personalización de estos modelos para alinearse con los conceptos visuales proporcionados por el usuario sigue siendo un desafío. La tarea de personalización de T2I presenta múltiples desafíos difíciles, como mantener una alta fidelidad visual mientras se permite el control creativo, combinar múltiples conceptos personalizados en una sola imagen y mantener un tamaño de modelo reducido. En este contexto, se presenta Perfusion, un método de personalización de T2I que aborda estos desafíos utilizando actualizaciones dinámicas de rango 1 en el modelo subyacente de T2I. Perfusion evita el sobreajuste al introducir un nuevo mecanismo que «bloquea» las claves de atención cruzada de nuevos conceptos a su categoría superior. Además, se desarrolla un enfoque de rango 1 con compuertas que nos permite controlar la influencia de un concepto aprendido durante el proceso de inferencia y combinar múltiples conceptos. Esto permite un equilibrio eficiente entre la fidelidad visual y la alineación textual con un solo modelo entrenado de 100KB, lo que representa una reducción de cinco órdenes de magnitud en comparación con el estado del arte actual. Además, Perfusion puede abarcar diferentes puntos de operación a lo largo del frente de Pareto sin necesidad de entrenamiento adicional. Finalmente, se demuestra que Perfusion supera a fuertes líneas de base tanto cualitativa como cuantitativamente. Es importante mencionar que el bloqueo de claves conduce a resultados novedosos en comparación con los enfoques tradicionales, permitiendo retratar interacciones de objetos personalizados de maneras nunca antes vistas, incluso en escenarios de un solo intento.

¿Cómo funciona?

Esquema de la arquitectura (A): Una solicitud (prompt) se transforma en una secuencia de codificaciones. Cada codificación se alimenta a un conjunto de módulos de atención cruzada (bloques morados) de un desenrrollador U-Net de difusión (diffusion U-Net denoiser). El módulo morado ampliado muestra cómo los caminos de Clave y Valor se condicionan según la codificación del texto. La Clave impulsa el mapa de atención, que luego modula el camino del Valor. Edición de Rango-1 con compuerta (B): Arriba: El camino K está bloqueado, por lo que cualquier codificación de 𝑒_Hugsy que llega a 𝑊𝑘 se mapea a la clave de la categoría superior 𝐾_teddy. Abajo: Cualquier codificación de 𝑒_Hugsy que llega a 𝑊𝑣 se mapea a 𝑉_Hugsy, que es aprendida. El aspecto con compuerta de esta actualización permite aplicarla selectivamente solo a las codificaciones necesarias y proporciona medios para regular la fuerza del concepto aprendido, tal como se expresa en las imágenes de salida.

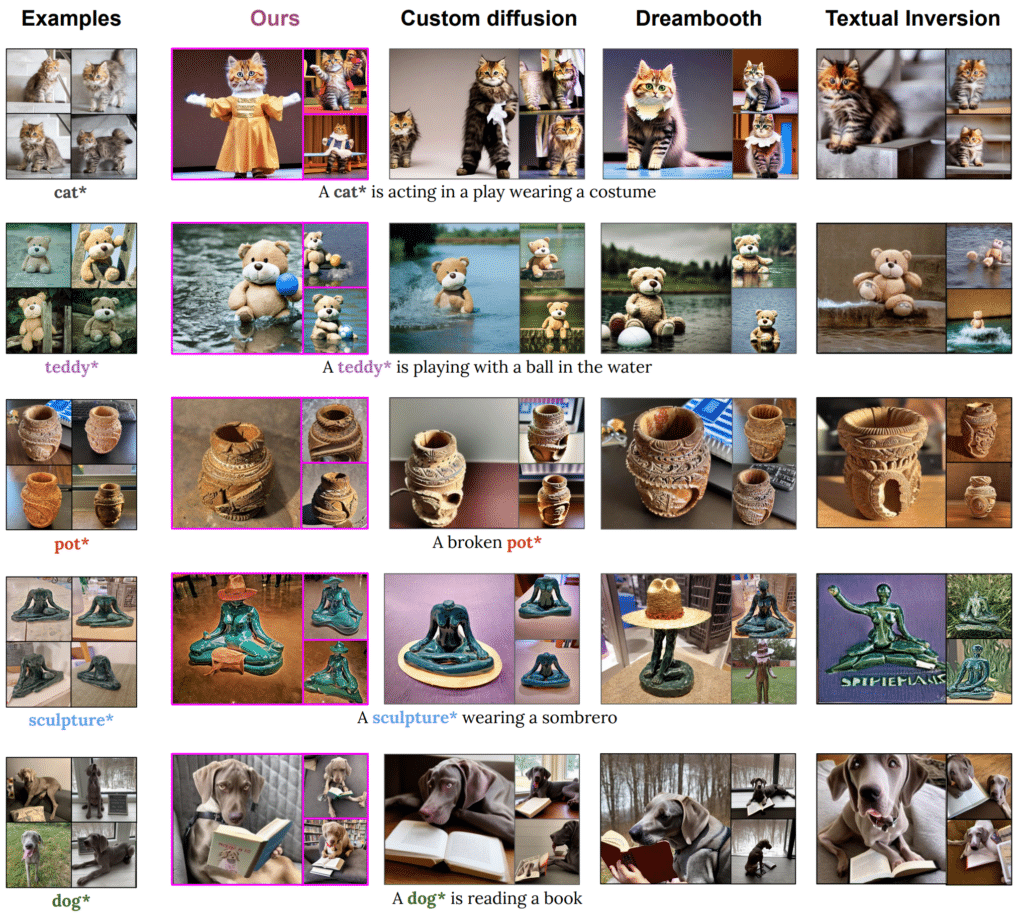

Comparación con los métodos actuales

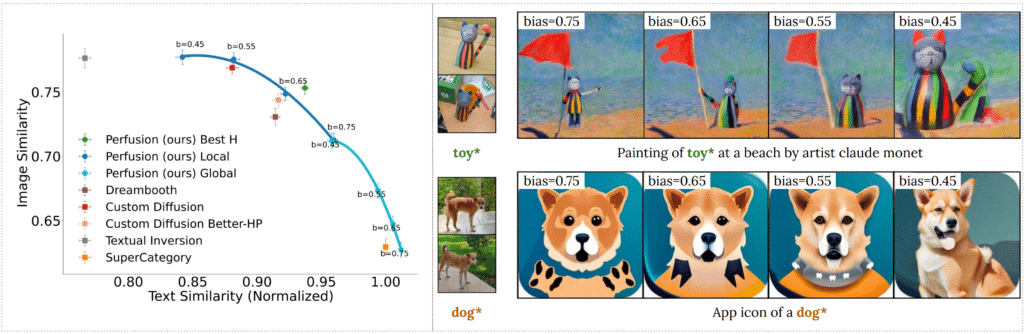

Perfusion puede ofrecer resultados más animados, con una mejor coincidencia de la solicitud (prompt) y una menor susceptibilidad a los rasgos de fondo de la imagen original. Para cada concepto, mostramos ejemplos de nuestro conjunto de entrenamiento, junto con imágenes generadas, sus textos de condicionamiento y comparaciones con baselines como Custom-Diffusion, Dreambooth y Textual-Inversion.

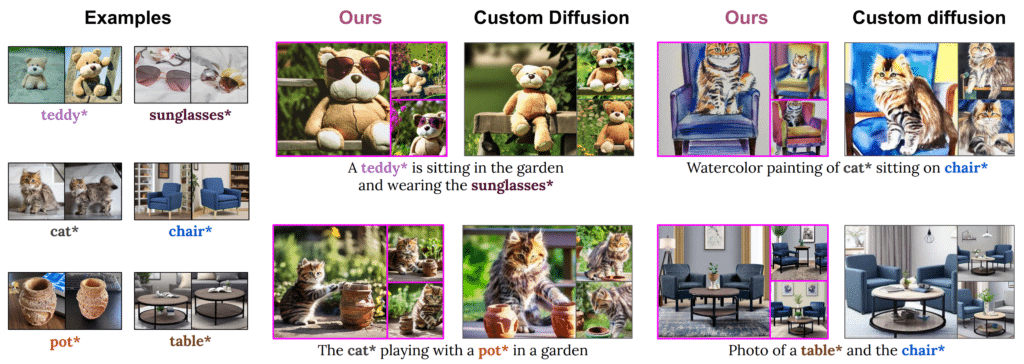

Composiciones

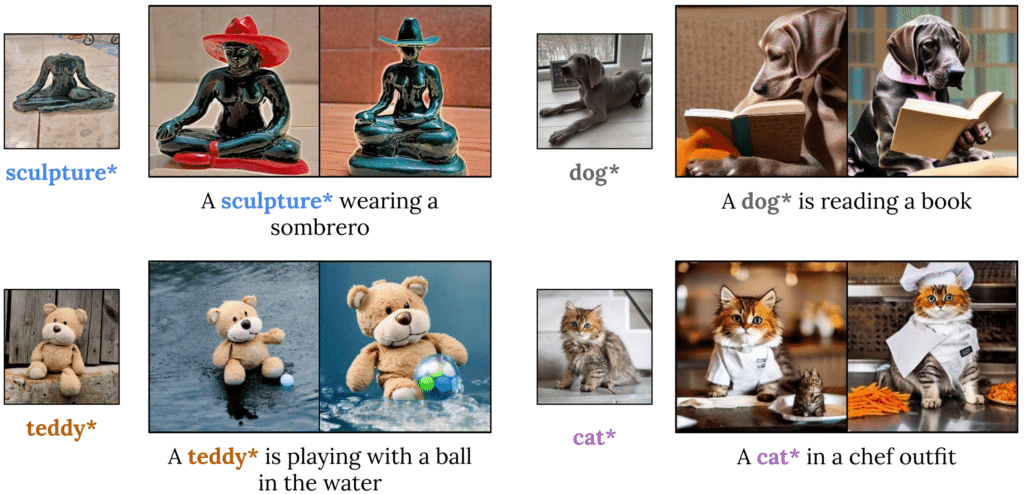

Nuestro método nos permite combinar múltiples conceptos aprendidos en una sola imagen generada, utilizando una solicitud de texto. Los conceptos se aprenden de forma individual y se combinan solo durante el proceso de ejecución para producir la imagen final. Esto resulta en una visualmente atractiva exhibición de interacciones de conceptos que comparamos con Custom-Diffusion. Excepto por la solicitud de «teddy*», todas las solicitudes provienen del artículo Custom-Diffusion y utilizan las imágenes proporcionadas por el mismo.

Control eficiente de la alineación visual-textual

Nuestro método permite controlar el compromiso entre la fidelidad visual y la alineación textual durante la inferencia. Un alto valor de sesgo reduce el efecto del concepto, mientras que un valor bajo lo hace más influyente. Con un solo modelo entrenado de 100KB y elecciones de parámetros en tiempo de ejecución, Perfusion (en azul y cian) abarca todo el frente de Pareto.

Personalización de un solo intento

Cuando se entrena con una sola imagen, nuestro método puede generar imágenes con alta fidelidad visual y alineación textual.

Comparando tipos de bloqueo de claves

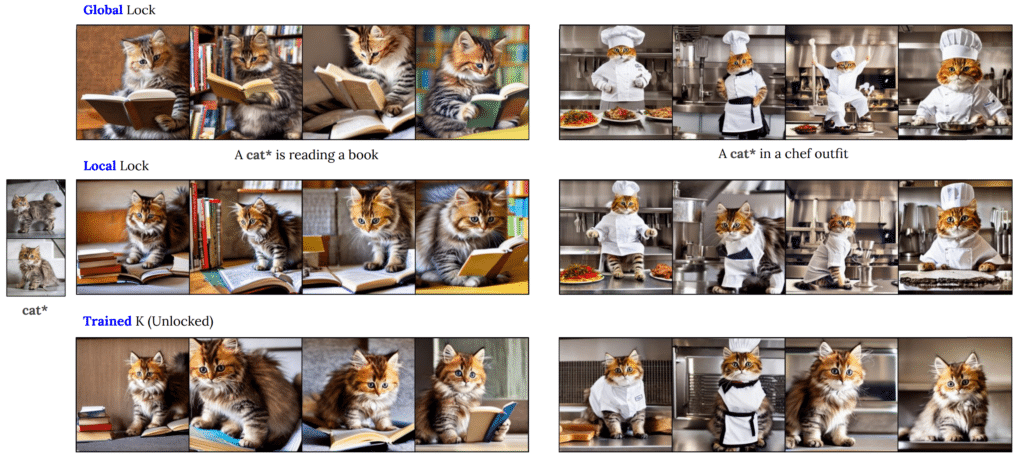

Presentamos 3 variaciones del bloqueo de claves:

- El bloqueo global de claves permite una mayor variabilidad visual y puede retratar con precisión los matices de un objeto o actividad, como cuando se representa a un gato en una postura similar a la de un humano, leyendo un libro o vistiendo un traje de chef.

- El bloqueo local de claves también tiene éxitos, pero no es tan efectivo como el bloqueo global de claves.

- Finalmente, el bloqueo de claves «Trained-K» tiene una mejor compatibilidad con las imágenes de entrenamiento, pero sacrifica su alineación con el texto.

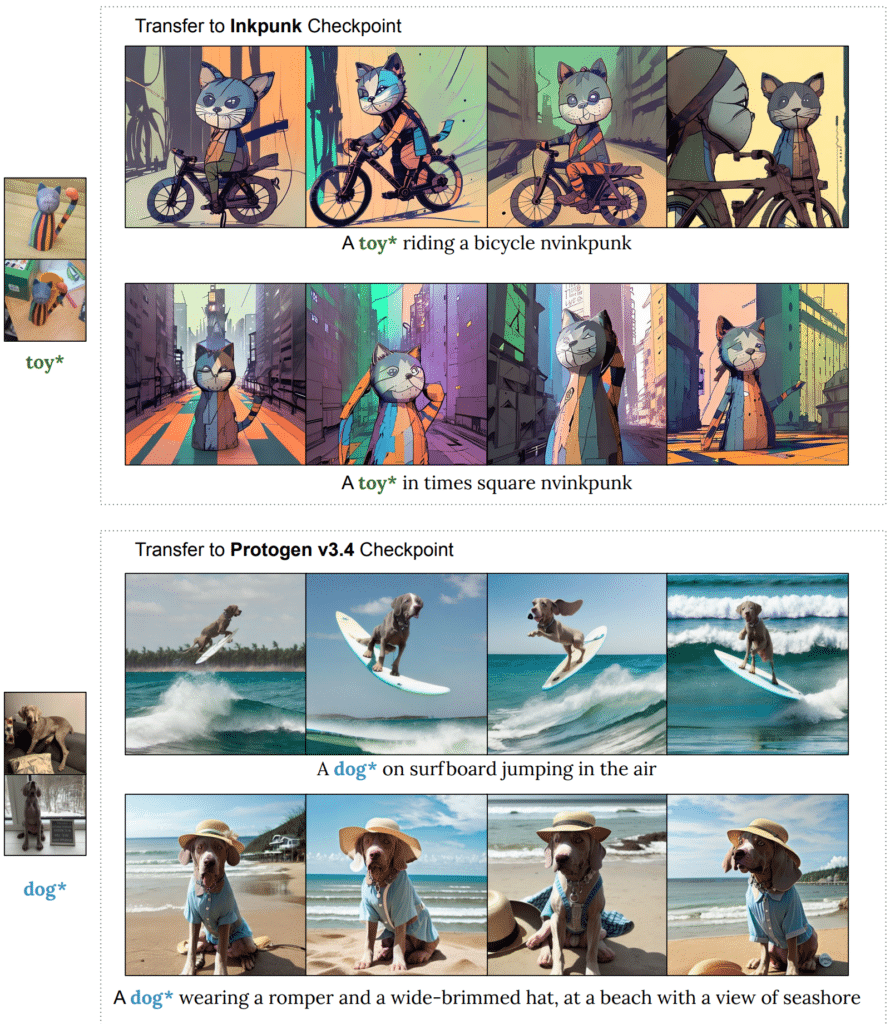

Transferencia sin entrenamiento a modelos afinados

Un concepto de Perfusion entrenado utilizando un modelo de difusión básico puede generalizarse a variantes afinadas.

Referencias: Research Nvidia y Twitter Javilop.