La startup especializada en modelos conversacionales presenta sus innovadoras estrategias para generar voz de alta calidad y baja latencia en tiempo real

PlayAI, una empresa centrada en el desarrollo de modelos conversacionales de vanguardia, ha desvelado públicamente las técnicas que emplea para convertir la síntesis de texto a voz (TTS, por sus siglas en inglés) en una experiencia fluida, natural y de confianza. En una publicación técnica detallada titulada “Taming the TTS Beast”, la compañía ha compartido por primera vez los métodos que permiten extraer el máximo rendimiento de sus modelos autoregresivos, sin comprometer la velocidad ni la calidad en aplicaciones críticas.

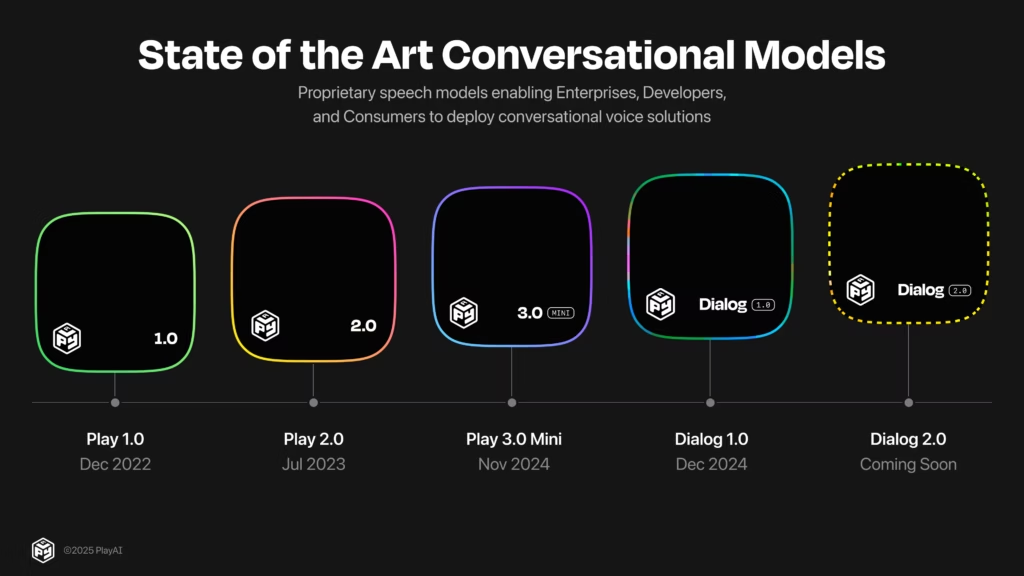

Desde su fundación en 2018, PlayAI ha transitado un camino de continua experimentación, rediseñando arquitecturas transformer para adaptarlas a contextos de habla en tiempo real. El equipo de investigación en aprendizaje automático de la firma afirma haber realizado miles de pruebas con diferentes variantes de modelos, enfrentándose a los tres grandes desafíos del TTS en streaming: latencia, continuidad y coherencia contextual.

Generar y elegir: el enfoque por candidatos paralelos

Una de las piedras angulares de su estrategia reside en la generación paralela de múltiples versiones de cada segmento de voz. En lugar de producir una única salida de audio, los modelos de PlayAI generan entre 4 y 8 candidatos por fragmento de texto, cada uno con variaciones en entonación, ritmo y expresión emocional.

Posteriormente, un módulo especializado evalúa estos candidatos mediante un sistema de ranking que ha ido evolucionando con el tiempo. El audio seleccionado es el que se transmite al usuario, y el modelo continúa la generación desde el estado interno exacto de ese candidato, garantizando así la continuidad del flujo sonoro.

Técnicas de guía para mantener la voz en el camino correcto

PlayAI ha adaptado métodos originalmente usados en la generación de imágenes —como la Classifier-Free Guidance— al terreno del TTS. Aplicando este enfoque, contrasta predicciones hechas con y sin condiciones específicas (texto, voz, estilo), para así inclinar al modelo hacia resultados más deseados.

Estas guías permiten que el sistema mantenga la fidelidad al guion, conserve la identidad del hablante y preserve el estilo solicitado (por ejemplo, “voz emocionada” o “tono formal”). La clave radica en ajustar cuidadosamente la “fuerza” de cada guía, ya que un exceso podría derivar en un habla artificial o forzada.

El poder del “autocontrol” del modelo

Para reforzar la precisión textual del habla generada, PlayAI ha implementado una innovadora estrategia de autoevaluación. Utiliza su propio modelo en “modo ASR” (reconocimiento automático de voz) para comparar qué tan bien encaja el audio generado con el texto original.

Este enfoque también se ha extendido a características expresivas como el tono emocional. Por ejemplo, si se solicita una entonación “enfadada”, el sistema es capaz de puntuar qué tan fiel es cada candidato a esa emoción, y utilizar dicha puntuación para seleccionar el mejor resultado.

De la atención al alineador experto

Aunque en etapas iniciales se utilizaban mapas de atención internos del modelo para evaluar la calidad de cada fragmento, PlayAI reconoce que esta técnica presenta limitaciones en escenarios de generación defectuosa. Como respuesta, ha desarrollado un modelo externo de alineación acústico-textual que actúa como un supervisor especializado.

Este alineador genera puntuaciones detalladas sobre cada fragmento, evaluando la cobertura del texto, la aparición de silencios no deseados o de alucinaciones, la fluidez secuencial y otros factores. Estas señales se combinan con la confianza interna del modelo TTS para tomar decisiones informadas, incluso en contextos de streaming exigentes.

Según las pruebas realizadas por PlayAI, este sistema combinado ha conseguido reducir la tasa de error de palabra (WER) hasta un 2,20 % y la de carácter (CER) hasta un 0,88 % en el benchmark CMU Arctic, todo ello sin sacrificar la naturalidad prosódica del habla.

El futuro: simplificar, adaptar e integrar

A pesar de los avances logrados, el equipo de PlayAI considera que la “bestia del TTS” aún no ha sido completamente domada. Su objetivo es simplificar el complejo sistema de técnicas de inferencia, adaptarlo a nuevas arquitecturas de modelos y, eventualmente, integrar algunas de estas técnicas en el propio proceso de entrenamiento.

“La generación de voz indistinguible de la humana ya no es una meta lejana, pero la fiabilidad, la expresividad y la capacidad de control granular son igual de importantes”, explican desde la compañía. “Nuestro trabajo en tiempo de inferencia representa el tramo final hacia un producto que no solo hable, sino que comunique de verdad”.

Con estos avances, PlayAI se posiciona como uno de los referentes en un campo en auge, con aplicaciones que van desde asistentes virtuales hasta doblaje automático o videojuegos. Y si algo queda claro tras esta publicación, es que el verdadero desafío no es solo hablar como un humano… sino hacerlo de forma consistente, comprensible y emotiva, sin fallos, en cualquier momento y lugar.

vía: blog.play.ai