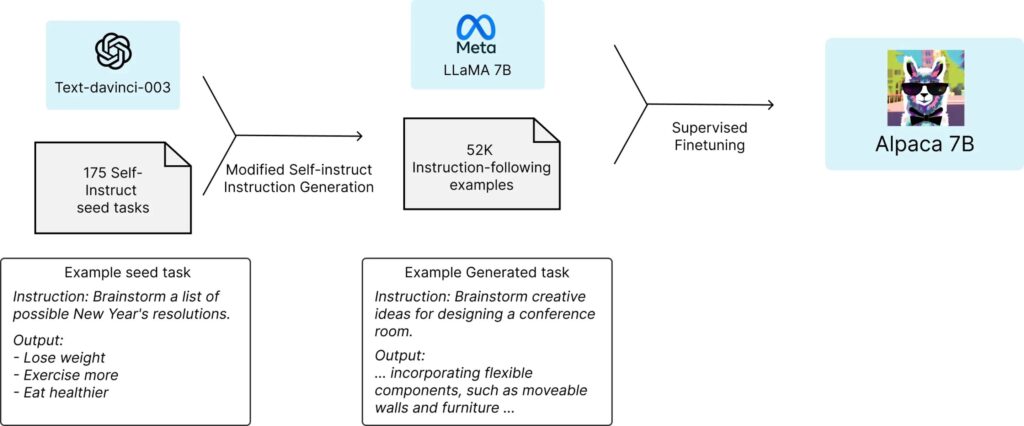

Un equipo de investigadores de Stanford ha logrado desarrollar un modelo de lenguaje basado en IA que compite con el ChatGPT de OpenAI en diversas tareas, pero a un costo de entrenamiento de menos de 600 dólares (aprox 600 euros). Este modelo, denominado Alpaca, fue entrenado utilizando el modelo de lenguaje de código abierto LLaMA 7B de Meta.

La aparición de modelos de lenguaje como ChatGPT ha impactado al mundo entero, ya que estos son capaces de comunicarse de manera casi indistinguible de los humanos y tienen el potencial de transformar la sociedad humana al automatizar diversas tareas laborales. Sin embargo, el desarrollo y entrenamiento de estos modelos también genera preocupaciones en cuanto a su potencial para el spam, la desinformación y otros usos negativos.

El equipo de Stanford utilizó el modelo LLaMA 7B como base y aprovechó la API de OpenAI para generar datos de entrenamiento masivo a bajo costo. Tras ajustar el modelo con estos datos, Alpaca demostró un desempeño impresionante en pruebas que incluían escritura de correos electrónicos, redes sociales y herramientas de productividad, logrando un rendimiento similar al de ChatGPT.

Aunque el equipo de Stanford Alpaca ha compartido en Github las preguntas utilizadas en su investigación y el código para generar más datos, advierten que no han ajustado el modelo Alpaca para garantizar su seguridad e inocuidad. Solicitan que quienes lo utilicen informen sobre problemas de seguridad y ética que puedan encontrar.

Stanford University

Este avance plantea desafíos para las empresas de IA comerciales que trabajan en el desarrollo de sus propios modelos de lenguaje, ya que si gran parte del tiempo y el gasto se incurre en la fase de post-entrenamiento y este trabajo puede ser replicado a bajo costo, es posible que no tenga sentido seguir invirtiendo grandes sumas en esta etapa.

Además, el hecho de que sea más fácil y económico crear modelos de lenguaje no controlados implica que personas con conocimientos de aprendizaje automático podrían desarrollar estas IA sin preocuparse por las regulaciones, términos y condiciones o la piratería de software. Esto podría ser de gran utilidad para regímenes autoritarios, operaciones de phishing, generadores de spam u otros individuos sospechosos.

En resumen, investigadores de Stanford han demostrado que es posible replicar y entrenar modelos de lenguaje similares a ChatGPT a un costo significativamente menor, lo que plantea preocupaciones sobre el control y regulación de estos avances tecnológicos. La sociedad deberá estar preparada para enfrentar los desafíos y oportunidades que traerá esta nueva generación de IA en el futuro

Más información en el artículo de New Atlas, Stanford y este vídeo AI Explained.