Investigadores han descubierto que una simple instrucción de «ser conciso» en los prompts de cadena de pensamiento puede reducir la longitud de las respuestas de la IA en un 50% sin afectar significativamente la precisión, lo que lleva a un ahorro de más del 20% en los costos de las llamadas a la API.

La Técnica de Cadena de Pensamiento (CoT)

La técnica de Cadena de Pensamiento (CoT) instruye a la IA a razonar paso a paso antes de dar una respuesta final, mejorando la precisión en problemas complejos. Sin embargo, este enfoque tiende a generar respuestas más largas, incrementando los costos de uso de la IA.

El Estudio

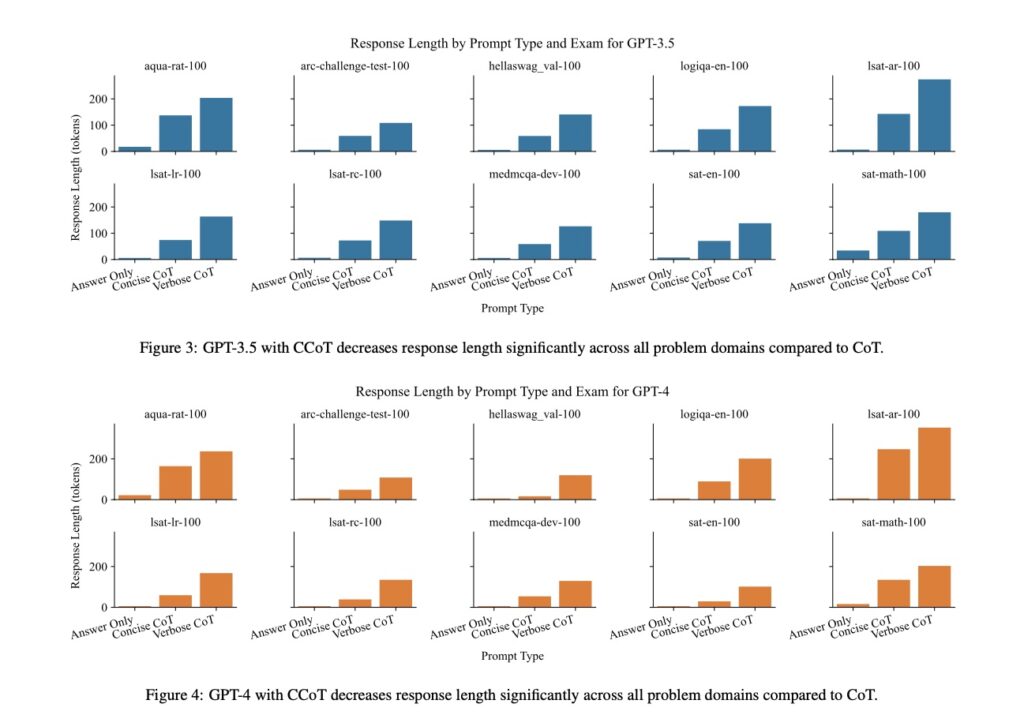

Investigadores de las universidades de Adelaide y Melbourne realizaron un metaanálisis, evaluando 71 estudios sobre el impacto del método de pago en los hábitos de consumo. Aplicaron la instrucción «ser conciso» a los prompts de CoT en modelos GPT-3.5 y GPT-4, usando 1,000 preguntas de opción múltiple en 10 temas diferentes.

Resultados

- Reducción en la longitud de las respuestas: La instrucción de ser conciso redujo la longitud de las respuestas en aproximadamente un 50% en comparación con los prompts CoT estándar.

- Impacto en la precisión: La precisión de las respuestas no se vio significativamente afectada por la concisión, manteniéndose en niveles comparables a los de CoT estándar.

- Ahorro en costos: Esta reducción en la longitud de las respuestas se tradujo en un ahorro de más del 20% en los costos por consulta a la API, debido a la menor generación de tokens.

Conclusiones

- Optimización de costos: Instruir a la IA a ser concisa puede llevar a una reducción significativa en los costos operativos sin sacrificar la precisión.

- Eficiencia energética: Menos tokens generados también implican un menor consumo de energía, haciendo el proceso más sostenible.

- Reducción de tiempos de respuesta: Las respuestas más cortas se generan más rápidamente, mejorando la experiencia del usuario.

- Mantenimiento de la precisión: A pesar de la reducción en la longitud de las respuestas, la precisión en la resolución de problemas complejos se mantiene prácticamente intacta.

- Aplicabilidad general: Esta técnica puede ser implementada fácilmente en diversos modelos de IA, optimizando su rendimiento en distintos contextos.

- Mejora continua: Los resultados sugieren que seguir explorando variaciones en los prompts podría llevar a una mayor optimización y comprensión de los mecanismos de razonamiento en modelos de lenguaje.

Este descubrimiento resalta cómo pequeños ajustes en las instrucciones a la IA pueden tener un gran impacto en la eficiencia y los costos, abriendo nuevas posibilidades para el uso de modelos de lenguaje en aplicaciones prácticas.

Referencia: Arxiv