Anthropic presentó Claude Haiku 4.5, su nuevo modelo pequeño, con un mensaje directo al mercado: lo que hace cinco meses era “punta de lanza” ahora es más rápido y cuesta menos. La compañía asegura que Haiku 4.5 alcanza niveles de rendimiento en programación cercanos a Claude Sonnet 4 —el modelo que hace medio año situó el listón— a un tercio del coste y con más del doble de velocidad. En algunas tareas, como uso de ordenador dentro de entornos de agente, lo supera. El resultado apunta a una franja de uso con latencia muy baja (asistentes conversacionales, agentes de atención al cliente, pair programming, herramientas en navegador), donde el tiempo de respuesta y el coste por petición son críticos.

La versión Claude Sonnet 4.5, publicada hace dos semanas, sigue siendo el modelo de referencia de la casa y —en palabras de la empresa— “el mejor modelo de coding” del momento. Haiku 4.5 llega como opción complementaria: rendimiento casi de frontera con eficiencia de coste para escalar la inferencia y, en paralelo, nuevas estrategias de orquestación. Un patrón ya sugerido por Anthropic es que Sonnet 4.5 genere el plan de un problema complejo y coordine un equipo de varios Haiku 4.5 que ejecuten subtareas en paralelo.

Qué es Claude Haiku 4.5 y qué cambia en la práctica

Haiku 4.5 es el nuevo modelo “pequeño” de Anthropic, disponible desde hoy para todos los usuarios en apps (incluido Claude Code), extensiones (como Claude para Chrome) y plataformas nube. Para desarrolladores, está expuesto vía Claude API bajo el nombre claude-haiku-4-5; también puede consumirse en Amazon Bedrock y Google Cloud Vertex AI, donde actúa como sustituto directo (drop-in replacement) de Haiku 3.5 y, en escenarios de eficiencia, incluso de Sonnet 4. El precio se sitúa en 1 $ / 5 $ por millón de tokens (entrada/salida, respectivamente), el escalón más económico del catálogo actual de la compañía.

Para quienes ya trabajan con Claude Code, la promesa es tangible: prototipado más responsivo, proyectos multiagente que no se encallan en la latencia y una experiencia de asistencia al desarrollo que “se siente” en tiempo real. En agentes conversacionales y atención al cliente, Haiku 4.5 apunta a ventanillas de respuesta con retardo mínimo, sin renunciar a razonamiento suficiente para resolver flujos de varias etapas.

Rendimiento, coste y latencia: el nuevo equilibrio

Cinco meses bastaron para que el rendimiento de Sonnet 4 “casi de vanguardia” se convirtiera en base de partida para Haiku 4.5 con menos coste y más velocidad. En palabras de clientes piloto citados por la compañía, el modelo logra alrededor del 90 % del rendimiento de Sonnet 4.5 en tareas de agente de código, igualando a modelos más grandes en pruebas internas, y lo hace con respuestas más rápidas. Otros testimonios resaltan que “la velocidad es la nueva frontera” para agentes que operan en bucles de retroalimentación, donde mantener momentum entre pasos importa tanto como la calidad del razonamiento. Uno de los partners llegó a afirmar que, en determinados escenarios, Haiku 4.5 corre entre 4 y 5 veces más rápido que Sonnet 4.5 a fracción de coste, abriendo casos de uso que hace seis meses no eran viables en términos de unit economics.

En marketing de producto, estas comparativas siempre deben leerse con contexto: tipo de tarea, presupuesto de thinking y prompting, uso de herramientas, sampling y orquestación influyen. No obstante, la tendencia que dibuja Anthropic es nítida: menos sacrificios entre calidad, coste y velocidad para llevar IA al día a día operativo.

Benchmarks y metodología: lo que se midió (y cómo)

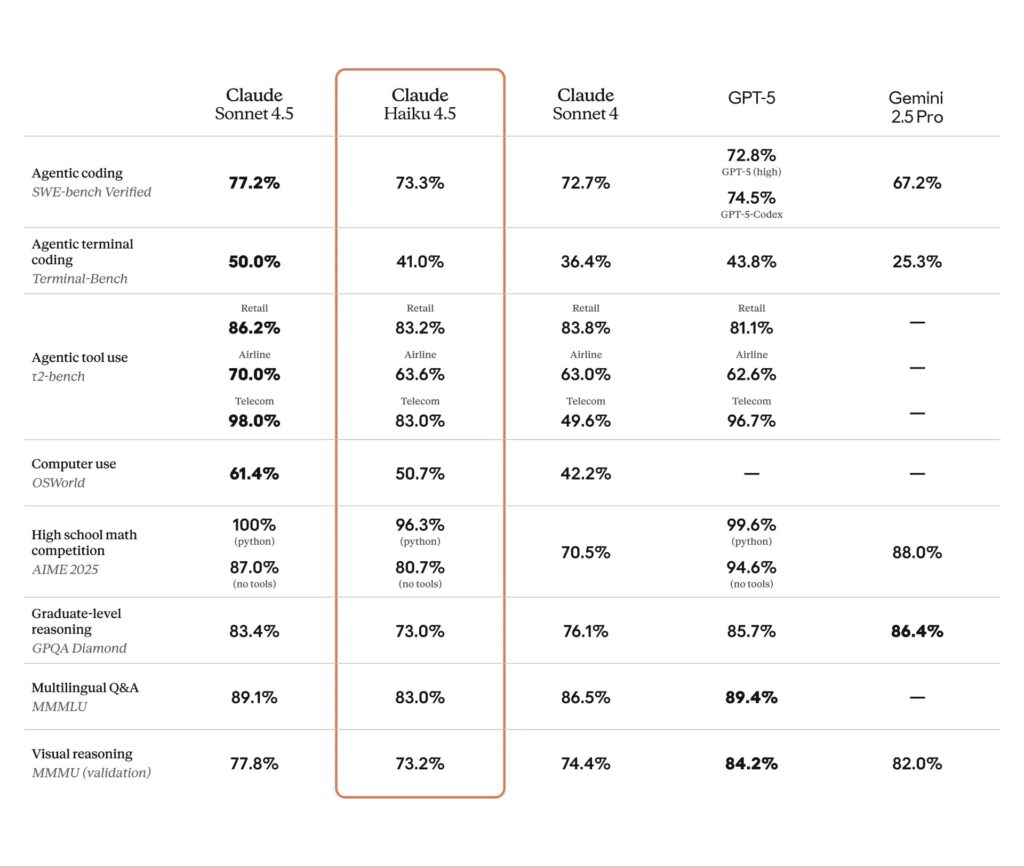

Para sostener su narrativa, Anthropic publicó resultados en conjuntos de referencia conocidos, con metodologías concretas:

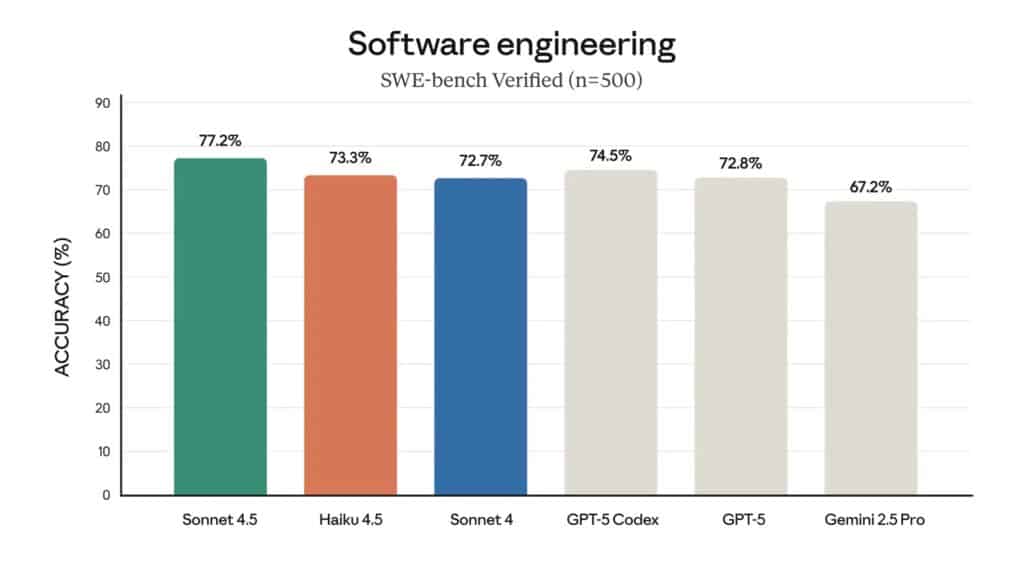

- SWE-bench Verified (500 problemas de coding realista): 73,3 % de media, 50 repeticiones, sin cómputo en test-time, con 128.000 tokens de presupuesto de “pensamiento” y parámetros por defecto. Se utilizó un andamio sencillo con dos herramientas (bash y edición de archivos por reemplazo de cadenas) y un añadido de prompt orientado a fomentar uso intensivo de herramientas (“idealmente más de 100 veces”) y escritura de tests antes de resolver.

- Terminal-Bench (interacción en terminal): resultados con el framework Terminus 2, promediando 11 ejecuciones y variantes con y sin thinking budget (ej.: 40,21 % sin thinking; 41,75 % con 32.000 tokens de thinking, un solo intento).

- τ²-bench (agentes por dominios como aerolíneas/telecom): promedios sobre 10 ejecuciones con 128.000 tokens de thinking y adendas de prompt para evitar modos de fallo conocidos.

- AIME (razonamiento matemático): media de 10 corridas con pass@1 calculado sobre 16 ensayos y 128.000 tokens de thinking.

- OSWorld-Verified (tareas en sistemas operativos): con el marco oficial, 100 pasos máximos, 4 corridas, 128.000 tokens totales y 2.000 por paso.

- MMMLU (multilingüe en 14 idiomas no ingleses): medias sobre 10 corridas con 128.000 tokens de thinking.

Para el resto de benchmarks, se aplicó la misma lógica: promedios sobre 10 ejecuciones, parámetros por defecto y presupuesto de 128.000 tokens para “pensamiento”. En las tablas comparativas, Anthropic referencia fuentes públicas para las puntuaciones de OpenAI y Gemini (posts técnicos, system cards y leaderboards de Terminal-Bench), una práctica útil para comparar, aunque siempre bajo la salvedad de que prompts, scaffolds y herramientas influyen notablemente en los resultados.

Seguridad y alineamiento: ASL-2 y menor tasa de desalineación

El lanzamiento incorpora un bloque específico de evaluaciones de seguridad. Según la empresa:

- Claude Haiku 4.5 mostró tasas bajas de comportamientos preocupantes y un nivel de alineamiento sustancialmente mejor que Haiku 3.5.

- En una evaluación automatizada de alineamiento, el modelo exhibió una tasa global de comportamientos desalineados estadísticamente menor que Sonnet 4.5 y Opus 4.1, lo que lo convertiría —en ese métrica— en el modelo más seguro de la familia actual.

- En riesgos CBRN (químico, biológico, radiológico, nuclear), el riesgo observado fue limitado, razón por la que Haiku 4.5 se publica bajo el estándar AI Safety Level 2 (ASL-2), menos restrictivo que el ASL-3 aplicado a Sonnet 4.5 y Opus 4.1.

La empresa ha puesto a disposición una system card con el razonamiento detrás de la clasificación ASL-2 y el detalle del resto de pruebas. Para equipos que evalúan despliegues en empresa, contar con esta trazabilidad es clave a efectos de cumplimiento, auditoría y gobernanza de riesgos.

Dónde encaja en tu stack: del navegador a la nube

Disponibilidad:

- Apps y extensiones: Haiku 4.5 ya impulsa Claude Code y Claude para Chrome, donde la mejora de latencia se nota.

- API:

claude-haiku-4-5en Claude API. - Nube pública: Amazon Bedrock y Google Cloud Vertex AI, con despliegue como sustituto de Haiku 3.5 y, si el foco es eficiencia, de Sonnet 4.

- Precio: 1 $ por 1.000.000 de tokens de entrada y 5 $ por 1.000.000 de tokens de salida.

Patrones de uso:

- Baja latencia: asistentes conversacionales, agentes de soporte, herramientas de navegador, autocompletado, pair programming.

- Orquestación: Sonnet 4.5 para planificación multi-paso y Haiku 4.5 para ejecución paralela de subtareas, maximizando velocidad y coste.

- Sustitución progresiva: donde Haiku 3.5 se quede corto y Sonnet sea “excesivo”, Haiku 4.5 puede ocupar el punto óptimo.

Implicaciones para empresas y equipos técnicos

- Unit economics mejorados. El binomio velocidad+coste permite subir el listón de lo que merece automatizar: más flujos pasan el corte de ROI.

- Experiencia de desarrollador más fluida. En IDE y terminal, menos latencia significa más iteraciones por hora y mejor flow.

- Arquitecturas agent-first. La combinación planificador (Sonnet 4.5) + ejecutores (Haiku 4.5) habilita pipelines robustos sin penalizaciones de retardo.

- Gobernanza y safety. La etiqueta ASL-2 y la system card facilitan análisis de riesgo y procesos de adopción en sectores sensibles.

Conclusión: velocidad y coste al servicio de la adopción

La foto que deja Claude Haiku 4.5 es la de una generación de modelos “rápidos e inteligentes” donde el compromiso clásico entre calidad y eficiencia se difumina. Si Sonnet 4.5 marca el techo, Haiku 4.5 ocupa el punto de máximo rendimiento por euro para llevar IA a producción en tareas cotidianas: desde el navegador hasta la atención al cliente, pasando por desarrollo y automatización de procesos. Con precio agresivo y latencia baja, el modelo apunta a convertirse en el caballo de batalla de la casa.

Preguntas frecuentes

¿Cuál es el precio de Claude Haiku 4.5 por millón de tokens y cómo se compara con otros modelos?

El precio anunciado es de 1 $ por 1.000.000 de tokens de entrada y 5 $ por 1.000.000 de tokens de salida. La propuesta de valor está en ofrecer rendimiento cercano a modelos de frontera con coste sensiblemente menor y latencia más baja, lo que mejora la economía de casos de uso con muchas llamadas por minuto.

¿En qué se diferencia Claude Haiku 4.5 de Claude Sonnet 4.5 y cuándo elegir cada uno?

Sonnet 4.5 es el modelo de referencia para los casos de mayor complejidad y razonamiento. Haiku 4.5 se orienta a baja latencia y eficiencia con rendimiento casi de frontera en coding y agentes. Un patrón recomendado es usar Sonnet 4.5 para planificación multi-paso y Haiku 4.5 para ejecución de subtareas en paralelo.

¿Cómo usar Claude Haiku 4.5 en Amazon Bedrock o Google Vertex AI?

El modelo está disponible desde hoy en ambas plataformas como opción de despliegue y puede actuar como sustituto directo de Haiku 3.5 (y, en escenarios de eficiencia, de Sonnet 4). Para desarrolladores, el acceso por API utiliza el identificador claude-haiku-4-5.

¿Qué significa que Claude Haiku 4.5 esté clasificado como ASL-2?

La etiqueta AI Safety Level 2 (ASL-2) indica que, tras pruebas internas, se estiman riesgos limitados en ámbitos sensibles (p. ej., CBRN). Además, en evaluaciones automáticas de alineamiento presentó menor tasa de comportamientos desalineados que Sonnet 4.5 y Opus 4.1. La system card del modelo detalla estas pruebas de seguridad y su racional.

vía: anthropic.com