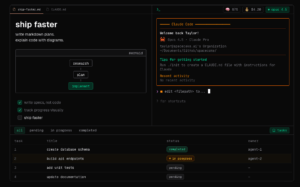

Spacecake: una app open source que convierte Claude Code en un “estudio” para trabajar con agentes

La popularidad de los asistentes de programación en modo CLI (línea de comandos) está disparando un patrón repetido en muchos equipos: un terminal por un lado, un editor por otro, notas en Markdown en otra ventana, y un “plan” de tareas que acaba siendo una lista en cualquier sitio menos donde se ejecuta el trabajo. En ese hueco es donde