NVIDIA ha anunciado hoy la disponibilidad general de Gemma 3n en las plataformas NVIDIA RTX y Jetson. Gemma, que fue presentada en vista previa por Google DeepMind durante el evento Google I/O el mes pasado, incorpora dos nuevos modelos optimizados para su implementación en dispositivos multimodales.

La versión actual de Gemma incluye ahora capacidades de audio, sumándose a las funciones de texto y visión introducidas en la versión 3.5. Cada componente utiliza modelos de investigación confiables: el modelo de habla universal para audio, MobileNet v4 para visión y MatFormer para texto.

El avance más significativo es una innovación llamada Per-Lay Embeddings, que permite una reducción considerable en el uso de RAM para los parámetros. El modelo Gemma 3n E4B cuenta con 8 mil millones de parámetros en bruto, pero puede operar utilizando una huella de memoria dinámica comparable a un modelo de 4 mil millones. Esto permite a los desarrolladores utilizar un modelo de mayor calidad en entornos con recursos limitados.

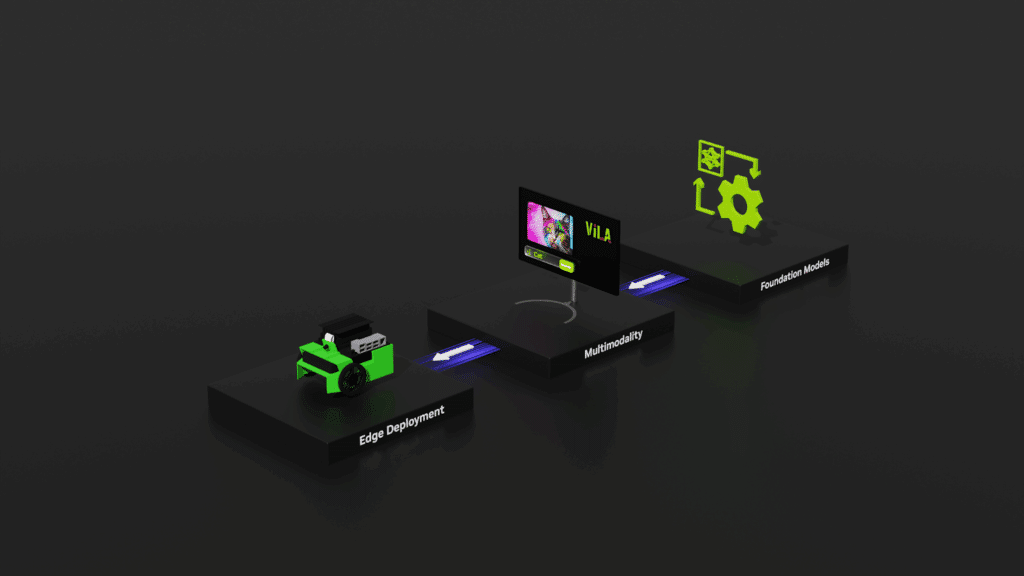

La familia de modelos Gemma funciona eficazmente en dispositivos NVIDIA Jetson, diseñados para potenciar aplicaciones de vanguardia, como la robótica de última generación. La arquitectura ligera y el uso dinámico de la memoria se adecuan a entornos con recursos limitados.

Desarrolladores en la plataforma Jetson pueden participar en el Desafío de Impacto Gemma 3n organizado en Kaggle. El objetivo es utilizar esta tecnología para crear cambios positivos en el mundo en ámbitos como la accesibilidad, la educación, la salud, la sostenibilidad ambiental y la respuesta a crisis. Se ofrecen varios premios en efectivo, a partir de los 10,000 dólares, para las mejores propuestas.

Por otro lado, los desarrolladores que utilizan NVIDIA RTX en PCs con Windows y los entusiastas de la IA pueden desplegar fácilmente los modelos Gemma 3n utilizando Ollama. Los modelos Gemma 3n con aceleraciones RTX están disponibles para su uso en aplicaciones populares como AnythingLLM y LM Studio.

NVIDIA también colabora con Ollama para proporcionar optimizaciones de rendimiento para GPUs NVIDIA RTX, acelerando modelos como Gemma 3n. Esto se logra aprovechando el motor de Ollama, que se basa en la biblioteca GGML, para maximizar el rendimiento en GPUs NVIDIA RTX.

Para personalizar Gemma con datos específicos, los desarrolladores pueden utilizar el Gemma 3n desde Hugging Face con el marco abierto NVIDIA NeMo. Este proporciona un flujo de trabajo integral, cubriendo la preparación de datos, ajuste eficiente y evaluación del modelo.

NVIDIA reafirma su compromiso con el ecosistema de código abierto, promoviendo modelos abiertos como Gemma que fomentan la transparencia en la IA y permiten compartir y colaborar ampliamente en pro de la seguridad y resiliencia en la IA.

Fuente: Zona de blogs y prensa de Nvidia