La compañía presenta MedGemma 27B Multimodal y MedSigLIP, modelos diseñados para transformar el desarrollo de IA en el ámbito médico, con enfoque en privacidad, eficiencia y adaptabilidad.

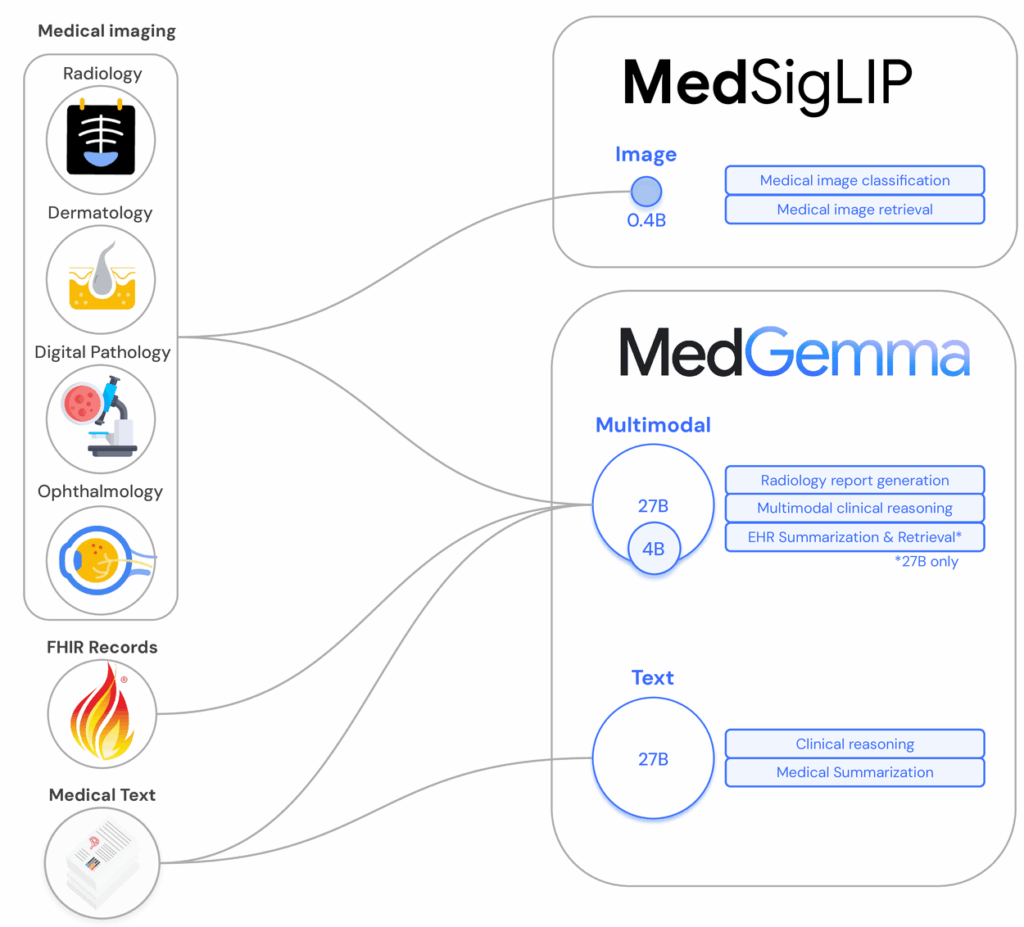

Google ha dado un paso significativo en el impulso de la inteligencia artificial aplicada a la salud con el lanzamiento de dos nuevos modelos dentro de su colección Health AI Developer Foundations (HAI-DEF): MedGemma 27B Multimodal y MedSigLIP. Ambos modelos están diseñados como herramientas abiertas para investigadores y desarrolladores que buscan soluciones avanzadas, seguras y eficientes en ámbitos como el diagnóstico, la clasificación de imágenes médicas o la generación de informes clínicos.

Modelos generativos y multimodales para tareas médicas complejas

La familia MedGemma, basada en la arquitectura Gemma 3, incorpora ahora variantes de 4.000 y 27.000 millones de parámetros con capacidad para procesar texto e imagen. El modelo MedGemma 4B Multimodal alcanza un 64,4 % en la evaluación MedQA, posicionándose como uno de los mejores modelos abiertos de pequeño tamaño. En una prueba no ciega, un 81 % de los informes de rayos X generados por MedGemma fueron considerados clínicamente viables por un radiólogo certificado en EE.UU.

Por su parte, MedGemma 27B Text logra un 87,7 % en MedQA, a solo tres puntos del modelo líder DeepSeek R1, pero con un coste de inferencia diez veces menor. La versión multimodal de 27B añade además capacidades para interpretar historiales médicos electrónicos longitudinales, siendo competitiva incluso frente a modelos más grandes en tareas de recuperación y análisis de datos clínicos.

MedSigLIP: un encoder ligero para imágenes médicas

El segundo lanzamiento, MedSigLIP, es un encoder de imagen de solo 400 millones de parámetros, entrenado sobre diversas modalidades médicas como radiografías torácicas, imágenes histopatológicas, dermatológicas y de fondo de ojo. Basado en la arquitectura SigLIP, este modelo permite codificar imágenes y texto en un espacio de representación común, ideal para clasificación, recuperación semántica y tareas “zero-shot”.

MedSigLIP demuestra rendimientos similares o superiores a modelos específicos por tarea, pero con una versatilidad notable en diferentes dominios médicos. Además, puede ejecutarse en una sola GPU o incluso en hardware móvil, lo que amplía considerablemente su adopción en entornos clínicos o de investigación con recursos limitados.

Privacidad, control y reproducibilidad: ventajas de los modelos abiertos

A diferencia de las soluciones basadas en API, los modelos MedGemma y MedSigLIP pueden ejecutarse en entornos locales o en la nube de Google, lo que otorga mayor control sobre la privacidad de los datos y el cumplimiento de las normativas institucionales. Al tratarse de modelos abiertos, sus parámetros permanecen congelados, lo que garantiza estabilidad y reproducibilidad, un aspecto crucial en el entorno sanitario.

También se facilita la personalización: los desarrolladores pueden afinar los modelos para adaptarlos a tareas o conjuntos de datos específicos. Por ejemplo, MedGemma 4B, tras un proceso de fine-tuning, ha alcanzado un RadGraph F1 de 30,3 en generación de informes de rayos X, demostrando su capacidad de mejora orientada a aplicaciones reales.

Casos de uso: de la India a Taiwán, pasando por EE.UU.

Los modelos ya han empezado a ser adoptados en distintos entornos clínicos. En EE.UU., la empresa DeepHealth está utilizando MedSigLIP para mejorar la priorización de radiografías de tórax y la detección de nódulos. En Taiwán, investigadores del hospital Chang Gung han comprobado que MedGemma funciona bien con literatura médica en chino tradicional, respondiendo eficazmente a consultas del personal sanitario. Por su parte, la startup india Tap Health ha destacado la sensibilidad clínica del modelo al resumir notas de evolución o sugerir acciones según guías médicas.

Accesibilidad y recursos disponibles

Google ha publicado cuadernos detallados en GitHub para facilitar la implementación y el ajuste fino de los modelos en la plataforma Hugging Face. También se incluyen ejemplos de despliegue en Vertex AI y un nuevo demo en la colección HAI-DEF que muestra cómo integrar MedGemma en la recogida de información previa a una cita médica.

Los modelos están disponibles en formato safetensors y su documentación técnica completa se encuentra en el informe MedGemma Technical Report.

Una base sólida, no una solución clínica directa

Desde Google se subraya que tanto MedGemma como MedSigLIP están concebidos como puntos de partida para el desarrollo de soluciones sanitarias, y no deben utilizarse sin validación o adaptación adecuada. Aunque ofrecen buenos resultados en pruebas como MedQA o RadGraph, no sustituyen el juicio clínico ni están destinados a informar decisiones diagnósticas o terapéuticas de forma directa. Todos los outputs generados requieren verificación independiente, correlación clínica y validación metodológica adicional.

Conclusión

Con la publicación de MedGemma y MedSigLIP, Google refuerza su apuesta por una inteligencia artificial sanitaria abierta, responsable y al servicio de la comunidad investigadora. Estos modelos no solo ofrecen rendimiento competitivo frente a modelos privativos de gran escala, sino que también permiten preservar la privacidad, garantizar la trazabilidad y fomentar la innovación clínica desde la base.

vía: research.google