La startup estadounidense Groq, fundada en 2016, ha irrumpido en el mundo de la inteligencia artificial con el desarrollo de una innovadora unidad de procesamiento de lenguaje (LPU) que promete superar las capacidades de los tradicionales GPU de Nvidia. Esta tecnología emergente ha captado la atención en los últimos meses gracias a su capacidad para generar contenido de forma inmediata, un avance crucial en el ámbito de la IA generativa.

Un Avance Crucial en la IA Generativa

Groq ha diseñado las LPU, o unidades de procesamiento de lenguaje, con el objetivo de reducir la latencia y aumentar el rendimiento de datos en comparación con los GPU. Estas unidades están específicamente concebidas para la inferencia de modelos de inteligencia artificial con miles de millones de parámetros, tales como los desarrollados por OpenAI y Mistral AI. La capacidad de las LPU para generar cientos de palabras por segundo es un hito que podría transformar la manera en que interactuamos con la IA.

Jonathan Ross, fundador de Groq y exingeniero de Google, subraya la importancia de la velocidad en la experiencia del usuario: «En dispositivos móviles, la paciencia es limitada. Con Groq, queremos que la interacción con la inteligencia artificial sea casi instantánea, eliminando la sensación de estar conversando con una máquina».

Un Poder de Cómputo sin Precedentes

Una sola LPU de Groq es capaz de realizar un cuatrillón de operaciones por segundo, permitiendo la generación de hasta 400 palabras por segundo, en contraste con las 100 palabras por segundo que alcanzan las mejores GPUs de Nvidia. Este notable rendimiento se logra con un consumo energético significativamente menor, una característica clave en el diseño de las GroqChip.

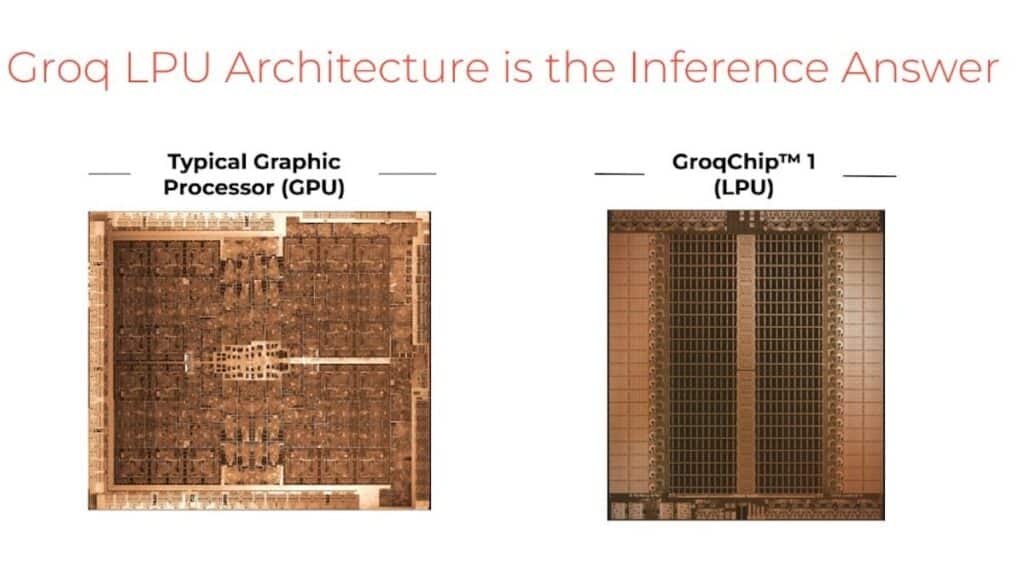

Las GroqChip, fabricadas en 14 nm, están diseñadas para la inferencia y no para el entrenamiento de modelos de IA. Esto las distingue de los GPU, que son más adecuados para las tareas de entrenamiento. Ross explica: «Los GPUs son ideales para el entrenamiento de modelos de IA, pero no están optimizados para ejecutar esos modelos. Nuestra LPU acelera la ejecución de los modelos, permitiendo respuestas en tiempo real cuando se consulta a una IA».

Arquitectura Eficiente y Energéticamente Sostenible

La arquitectura de las LPU de Groq está compuesta por una serie de mini-DSPs (procesadores de señal digital) en serie, optimizando el procesamiento paralelo y reduciendo significativamente el consumo energético. Cada circuito sucesivo tiene una única función, lo que maximiza la eficiencia operativa. Esta configuración permite que las LPU consuman hasta diez veces menos energía que las GPUs tradicionales, un factor crítico en la adopción de soluciones sostenibles en centros de datos.

Groq en el Panorama de la IA

Aunque Groq se posiciona a menudo como un competidor de Nvidia, la startup recalca que sus LPU están optimizadas para la inferencia, no para el entrenamiento. Este enfoque les permite especializarse en ofrecer soluciones que mejoren la velocidad y eficiencia de los modelos de lenguaje una vez entrenados.

La visión de Groq para el futuro de la IA es ambiciosa. La compañía busca establecer un nuevo estándar en la experiencia de usuario con inferencias de baja latencia y entrega en tiempo real, todo en un paquete energéticamente eficiente. Con oficinas en Palo Alto y Tel Aviv, Groq está en una posición ideal para atraer a los mejores talentos técnicos y seguir innovando en el campo de la inteligencia artificial.

Conclusión

El avance de Groq en el desarrollo de las LPU representa un salto significativo en la tecnología de inteligencia artificial, permitiendo una generación de contenido casi instantánea y con un consumo energético reducido. Esta innovación no solo promete mejorar la eficiencia y velocidad de la IA generativa, sino también establecer nuevos estándares en la industria, haciendo que la interacción con la IA sea más rápida y accesible que nunca.