OpenAI ha anunciado la llegada de GPT-4o, su modelo insignia que promete revolucionar la interacción humano-computadora al integrar capacidades de razonamiento en tiempo real a través de texto, audio y visión. Esta nueva versión, denominada GPT-4o («o» de «omni»), representa un avance significativo hacia una interacción más natural y fluida con las máquinas.

Innovación en Multimodalidad

GPT-4o se distingue por aceptar y generar combinaciones de texto, audio e imagen, permitiendo respuestas rápidas y precisas. Con tiempos de respuesta de audio tan bajos como 232 milisegundos y un promedio de 320 milisegundos, iguala el desempeño de GPT-4 Turbo en texto en inglés y código, y muestra mejoras notables en otros idiomas. Además, es un 50% más económico y considerablemente más rápido en la API.

Antes de GPT-4o, el Modo de Voz de ChatGPT presentaba latencias de 2.8 segundos con GPT-3.5 y de 5.4 segundos con GPT-4. Esta configuración utilizaba tres modelos separados para transcribir, procesar y convertir el texto de vuelta a audio, lo cual limitaba la capacidad del modelo para captar y expresar matices como el tono o las emociones. GPT-4o, al ser un modelo entrenado de extremo a extremo, procesa todas las entradas y salidas con la misma red neuronal, abriendo nuevas posibilidades para la comprensión y generación multimodal.

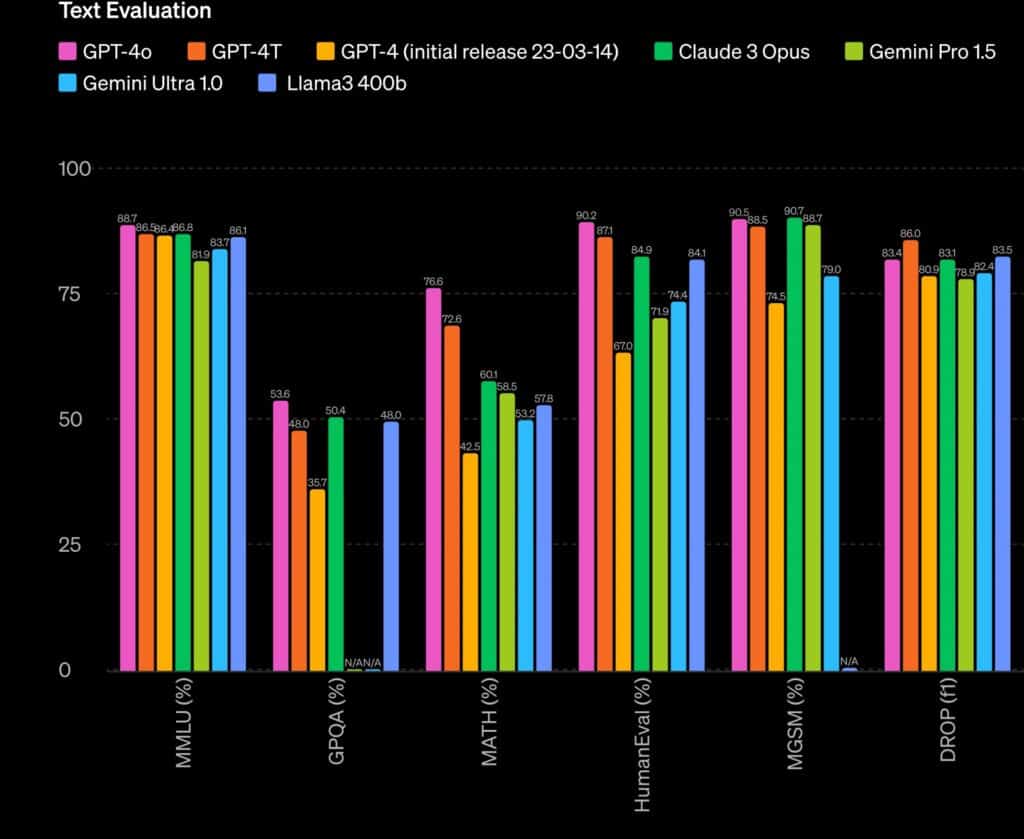

Evaluaciones del Modelo

GPT-4o ha demostrado un rendimiento equiparable al de GPT-4 Turbo en inteligencia textual, de razonamiento y codificación, y ha establecido nuevos estándares en capacidades multilingües, auditivas y de visión. En el benchmark 0-shot COT MMLU, alcanzó un puntaje récord de 88.7%, y en el 5-shot no-CoT MMLU, logró un 87.2%.

En términos de reconocimiento de voz, GPT-4o supera significativamente a Whisper-v3 en todos los idiomas, especialmente en aquellos con menos recursos. También se destaca en traducción de audio, estableciendo un nuevo estándar en el benchmark MLS. En evaluaciones de comprensión visual, GPT-4o alcanzó un rendimiento de vanguardia en pruebas como MMMU, MathVista y ChartQA.

Seguridad y Limitaciones

GPT-4o incorpora mecanismos de seguridad integrados, como filtrado de datos de entrenamiento y refinamiento post-entrenamiento, para garantizar interacciones seguras a través de todas sus modalidades. Ha sido evaluado según el Marco de Preparación de OpenAI, mostrando un riesgo medio en áreas como ciberseguridad y autonomía del modelo. Se ha sometido a exhaustivas pruebas externas con más de 70 expertos en psicología social, equidad y desinformación, lo que ha permitido identificar y mitigar nuevos riesgos.

Aunque la modalidad de audio presenta riesgos novedosos, OpenAI ha implementado sistemas de seguridad adicionales para controlar las salidas de voz. Inicialmente, solo se lanzarán las capacidades de texto e imagen, mientras que las de audio se introducirán gradualmente con voces preestablecidas y bajo las políticas de seguridad existentes.

Disponibilidad y Futuro

GPT-4o ya está disponible en ChatGPT, tanto en la versión gratuita como en la suscripción Plus, con límites de mensajes significativamente más altos. En las próximas semanas, se lanzará una nueva versión del Modo de Voz en alfa dentro de ChatGPT Plus. Los desarrolladores también pueden acceder a GPT-4o a través de la API, con capacidades de texto y visión, y próximamente, con funcionalidades de audio y video para un grupo selecto de socios.

OpenAI invita a la comunidad a proporcionar retroalimentación para continuar mejorando el modelo y explorar todo su potencial. Con GPT-4o, la empresa da un paso decisivo hacia una interacción humano-computadora más eficiente y natural, marcando un hito en el desarrollo de la inteligencia artificial multimodal.

Más información y ejemplos en video en OpenAI.