A medida que los casos de uso de la inteligencia artificial (IA) continúan ampliándose, los desarrolladores y entusiastas buscan formas más rápidas y flexibles de ejecutar modelos de lenguaje de gran tamaño (LLMs). La ejecución de modelos de manera local en PCs con GPUs NVIDIA GeForce RTX permite una inferencia de alto rendimiento, mayor privacidad de los datos y un total control sobre el despliegue e integración de la IA. Herramientas como LM Studio, que es gratuita para probar, facilitan esta tarea al permitir a los usuarios explorar y construir con LLMs en su propio hardware.

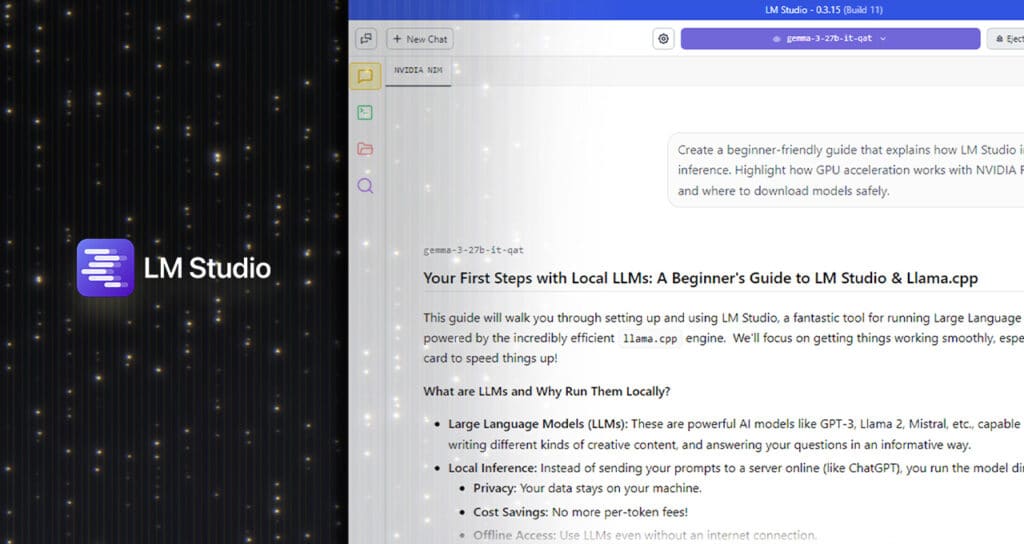

LM Studio se ha convertido en una de las herramientas más adoptadas para la inferencia de LLMs en local. Construida sobre el runtime de alto rendimiento llama.cpp, la aplicación permite que los modelos funcionen completamente sin conexión y también puede servir como puntos finales de API compatibles con OpenAI para su integración en flujos de trabajo personalizados.

La versión más reciente de LM Studio, la 0.3.15, ofrece mejoras significativas en el rendimiento para GPUs RTX gracias a CUDA 12.8, lo que mejora notablemente los tiempos de carga y respuesta de los modelos. La actualización también introduce nuevas funciones orientadas a los desarrolladores, incluido el uso mejorado de herramientas a través del parámetro “tool_choice” y un editor de comandos del sistema rediseñado.

Estas mejoras en LM Studio optimizan su rendimiento y usabilidad, brindando el mayor rendimiento hasta ahora en PCs con IA RTX. Esto se traduce en respuestas más rápidas, interacciones más fluidas y mejores herramientas para construir e integrar IA localmente.

LM Studio está diseñado para la flexibilidad y es adecuado tanto para la experimentación casual como para la integración total en flujos de trabajo personalizados. Los usuarios pueden interactuar con los modelos a través de una interfaz de chat de escritorio o habilitar el modo de desarrollador para servir puntos finales de API compatibles con OpenAI. Esto facilita la conexión de LLMs locales a flujos de trabajo en aplicaciones como VS Code o agentes de escritorio a medida.

Por ejemplo, LM Studio se puede integrar con Obsidian, una popular aplicación de gestión del conocimiento basada en markdown. Usando complementos desarrollados por la comunidad, como Text Generator y Smart Connections, los usuarios pueden generar contenido, resumir investigaciones y consultar sus propias notas, todo impulsado por LLMs locales que funcionan a través de LM Studio.

La actualización 0.3.15 agrega nuevas capacidades para desarrolladores, incluido un control más granular sobre el uso de herramientas a través del parámetro “tool_choice» y un editor de comandos del sistema mejorado para manejar comandos más largos o complejos. El parámetro “tool_choice” permite a los desarrolladores controlar cómo los modelos interactúan con herramientas externas, lo que aporta flexibilidad adicional para crear interacciones estructuradas o flujos de trabajo de generación aumentada por recuperación (RAG).

LM Studio admite una amplia gama de modelos abiertos, incluidos Gemma, Llama 3, Mistral y Orca, y una variedad de formatos de cuantización, desde 4 bits hasta precisión completa. Entre los casos de uso más comunes se incluyen RAG, chat de múltiples turnos con ventanas de contexto largas, preguntas y respuestas basadas en documentos y flujos de trabajo de agentes locales. Al utilizar servidores de inferencia locales potenciados por la biblioteca de software llama.cpp acelerada por RTX de NVIDIA, los usuarios en PCs con IA RTX pueden integrar LLMs locales con facilidad.

En el núcleo de la aceleración de LM Studio se encuentra llama.cpp, un runtime de código abierto diseñado para una inferencia eficiente en hardware de consumo. NVIDIA se asoció con las comunidades de LM Studio y llama.cpp para integrar varias mejoras que maximizan el rendimiento de las GPUs RTX. Estos avances ofrecen una inferencia más fluida y tiempos de respuesta más rápidos en toda la gama de PCs con IA RTX, desde portátiles ligeros hasta desktops y estaciones de trabajo de alto rendimiento.

LM Studio es gratuito para descargar y funciona en Windows, macOS y Linux. Con el lanzamiento más reciente y las optimizaciones continuas, los usuarios pueden esperar mejoras continuas en rendimiento, personalización y usabilidad, haciendo que la IA local sea más rápida, flexible y accesible. Para comenzar rápidamente, los usuarios pueden descargar la última versión de LM Studio y abrir la aplicación, seguir una serie de pasos sencillos para configurar el entorno y comenzar a disfrutar de las capacidades mejoradas de IA en su propio equipo.

Los usuarios pueden mantenerse informados suscribiéndose al boletín de noticias de RTX AI PC y siguiendo a NVIDIA Workstation en plataformas como LinkedIn y X.

Fuente: Zona de blogs y prensa de Nvidia