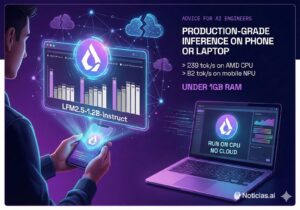

Google convierte a Gemini en un asistente “con memoria”: así funciona Personal Intelligence y por qué reabre el debate sobre privacidad

Google ha dado un paso relevante en la carrera por los asistentes de Inteligencia Artificial “personalizados”. La compañía ha presentado Personal Intelligence, una función en fase beta que permite a Gemini conectarse a aplicaciones y servicios de Google para responder con más contexto: desde localizar un dato concreto en Gmail hasta aprovechar señales de actividad en YouTube o en servicios