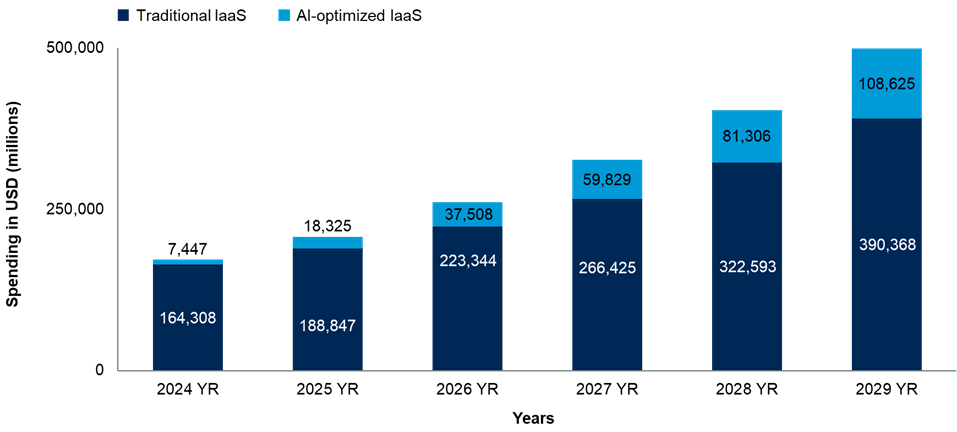

La era del “IaaS genérico” tiene fecha de caducidad. Según Gartner, el IaaS optimizado para IA —infraestructura como servicio con GPU, TPU y ASICs de IA, redes de alta velocidad y almacenamiento optimizado— está emergiendo como la siguiente ola de crecimiento del cloud. El gasto de usuarios finales alcanzará 18.300 millones de dólares en 2025 y 37.500 millones en 2026, con un salto del 146 % hasta finales de 2025. La consultora añade un giro clave: la inferencia superará al entrenamiento como fuerza dominante del gasto ya en 2026, representando el 55 % del total y superando el 65 % en 2029.

El mensaje es contundente: las organizaciones que amplían el uso de IA y GenAI necesitan infraestructura especializada —GPUs/TPUs/ASICs, interconexión de baja latencia, almacenamiento paralelo— porque el IaaS basado en CPU no cubre por sí solo las demandas de procesamiento masivamente paralelo y movimiento rápido de datos.

Por qué la inferencia desbanca al entrenamiento

Gartner proyecta que el gasto en inferencia pase de 9.200 M$ en 2025 a 20.600 M$ en 2026. A diferencia del entrenamiento —intenso pero acotado a ciclos de desarrollo y refresh de modelos—, la inferencia ocurre de forma continua, impulsando aplicaciones en tiempo real: chatbots, recomendadores, detección de fraude, asistentes de productividad, o casos verticales (salud, industria, comercio). Ese patrón convierte la inferencia en carga persistente y, a escala, en el principal consumidor de IaaS optimizado para IA.

En paralelo, aparecen dos tendencias:

- Modelos más eficientes y afinados para dominios concretos, que desplazan parte del gasto desde el entrenamiento de foundational models hacia inferencia distribuida en producción.

- Descentralización: inferencia que se mueve de grandes clusters a regiones múltiples, borde (edge) o zonas de baja latencia, obligando a ampliar la base instalada de aceleradores y redes rápidas.

Qué cambia para el cloud (y por qué el IaaS “CPU-first” se queda corto)

La “canasta” tecnológica del IaaS optimizado para IA no es solo más GPU. Gartner enfatiza un tridente:

- Aceleradores (GPU/TPU/ASIC) con alto throughput y memoria de gran ancho de banda.

- Redes de baja latencia y alto biseccionamiento (NVLink/NVSwitch, InfiniBand, Ethernet acelerado, RDMA), fundamentales para paralelizar y mover datos entre nodos.

- Almacenamiento y cachés optimizados para E/S paralela (picos de lectura/escritura, sharding eficiente, prefetching), que eviten que la GPU quede ociosa esperando datos.

En este contexto, las instancias de propósito general basadas en CPU no desaparecen, pero no lideran el rendimiento/coste en IA generativa y analítica de nueva generación. Para workloads exigentes, el diseño fin a fin (acelerador + red + almacenamiento) es lo que marca la diferencia.

Implicaciones prácticas para CIOs y responsables de plataforma

1) La capacidad de inferencia será tu nueva “energía base”

Si GenAI se integra en frontends, backends y flujos operativos, la inferencia deja de ser “proyecto” para convertirse en carga permanente. Eso requiere reservas (commitments), autoscaling más fino, SLA específicos y observabilidad por cola/modelo.

2) Capex vs. Opex: el tablero cambia cada trimestre

La presión de demanda en GPUs y aceleradores puede tensionar precios y disponibilidad. Combina reservas multianuales para carga estable con capacidad bajo demanda para picos. Introduce FinOps de IA (coste por mil tokens, coste por inferencia, throughput por dólar) en tu scorecard.

3) Datos cerca del cómputo

Latencia y throughput matan a la inferencia si el dato está lejos. Prioriza caches calientes, lakes particionados por zona, replicación geográfica y feature stores próximos a los clústeres de IA. Cuantifica el coste del data egress y la amortización de mover conjuntos grandes a regiones “GPU-rich”.

4) Estandarización de stacks

Evita snowflakes. Define plantillas de despliegue (tipos de acelerador, tamaños de pod, drivers, bibliotecas CUDA/ROCm/OneAPI, versiones de runtimes), pipelines MLOps portables y modelos empaquetados con sus dependencias (contenedores multi-arch, wheels reproducibles).

5) Seguridad y cumplimiento para IA

Segmenta por proyecto y modelo, cifra en tránsito (RDMA seguro donde aplique) y en reposo, registra trazabilidad de datos usados para prompting y RAG, y aplica guardrails de governance (retención, procedencia, auditoría de consultas).

Para proveedores y hyperscalers: dónde está la ventaja

- Suministro: asegurar volúmenes de GPU/TPU/ASIC y cadenas de memorias HBM es estratégico; la ventana de demanda 2025–2027 será intensa.

- Redes internas: fabrics de alta capacidad, topologías escalables y calidad de servicio coherente entre zonas.

- Servicios gestionados: serverless de inferencia, endpoints multi-región, vector stores y RAG gestionados, gateways de modelos, observabilidad de latencia/coste por token/request.

- Economía de plataforma: empaquetar modelos + datos + MLOps como primitives sencillas para acelerar time-to-value.

¿Qué verticales liderarán el gasto?

- Retail y e-commerce: recomendación, búsqueda semántica, asistentes de compra.

- Servicios financieros: chatops, co-pilots de backoffice, KYC/AML, alerta temprana de fraude.

- Industria: mantenimiento predictivo, copilotos de planta, documentación técnica con RAG.

- Salud: triage asistido, codificación clínica, documentación y resúmenes con guardrails.

- Sector público: atención ciudadana, búsqueda semántica de normativa, copilotos internos.

Todos comparten el patrón: mucha inferencia, SLAs exigentes y sensibilidad a coste por transacción.

Señales de riesgo (y cómo mitigarlas)

- Escasez de aceleradores → mezcla de reservas y bursting multi-región; contempla colocación o clouds especializados.

- Cuellos de E/S → profiling continuo, NVMe locales, caching inteligente y redes adecuadas (evita infra-suscripción).

- Deriva de costes → budgets por servicio/modelo, límites y alerting FinOps; revisa precio por throughput por familia de GPU.

- Bloqueo tecnológico → apoya estándares (OpenAI-compatible APIs, MCP, containers portables), separa capa de orquestación de proveedor.

¿Y el edge?

La inferencia cerca del usuario (puntos de venta, fábricas, retail, telecomunicaciones) crece en relevancia. El edge ofrece latencias sub-20 ms y coste de transporte menor, pero exige operaciones distribuidas, observabilidad unificada y sincronización de prompts, embeddings y artefactos de modelo. Espera que el edge represente una fracción creciente del gasto a medida que copilotos locales y aplicaciones embarcadas se normalicen.

Qué deberían hacer hoy las empresas

- Mapa de casos de uso: prioriza aquellos con ROI claro en 6–12 meses (atención, RAG interno, recomendadores).

- Arquitectura de referencia para inferencia: blueprints de pod (acelerador + red + almacenamiento), deployment multi-región, cachés y feature stores.

- Métricas FinOps específicas: coste por token, por respuesta, por 1000 inferencias; compara horas reservadas vs on-demand.

- Pruebas de carga realistas: benchmarks con datos y prompts reales, medición de P95/P99 y estabilidad en ventanas largas.

Preguntas frecuentes

¿Qué diferencia al IaaS optimizado para IA del IaaS tradicional?

Incorpora aceleradores (GPU/TPU/ASIC), redes de baja latencia y almacenamiento de alto rendimiento pensados para paralelizar entrenamiento e inferencia; el IaaS tradicional, centrado en CPU, no escala igual para IA intensiva.

¿Por qué la inferencia superará al entrenamiento en 2026?

Porque la inferencia se ejecuta continuamente en producción (chatbots, recomendación, fraude, copilotos), mientras que el entrenamiento ocurre en ciclos; al escalar el número de aplicaciones, la inferencia domina el consumo sostenido.

¿Cuánto se gastará en IaaS optimizado para IA?

Gartner estima 18.300 M$ en 2025 y 37.500 M$ en 2026, con la inferencia absorbiendo el 55 % del gasto en 2026 y >65 % en 2029.

¿Cómo controlo costes de inferencia en la nube?

Combina reservas para cargas estables con capacidad bajo demanda para picos, aplica FinOps por modelo/servicio (coste por token/respuesta), optimiza cachés y colocación de datos para reducir latencia y egress, y vigila P95/P99 junto a coste por transacción.

Fuente: comunicado de Gartner “AI-Optimized IaaS Is Poised to Become the Next Growth Engine for AI Infrastructure” (octubre de 2025), con previsiones de gasto 2025–2026 y reparto por inferencia y entrenamiento.

vía: gartner